我们目前所处的第四次工业革命,正在通过部署各种新兴技术来变革所有行业。系统现在能够通过共享设备、机器和工厂信息来连接万物。工厂环境中的智能设备能够独立管理制造过程。传感器数据涉及制造环境中的方方面面,是关键信息的一个重要来源。然后,这一信息发送到更高级的决策系统。本文将提供一些使用智能传感器的最新应用,其系统架构示例遵循智能工厂的IIoT方法。

工厂车间中,材料和货物需要迅速移动,而且要在正确的时间到达正确的地点。过去这需要人工完成,也许工人们会开着小电动车在工厂快速搬运各种所需的物料。而今天,我们可以借助技术,通过AGV来自动运送这些材料。

为了成功、轻松地实现这一切,我们需要将工厂车间正确映射到中央计算机系统中。实现这种解决方案的一种方法,是在地板路径中嵌入射频识别(RFID)技术,这样AGV就可以做出路线决策,并识别材料的最终位置。

使用Android app并结合蓝牙通信来控制这些AGV“机器人”,是一种行之有效的解决方案。将RFID用于路线导引,由于其可以采集智能工厂物流的实时数据,因此非常适合工业4.0应用。

AGV可配备传感器和执行器,以及处理器和通信系统。路径规划算法在这个过程中非常重要——因为有许多车辆穿梭于工厂车间,所以需要用算法来执行防撞功能。

在这种工厂环境中,RFID就类似于AGV的“地图”或“室内GPS”。工厂车间的地板上嵌入了微小的标签,而在AGV底部则配有标签阅读器。由于这些RFID标签本质上是无源的,因此它们不需要任何类型的电源供电。阅读器中的发射器会发出RF信号激活标签,而使其将信息发送回AGV。标签也不需要视线,这在恶劣的工厂环境中非常有用(图1)。

图1:嵌入RFID标签的仿真工厂车间。(图片来自参考文献《Automatic Logistics in a Smart Factory using RFID-enabled AGVs》)

图1所示的测试系统工作频率为13.56MHz。AGV将在所选区域停下,以仿真拾取或放下材料或产品。本示例中是用一部Android手机来充当中央处理单元和控制中心。

图2:AGV及其传感器。(图片来源同图1)

系统包含一个中央处理器(在Android手机中),用于控制关键决策。通信方面设计了一个app,通过蓝牙来与3个AGV进行通信。AGV提供的信号可确定它们在工厂车间的位置,处理器还向AGV发送信号,告知其下一步工作。AGV底部的红外传感器可帮助AGV沿着配有RFID标签的轨道行进。AGV前面还有一个声纳传感器,可检测前方的物体而避免碰撞(图2)。欲了解更多的详情,请参见《Automatic Logistics in a Smart Factory using RFID-enabled AGVs》。

机器人可在工业4.0生产区域甚至仓储设施中执行各种任务。我们可以在固定位置配备立体摄像头,并使用带有激光测距仪(防撞用)的移动平台,通过传感器数据融合来实现动态物体跟踪。机器人和人类需要高效安全地共存与工作。

系统需要能避免目标跟踪过程出现中断。一种解决方案是为移动机器人提供当前的地图、监视数据访问和额外的传感器,而作为现有基础设施的一部分。5G和自动驾驶汽车研究会使用V2X技术,这也提供了一种可能的解决方案。本文仅探讨使用立体视觉RGB-D(深度传感器)摄像头的低成本简单技术,它可以通过传感器数据融合来改进对象跟踪的深度检测。由于无源深度检测方法对光照变化比较敏感,这里选择使用激光雷达作为传感器融合的一部分。

参考文献《Sensor Data Fusion of LIDAR with Stereo RGB-D Camera for Object Tracking》采用的设计架构包含快照检测与跟踪,其中每个传感器的数据都会转换到坐标系(见图3)。

图3:该系统使用两个模块:3D处理用于对象检测,以及贝叶斯滤波用于目标的信息融合与跟踪。(图片来自参考文献《Sensor Data Fusion of LIDAR with Stereo RGB-D Camera for Object Tracking》)

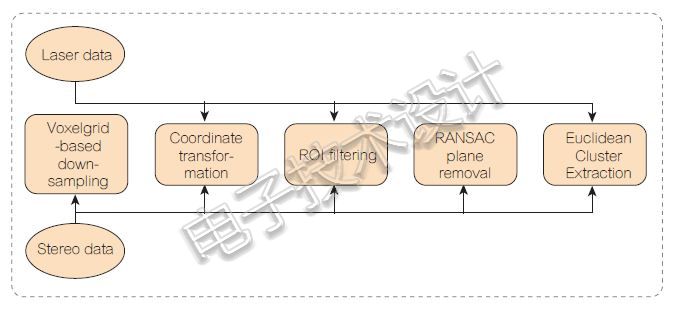

然后还需进一步处理(图4)。请注意,并非每个传感器都会经历所有这些处理步骤。此外,由于嵌入式计算机的处理能力有限,立体摄像头的点云数据需要下采样。该系统采用体素栅格(空间中的一组3D小箱)方法来保存点云分布。

图4:快照检测框图。(图片来源同图3)

据发现,激光雷达路径中的临时阻塞或中断所引起的轨道丢失,可以通过使用辅助立体测量进行防止。虽然摄像头不太准确,但其所处的高位置和扩展的视场角提供了好处。立体摄像头既经济实惠又功能强大,当把它们集成进基础设施时,可以在复杂的机器人应用中提供实时概况。

为了为智能工厂提供机器人系统以处理复杂的装配任务,我们必须具有创造性,并使用我们可随意支配的最先进的架构。例如,下面的多模式接口就采用了新颖的视觉显示技术,并增加了独特的语音指令以及良好的物料流程管理。

该设计架构结合使用了半镀银镜子与人脸跟踪系统——可检测人类用户与3D物体成像之间的复杂交互。这是通过工作台中的位置传感器完成的,它可以精确跟踪标记,为要选择的装配件提供确切的位置信息。增强装配(AA)这个术语意味着在装配过程中直接应用AR,即实际环境通过虚拟对象增强,并逐渐接近最终的装配过程。这样便可最终提高操作员的组装效率和便易性。这种系统可以将待组装的实际部件与带有虚拟元素及其扩展交互性的反馈结合起来。

我们现在可以预见用户所实时看到的一系列装配步骤的可视化有多直接,从而可以消除装配过程中的误差。同时,它还可以给用户提供音频反馈,从而提供有关正确装配程序的额外指导。

人们通过视觉方式可以感知80%以上的周围环境,因此,如果我们可以通过虚拟现实(VR)和AR系统改造人类视觉体验,那么这就会大大增强用户对于装配过程的视觉和视觉显示数据。必须注意不要让操作员的眼睛感到紧张——容易引起眼睛疲劳的有LCD透视面板,或者在操作员的视场角(FOV)范围内将图像投影到专用玻璃上。使用这些设备,操作员在查看实际的装配物件时需要不停地在屏幕和物件之间来回变焦。

我们需要建立一系列逻辑算法,从而确保能够完美跟踪工作环境中的真实对象。随着这种位置的变化,必须将计算机的虚拟数据与摄像头所捕捉的真实环境信息融合在一起。在显示器上进行可视化改变后,这一步可以分成两组可能的跟踪。

对于第一种类型,必须配合使用计算机视觉和传感器跟踪来连续跟踪用户在空间中的位置。在第二种类型中,所用的方法是目前可用且最广泛使用的方法,即对独特图案的几何特性或特征进行精确定义,然后也对其进行跟踪,并在视频镜头中进行识别。基于标记跟踪的检测为将计算机生成的虚拟数据与摄像头采集的图像信息合并提供了最简单的替代方案。

ARToolKit在这类应用中随处可见,而且对于本文开发的这种用于提高装配效率的过程来说是开源的。ARToolKit库脚本提供了(工作台上)对象位置变化的光学跟踪与来自硬件传感器的比特率的互连(图5)。

图5:控制单元与系统中其他组件互连的框图。Blender app是款免费的开源3D创作套件。它支持完整的3D流水线——建模、绑定、动画、仿真、渲染、合成、运动跟踪,甚至视频编辑和游戏创作。(图片来自参考文献《An Integrated Working Environment Using Advanced Augmented Reality Techniques》)

一种新的可视化方法是采用特殊玻璃来实现,这种玻璃的表面为半镀银或涂有半透(反射)薄膜,这样就可以达到所需的反射性。它还使设计人员可以深入了解工作环境,而不会对图像质量造成任何影响。显示过程就是简单地将图像反向投影到一个反射平面上——该平面由置于工作区上方和设计者视角以外的LCD监视器来提供。

在实现这一新的可视化之后,发现了一个严重的缺陷。反光玻璃上所显示的图片位置固定,其质量仅位于顶视水平。因此,如果设计者的观察角度固定,并且在将复合层放置在基体上时没有改变他的观察位置,那他就不能很好地看到它。这种糟糕的观测情况可以通过在Blender系统所设计的应用中添加用户人脸跟踪脚本来解决,这个系统所用的库和软件元素来自OpenCV开源数据库。

因此,本质上,在制造过程中,系统在安装过程中不但为设计者提供了视觉元素帮助,而且还提供了一个音轨补充——它根据数据表信息自动生成和控制,并带有表征输入元素的数值。整个过程是同步的,这样,每当有安装部件改变时,系统就会读取新的位置和方向信息,同时还会设置新的音轨及相应的命令。这些数据是以短信息和哔哔声或复杂的口头指令生成,它们存储在单独的控制音频信号和指令段中。

工厂环境中通常使用电机夹具来处理各种材料。当组装过程中涉及有柔软、易碎的材料时,需要采用别的方法来尽可能提高优质成品的产量。

Soft Robotics公司源自Case Western大学的生物启发式机器人(Biologically Inspired Robotics)项目。该公司开发出了基于弹性体的软指机构,并采用手势控制,用来作为夹持机构(参考文献《The Development of a Gesture Controlled Soft Robot Gripping Mechanism》)。在实际的机器人应用中,软性机器人的设计涉及执行器设计、传感器和控制等。设计人员遵循拟人化建模来模拟人类的手部技能和功能。George Whitesides是最先在美国国防高级研究计划局(DARPA)的资助下,为手术工具进步设计出优秀的解决方案,进而实现出软性机器人功能的。

夹持机构采用气动式的聚合物“手指”设计,能够抓住具有复杂形状、尺寸和重量的物体。最初的研究工作是由麻省理工学院、哈佛大学、首尔国立大学和DARPA合作完成,他们开发出了能够模拟蚯蚓移动的“网眼蠕虫(Meshworm)”。

人机接口(HMI)是机器人控制的一个关键方面。Shadow Robot公司的Dexterous Hand(灵巧手)即是一种控制输入,此外还有其他各种手势控制设计。

Soft Robotics的夹持手指采用两部分硅橡胶和3D打印模具Elastosil M4601制造而成。该公司设计了一个气动控制板,通过使用柔性传感器输入来控制软性机器人手指的形状。这个设计结合软件控制变量和参数集成了手势控制。软性机器人的执行是通过气罐产生的压缩空气经过微型隔膜气动泵和电气动电磁阀来实现的。电气动电磁阀使用Arduino板和USB串行通信接口通过MOSFET驱动器模块进行控制。

它采用Leap Motion公司的控制器和处理集成开发环境(IDE)来跟踪三根手指和手腕,从而通过气动控制板来控制软指(图6)。使用柔性传感器可以获得软指弯曲度的反馈信息。手势和软指通过Arduino控制器连接。测试时连接了三根软指,分别用来模拟人手的拇指、食指和中指。该系统对食指、中指和拇指以及手腕的笛卡尔坐标(即X、Y和Z值)进行了跟踪,然后通过矢量加法,就获得了腕部到指尖的参数。

Leap Motion控制器对操作员手部运动的坐标变化进行精确的跟踪和监控,并将其显示在临近的屏幕上。然后,软性机器人手臂通过其弹性体手指重现由人手完成的相同移动。

最终的设计能够模拟手指,但还需要更多微调才能应用于复杂地方。

图6:Leap Motion控制器提取人手手掌和手指动作的所需数据示意。处理软件能够检测、提取数据、识别并做出决策以及其他输出控制。(图片来自参考文献《The Development of a Gesture Controlled Soft Robot Gripping Mechanism》)

这一应用的主要要求是要检测指尖并通过仅跟踪中指、食指和拇指的移动来提取位置、方向和速度数据。处理框架将跟踪到的指尖和手腕重现为方形对象和圆形对象。食指用于为机器人提取位置、方向和速度数据。然后,Leap Motion控制器坐标系对每个指尖和手腕绘制四个矢量。这样就可得到手腕与每个指尖距离的关系,即变量K(更多细节请见《The Development of a Gesture Controlled Soft Robot Gripping Mechanism》)。

接下来就是开发气动控制板(图7)。

图7:带血压计的气动控制板将手掌和手指压力转换为电信号,并通过差分放大器将信号输出。(图片来源同图6)

压力传感器可以测量很大范围的压力值。它采用5VDC供电,输出信号为0-25mV。由于输出信号的强度不足以与Arduino连接,因此还需要采用差分放大器电路将0-25mV到200mV输入放大到3.5VDC输出摆幅。

除了智能工厂的IIoT外,这个设计的新应用还包括医疗、军事和农业等领域。

本节将介绍用于智能工厂环境中机器人激光焊接技术的视觉系统方法。目标是通过一个连续调整激光功率、速度和聚焦能力的系统来实现有保证的焊接质量。设计架构遵循IIoT技术,它嵌入了视觉,采用了基于边缘的分析,执行器将由视觉系统直接驱动——这种无延迟的传输架构可实现互连,并能对多个去本地化单元进行远程控制。

在现代焊接中,闭环控制在智能过程中起着至关重要的作用。它可以实现高质量的焊接和安全性,并缩短良好焊接所需的时间。为了实现这些目标,需要对熔池进行连续监测,以便实现对激光功率、透镜聚焦、焊头速度和相对焊接接头的位置等进行最优准时变动。

成功的视觉系统架构需要在机器人机械臂上安装一个光学头,用以捕获与焊头同轴的场景。系统将通过摄像头捕获图像,并通过两个不同的链路对其进行分析。前者(称为焊缝跟踪,SeaT)对焊接接头进行跟踪,并且需要保证焊接激光器保持在相对于两个接头的最佳位置。后者(称为小孔监视器,KeyM)用于监控熔池,并反馈有关焊接过程质量的信息。这种架构遵循IIoT方法,它嵌入了视觉,采用了基于边缘的分析,执行器将由视觉系统直接驱动——这种无延迟的传输架构可实现互连,并能对多个去本地化单元进行远程控制。

我们来看一下系统硬件(图8)。

图8:光学头布局示意(见左图)及安装在机器人手臂上的焊头(见右图)。(图片来自参考文献《In-line monitoring of laser welding using a smart vision system》)

摄像头连接到CompactRIO控制器,该控制器可以实现机器视觉嵌入、运动控制系统和工业I/O控制器(图9)。

图9:系统架构。(图片来源同图8)

摄像头将捕获的图像发送到CompactRIO,用于实现快速的本地分析、信号处理以及硬件算法加速。然后其将视觉输出发送到ABB机器人,用于执行运动轨迹;并发送到光学头控制器,用于实现激光焊接参数的闭环。CompactRIO还连接到一台上位机,用于图像存储和进一步的数据分析。这个架构是开放的,可以让中央单元远程监控多个焊接站,并存储每个焊接站的数据以用于进一步分析。

SeaT的作用是确保在整个焊接过程中将激光头锁定在接头上的位置。摄像头与激光头同轴安装,而使接头可见,这样系统可使激光器与焊接头的中心始终保持对齐。

KeyM过程用来检测不完整的小孔熔透,以防止非最佳焊接。

整个系统架构遵循IIoT方法,其视觉单元完全集成到通信基础设施中。这样用单个中央单元即可远程并行监控多个焊接单元。将大量的可用图像与相应的分析结果相结合,就可以利用神经网络算法开发针对小孔监控的机器学习方法。

本文为《电子技术设计》2019年2月刊杂志文章。

最前沿的电子设计资讯

最前沿的电子设计资讯