AMiner 选取情感计算领域国内专家学者绘制了学者国内分布地图,如下图所示。通过下图我们可以发现,京津地区在情感计算领域的人才数量最多,东部及南部沿海地区的也有较多的人才分布,相比之下,内陆地区信情感计算领域人才较为匮乏,这也从一定程度上说明了情感计算领域的发展与该地区的地理位置和经济水平都是息息相关的。同时,通过观察中国周边国家的学者数量情况,特别是与日本、东南亚等亚洲国家相比,中国在情感计算领域顶尖学者数量方面具有较为明显的优势。 图 8 是我国情感计算领域顶尖学者最多的 10 个省份。

情感计算国内学者分布

情感计算学者分布国内省份 TOP10

近年来, Picard 领导的美国麻省理工学院多媒体实验室相继提出了近 50 种情感计算应用项目。例如,将情感计算应用于医疗康复,协助自闭症者,识别其情感变化,理解患者的行为;在教育中应用情感计算,实现对学习状态的采集及分析,指导教学内容的选择及教学进度进行;还可以将情感计算应用于生活中,计算机能够感知用户对音乐的喜好, 根据对情感反应的理解判断,为用户提供更感兴趣的音乐播放等。

在美国,公立学校的预算限制引发大规模的教师裁员和教室拥挤不堪。教师工作时间紧张,还要考虑和满足每个学生的需求。结果就是,那些课业困难的孩子容易受到忽视。因为只要孩子不提出问题,老师就不会关注到他。

在过去三年里,有企业把面部识别技术应用到了第一线教学当中。在 SensorStar 实验室,他们用相机捕捉学生上课反应,并且输入到计算机里面,运用算法来确定学生注意力是否转移。通过面部识别软件 EngageSense,计算机能够测量微笑、皱眉和声音来测定学生课堂参与度。孩子们的眼睛是专注于老师的吗? 他们是在思考还是发呆?他们是微笑还是皱着眉头?或者他们只是觉得困惑?还是无聊?测量之后,老师将会收到一份反馈报告,基于面部分析, 报告会告诉老师他们的学生学习兴趣何时最高、何时最低。这样,老师能够对自己的教学方案做出调整,满足更多学生的需求。此外,比尔和梅林达盖茨基金会资助了传感器手镯(sensor bracelets)的开发,这可以用来追踪学生的参与水平。腕部设备能够发送小电流,通过在神经系统响应刺激时测量电荷的细微变化便可以得知学生的课程兴奋程度。

心理学家 Paul Ekman 将面部识别技术研究提升到了一个新的层次。他对 5000 多种面部运动进行了分类,以帮助识别人类情绪。他的研究为 Emotient Inc、 Affectiva Inc 和 Eyeris 等公司提供了帮助,这些公司将心理学和数据挖掘相结合,检测人的细微表情,并对人的反应进行分类。目前为止,面部识别技术的重点是协助联邦执法和市场调研。不过,圣地亚哥市的研究人员也在医疗行业试用这项技术,测定孩子接受外科手术之后的疼痛程度。

TechCrunch 公司的员工设计了在线教育平台,来提供一对一指导和精熟学习( masterylearning)。这是应用创新型思维,通过实时的评估和定制化的学习方式,有效地解决本杰明提出的著名的“Sigma 2 Problem” 。深度学习系统将学生学习效果数据进行分类,并且在此基础上制定相关的教学内容。该系统还可以推荐附加练习,并且根据学生个人能力和教学要求,实时推荐课程内容,调整教学速度 。

北卡罗来纳州州立大学研究员开发了一种软件,通过摄像头捕捉和分析学生面部表情,以此改变在线课程。 目前,大多数情感计算技术还仅仅停留在学术研究领域。 但也已经有公司开

始应用这项技术,并能成功地分辨学生表情,并根据他们的学习能力和方式,来自动调整适合的学习内容和环境。英特尔公司正是这其中的一员。有了这些学生表情数据,可以让“Emoshape”这样的情感计算智能系统,自动分析情感,并做出适当回复。这些系统具备了解决个体问题的能力,也使老师能够提供高度个性化的内容来激发学生的学习兴趣。

人工智能和大数据已经促成了大部分行业的技术革新,从电子商务到交通、金融、医疗。人工智能和大数据已经在教育方面取得进展。 尽管有些反对的声音,比如说如何保护学生隐私、如何提高教学效率等, 但需要指出的是,这些技术的应用并不是要代替老师,而是扮演辅助老师的角色,识别学生的个体需求,以制定更加智能的教学方案。

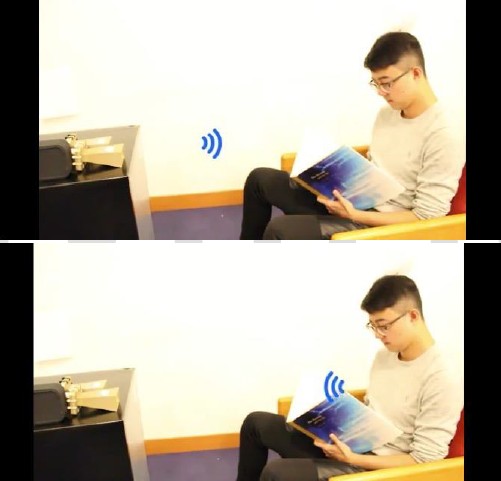

为了深度挖掘人类情感的奥秘, 美国麻省理工学院计算机科学与人工智能实验室打造了用无线信号监测情绪的 EQ-Radio。在没有身体感应器和面部识别软件辅助的情况下, EQ-Radio通过测量呼吸和心跳的微小变化, 利用无线信号捕捉到一些肉眼不一定能察觉的人类行为,判断一个人到底处于以下四种情绪中的哪一种:激动、开心、生气或者忧伤,正确率高达 87%。美国麻省理工学院教授和该项目的负责人 Dina Katabi 预测,这个系统会被运用于娱乐、消费者行为和健康护理等方面:电影工作室和广告公司也可以用这个系统来测试观众实时的反应;而在智能家居的环境中,该系统可以通过捕捉与人的心情有关的信息,调节室内温度,或者建议你应该呼吸一些新鲜空气。

现有的情绪监控方法大多依赖于视听设备或者是安装在人身上的感应器,这两种技术都有缺点:面部表情并不一定符合内心状态,而安装在身上的感应器(比如胸带和心电监护仪)会造成各种不便,而且一旦它们的位置稍微移动,监测到的数据就不精确了。

EQ-Radio 会发送能监测生理信息的无线信号,该信号最终会反馈给设备本身。其中的算法可以分析心跳之间的微小变化,从而判断人们的情绪。消极情绪会被判定为“忧伤” , 而正面 且高涨的情绪会被判定为“激动” 。尽管这样的测量会因人而异,但其中还是有内在统一性。通过了解人们处于不同的情绪状态下,他们的心跳会如何变化,我们就可以对他所处的情绪状态进行有效的判断。

在他们设计的实验中,参与实验者选择他们记忆中最能代表激动、开心、生气、忧伤以及毫无情感的一段视频或音乐。在掌握了这段时长两分钟的视频里的五种情绪设置后, EQ-Radio可以精确地通过一个人的行为判断他处于这四种情绪中的哪一种。与微软研发的基于视觉和面部表情的 Emotion API 相比, EQ-Radio 在识别喜悦、忧伤和愤怒这三个情绪上精确度更高。同时,这两种系统在判断中性情绪时的精准度差不多,因为毫无情绪的脸总是更容易被识别。

目前,对美国麻省理工学院计算机科学与人工智能实验室而言,最艰巨的任务就是摆脱不相关数据的干扰。比如,为了分析心率,他们要抑制呼吸可能带来的影响,因为呼吸时,人的肺部起伏比他心跳时的心脏起伏要大。

EQ-Radio 无线信号监测

近年来,情感计算运用于自闭症治疗得到越来越多的关注。例如, 美国麻省理工学院情感计算团队正在开发世界上第一个可穿戴的情感计算技术设备:一个具有社交智能的假肢,用来实时检测自闭症儿童的情感, 帮助机器人使用自闭症儿童独有的数据, 来评估这些互动过程中每个孩子的参与度和兴趣。 这个装置用一个小型照相机,分析孩子的面部表情和头部运动来推断他们的认知情感状态。还有一种叫“galvactivator” 的工具,通过测量穿戴者的皮肤电流数据,推断孩子的兴奋程度。这个像手套一样的设备可以利用发光二极管描绘出人体生理机能亢奋程度的图谱。这种可视化的展现方式,能够清晰地展示出人的认知情感水平。 NAO 机器人和个性化的机器学习在治疗自闭症患者上也表现出很大的优越性:

NAO机器人

人类治疗师会向孩子展示一张照片或者闪存卡片,用来表示不同的情绪,以教会他们如何识别恐惧、 悲伤或喜悦的表情。治疗师随后对机器人进行编程, 向孩子们展示这些相同的情绪,并且在孩子与机器人交往时观察孩子。孩子们的行为提供了宝贵的反馈信息,机器人和治疗师可以根据反馈信息继续学习。

研究人员在这项研究中使用了 SoftBank Robotics NAO 类人机器人。 NAO 将近 2 英尺高,类似于装甲超级英雄,通过改变眼睛的颜色、 肢体的运动以及声音的音调来表达不同的情绪。参加这项研究的 35 名自闭症儿童中,有 17 人来自日本, 18 人来自塞尔维亚,年龄从 3 岁到 13岁不等。他们在 35 分钟的会议中以各种方式对机器人做出反应,从看起来无聊和困倦,到在房间里兴奋地跳来跳去,拍手,大笑或触摸机器人。研究中的大多数孩子对机器人的看法是,它不仅仅是一个玩具,应该尊重 NAO,因为它是一个真实的人。另外,人类用许多不同的方式改变自己的表情,但机器人则通过同样的方式来改变表情,这对孩子来说更加有利,因为孩子可以通过非常有条理的方式学习如何表达表情 。

最前沿的电子设计资讯

最前沿的电子设计资讯