当地时间4月4日,谷歌研究人员在线发表一篇论文《TPU v4:用于机器学习的光学可重构超级计算机,硬件支持嵌入》,首次公布了谷歌用于训练人工智能模型的超级计算机的技术细节,并宣称该系统比英伟达的超算系统更快且功耗更低。

据EDN小编了解,其实早在2020年谷歌就在其数据中心上部署了当时最强的AI芯片TPU v4,TPU v4超级计算机也早已被全球领先的AI团队积极使用,用于跨语言模型、推荐系统及生成AI的前沿ML研究和生产工作负载。而直到本周的4月4日,谷歌才首次对外界公布了这台AI超算的技术细节。

据悉,谷歌张量处理器(tensor processing unit,TPU)是该公司为机器学习定制的专用芯片(ASIC),第一代发布于2016年,成为了AlphaGo背后的算力来源。与GPU相比,TPU采用低精度计算,在几乎不影响深度学习处理效果的前提下大幅降低了功耗、加快运算速度。同时,TPU 使用了脉动阵列等设计来优化矩阵乘法与卷积运算。

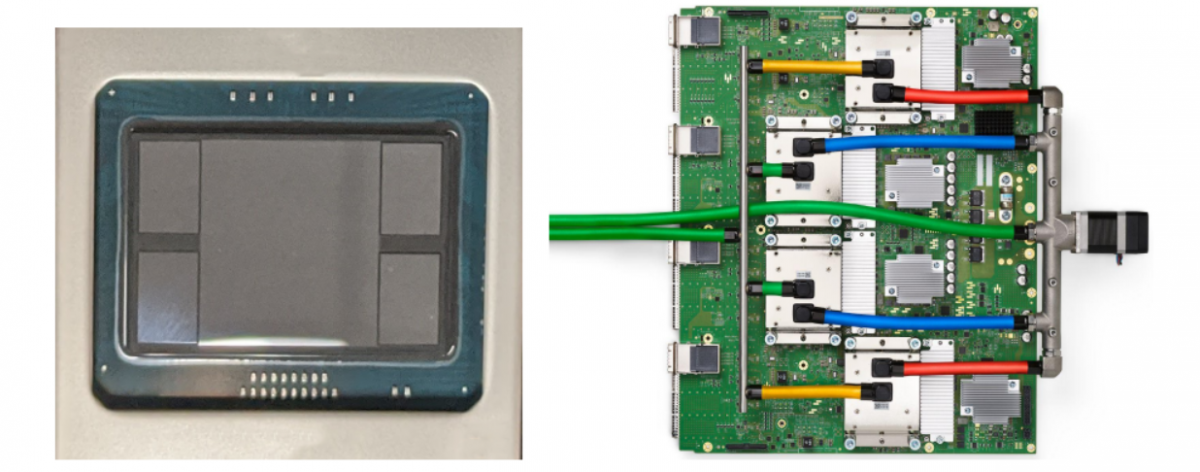

TPU v4(中间的ASIC加上4个HBM堆栈)和带有4个液冷封装的PCB

与TPU v3一样,每个TPU v4包含有两个TensorCore(TC)。每个TC包含四个128x128矩阵乘法单元(MXU),一个具有128个通道(每个通道16个ALU),以及16 MiB向量存储器(VMEM)的向量处理单元(VPU)。两个TC共享一个128 MiB的公共存储器(CMEM)。但相比于TPU v3,TPU v4的性能要高出2.1倍。

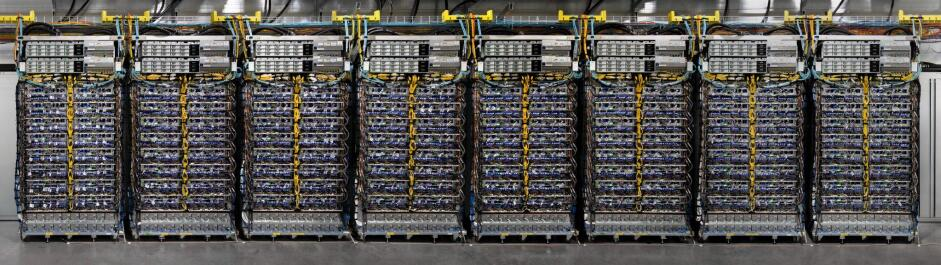

谷歌在论文中表示,目前基于TPU v4的超级计算机拥有4096块芯片,整体速度提高了约10倍。对于同等大小的系统,谷歌能做到比Graphcore IPU Bow快4.3-4.5倍,比Nvidia A100快1.2-1.7倍,功耗低1.3-1.9倍。

八个64芯片机架构成的一台4096芯片超算

根据论文可以看到,谷歌没有将其第四代TPU芯片与英伟达目前最新版的旗舰人工智能GPU芯片H100进行比较,H100拥有800亿个晶体管,并采用更新的N4(4纳米)芯片制造工艺。对此谷歌表示,由于H100是在谷歌芯片推出后使用更新技术制造的,所以没有将其第四代产品与英伟达当前的旗舰H100芯片进行比较。不过谷歌也暗示了,正在开发下一代的TPU,将与H100竞争,但没有提供任何细节。

最前沿的电子设计资讯

最前沿的电子设计资讯