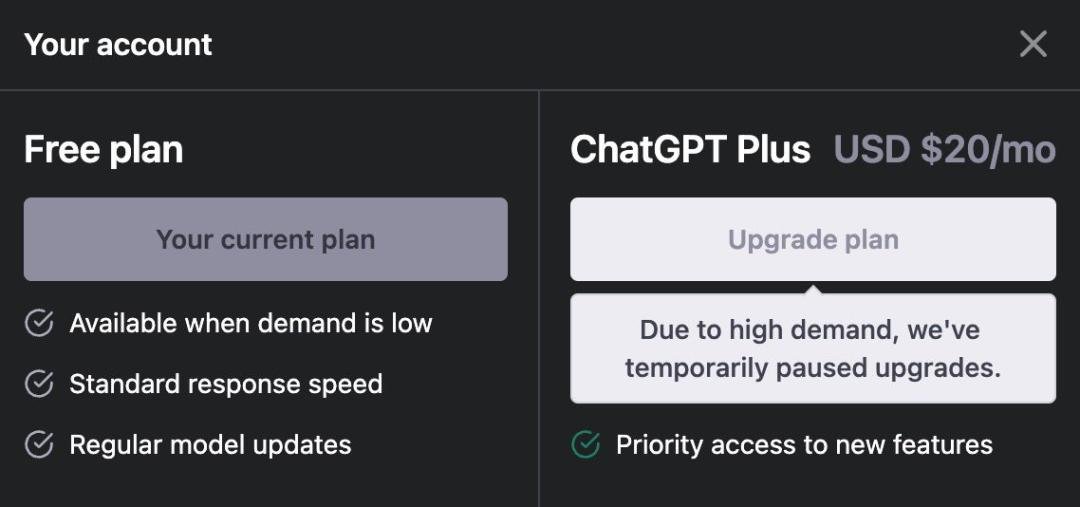

4月5日,ChatGPT官网宣布,由于需求量过大,暂停Plus付费项目的购买。业内推测,这是由于ChatGPT背后的算力资源出现明显缺口,导致OpenAI不得不暂时踩下用户增长的"刹车"。不过4月6日,OpenAI的ChatGPT已经恢复了Plus订阅服务。

网站弹出提示为“由于需求量过大(due to high demand),暂时关闭升级通道”

据官网显示,ChatGPT Plus服务需要每月付费20美元,其服务特权内容包括高峰时期正常访问、更快的响应速度以及优先获取新功能。但实际上自OpenAI推出GPT-4之后,已连续多次下调付费用户访问限制,由第一天的150msg/4hr(每4小时150条消息)到100msg/4hr,然后是50msg/3hr再到最近的25msg/3hr。而在停售Plus事件爆出后,社交平台Reddit上有网友称微软甚至“没有遵守每3小时25条消息的承诺”。

其实在此之前,微软有被爆料过曾专门为ChatGPT砸下数亿美元,打造了一台由上万张英伟达A100组成的专用超算。甚至还专门为此调整了服务器架构,只为给ChatGPT和新必应提供更好的算力。不仅如此,微软还在Azure的60多个数据中心部署了几十万张GPU,用于ChatGPT的推理。但现在看来,价值数亿美元的计算资源似乎还不太够。

作为AI领域的佼佼者ChatGPT自发布以来用户数量快速增长。在庞大用户群涌入的情况下,ChatGPT服务器曾在2天内宕机5次。根据OpenAI的《AI与计算》报告发布的数据,自2012年以来人工智能训练任务中使用的算力呈指数级增长,其增长速度为每3.5个月翻一倍,截至目前人们对算力的需求已增长超过30万倍。

所以算力问题其实算是一个广泛存在的问题,尤其是随着各家大厂的模型预训练、迭代和运营带来更大的算力需求,这也让当前许多公司,尤其是开发大模型的中小型公司,都在担心计算能力不足。AI技术的快速演进需要庞大的算力进行支撑,如果始终得不到满足,作为人工智能的核心要素之一,算力危机势必会成为AI技术发展的瓶颈。

目前根据市场分析数据,在AI大模型方面,英伟达的A100占据了约95%的市场份额,不过算力的突破未必只能寄希望于英伟达。谷歌最近也公布了其用于训练人工智能模型的超级计算机的技术细节,构成该超算的AI芯片TPU v4在性能上完全可以匹敌英伟达的A100,加上存算一体、Chiplet异构集成、CPO(Co-packagedoptics,光电共封装技术)等新技术的不断涌现,相信算力的危机终会得到解决。

最前沿的电子设计资讯

最前沿的电子设计资讯