4月21日,复旦大学自然语言处理实验室开发的新版MOSS模型正式上线,成为国内首个插件增强的开源对话语言模型。目前,MOSS模型已上线开源,相关代码、数据、模型参数在Github和Hugging Face等平台开放,供科研人员下载。

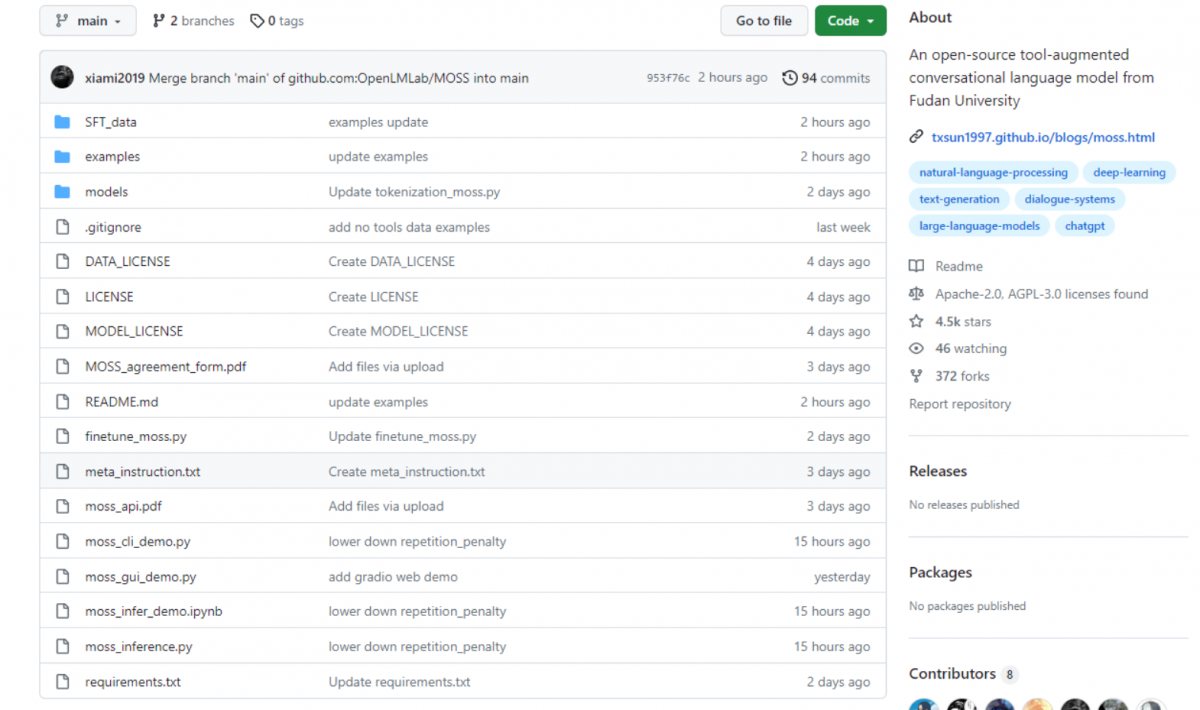

Github开源内容,地址:https://github.com/OpenLMLab/MOSS

MOSS作为一个拥有160亿参数的开源对话语言模型,由约7000亿中英文及代码单词预训练得到,在FP16精度下可在单张A100/A800或两张3090显卡运行,在INT4/8精度下可在单张3090显卡运行。MOSS支持中英双语,拥有多轮对话和使用多种插件双重能力,在MOSS界面,用户可自主添加搜索引擎、图像生成、方程求解器、计算器等外部插件工具。

Moss的架构设计基于Spring Boot Admin 2.1.3版中的spring-boot-admin-server模块二次开发,基于可扩展思想。前端采用Ant Design Pro,采用Spring Boot+shiro+JWT+LDAP实现整个权限认证管理。通过Moss-Cloud-Adapter模块支持多注册中心,应用启动对应用名进行check是否规范。此前,MOSS已经经历了两版迭代,一版是公开邀请内测的MOSS 002版本,另一版是内部测试版本OpenChat 001。今年二月份EDN的“国内首个类ChatGPT模型MOSS内测”相关报道,正是MOSS 002版本。这次MOSS开源的是第三轮迭代版本,名叫MOSS 003。

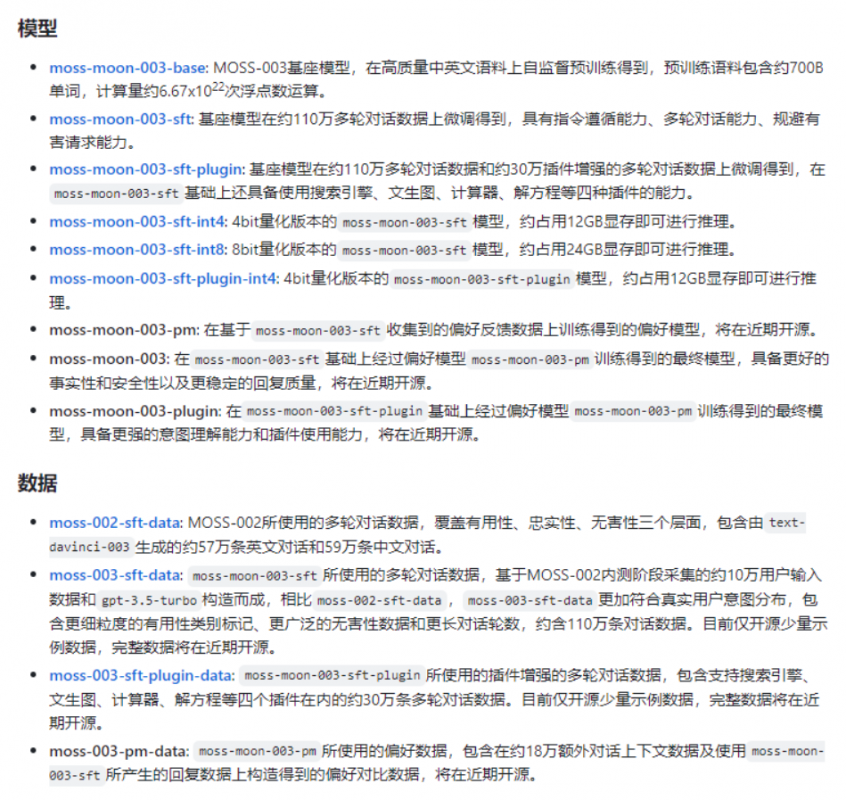

当然,MOSS 003也并非开源了全部模型,目前主要开放的是基座预训练模型,最终模型即将在近期开源。复旦大学计算机科学技术学院教授MOSS系统负责人邱锡鹏表示,未来,MOSS将陆续开源更多训练数据及模型参数,同时也为企业私有化部署人工智能模型、开展相关服务提供解决方案。

最前沿的电子设计资讯

最前沿的电子设计资讯