5月18日,Facebook、WhatsApp 和 Instagram 的所有者 Meta Properties 推出了首款专门为处理人工智能程序而定制的计算机芯片,称为“Meta训练和推理加速器”,(Meta Training and Inference Accelerator,简称 MTIA)。Meta 将MTIA描述为加速 AI 训练和推理工作负载的芯片“家族”的一部分。

这是Meta 的第一款用于运行 AI 模型的定制芯片,并针对其自身的内部工作负载进行了优化。扎克伯格在 Facebook 的一篇帖子中表示,该芯片将做一些事情,比如“为我们的人工智能推荐系统提供动力,帮助找出最好的内容,更快地向你展示。”

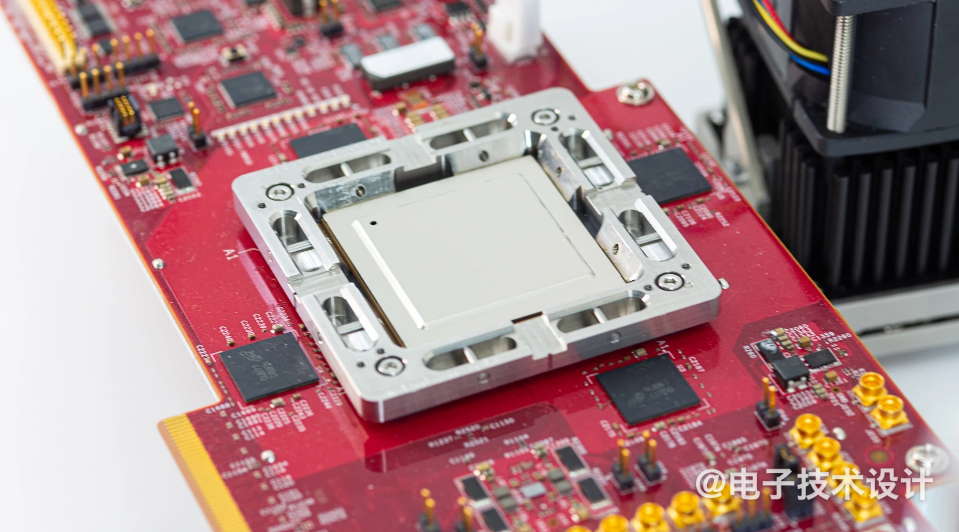

图:专为 AI 工作负载设计的 AI 芯片。来源:Meta

在过去十年左右的时间里,Meta 花费了数十亿美元,招募了顶级数据科学家,并建立了各种新的AI,其中一些AI支撑了自己的引擎、审核过滤器和广告推荐器等。但Meta一直想着把这些AI转化为产品,特别是在生成式AI方面。直到 2022 年,Meta 主要使用 CPU 和专为加速 AI 算法而设计的定制芯片的组,但CPU 在处理AI工作负载时的效率往往低于 GPU。

最近,Meta公司还收购了英国芯片独角兽Graphcore公司的人工智能网络技术的奥斯陆团队。

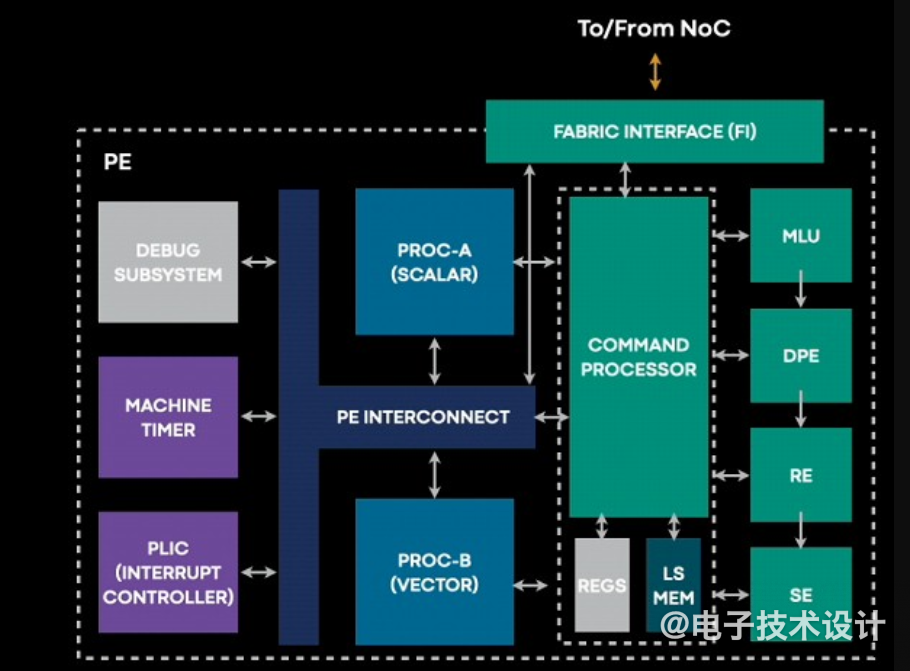

Facebook 在历史上一直是开源软件和硬件的坚定支持者,所以 Meta Platforms 为 MTIA 采用 RISC-V 架构并不让人意外。

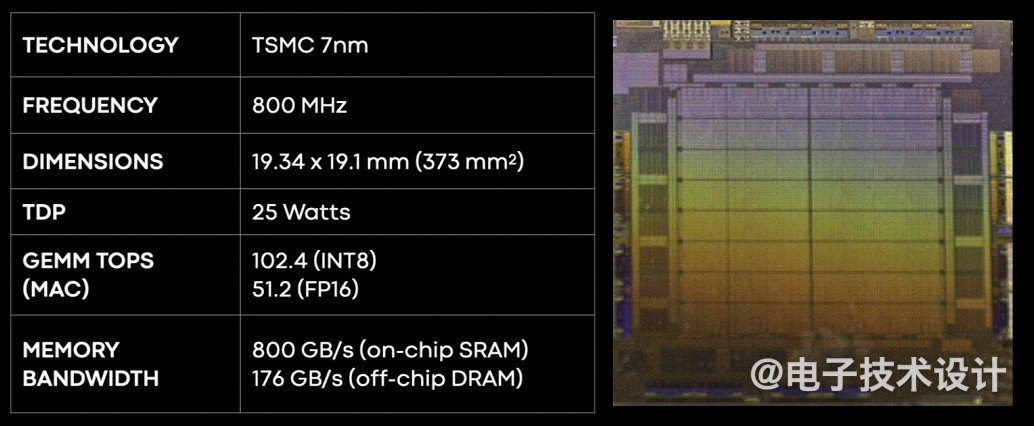

MTIA基于双核 RISC-V,采用台积电7nm工艺,功率25W。

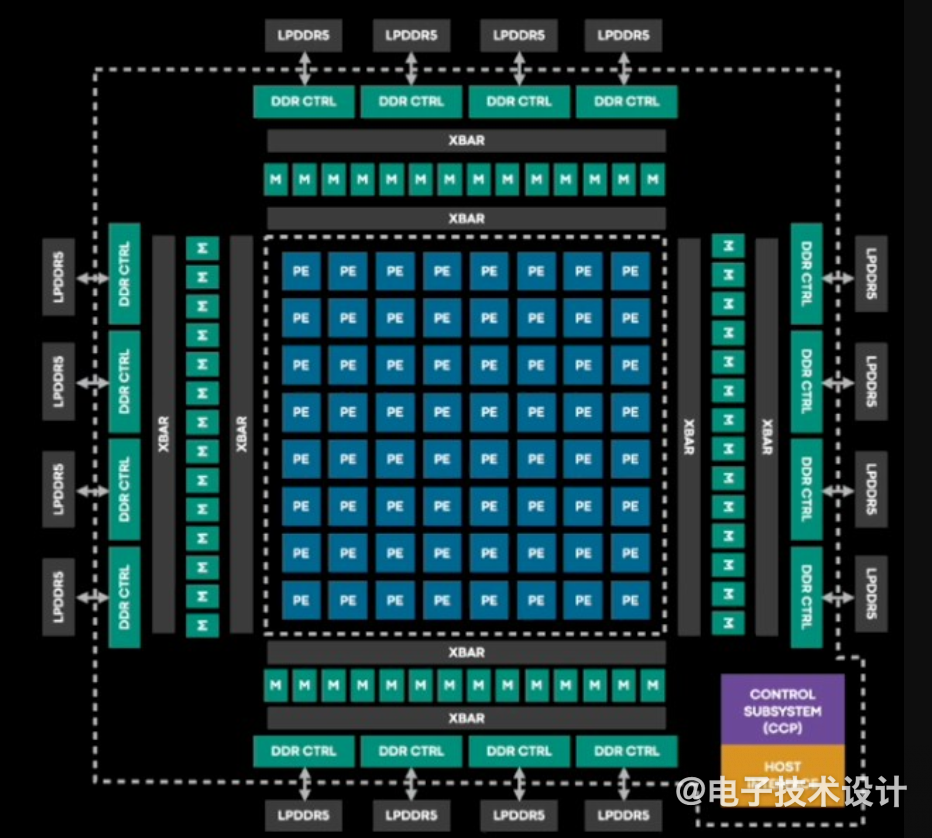

下图中可以看到,MTIA v1 推理芯片内有一个8x8的处理元件网格,通过网状网络连接,这些处理元件周围环绕着 128 MB 的 SRAM 内存,放置在网格的边缘上。外部有 16 个低功耗 DDR5 (LPDDR5) 内存,高达64GB的片外DRAM容量。

两个RISC-V 内核中有一个是带有矢量数学扩展的。

Meta Platforms 工程总监Roman Levenstein 透露,与 GPU 相比,MTIA 在全连接层上的每瓦性能最高可达两倍。

Meta 也表示,就每消耗一瓦能量的每秒浮点运算次数而言,MTIA 芯片的效率最高可达 GPU 的三倍。然而,当芯片负责更复杂的神经网络时,它会落后于 GPU,Meta 说,这表明未来版本的芯片需要做更多的工作来处理复杂的任务。

MTIA 加速器安装在小型双 M.2 板上,可以更轻松地集成到服务器中。这些板使用 PCIe Gen4 x8 链接连接到服务器上的主机 CPU,功耗低至 35 W。

图:带有 MTIA 的样品测试板。

目前,MTIA的重点是推理--而不是训练。

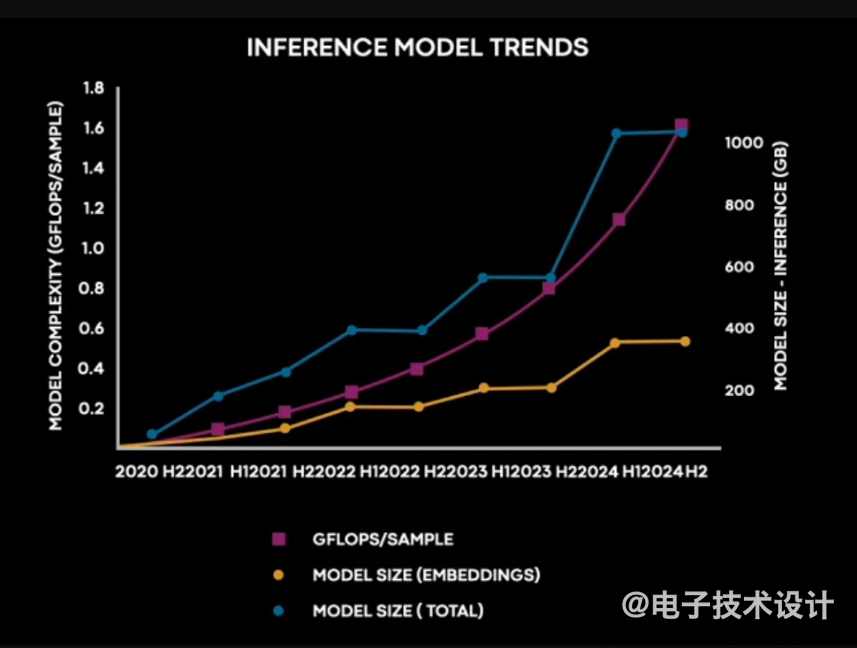

Meta Platforms 的软件工程师 Joel Coburn 在 AI Infra @ Scale 活动中展示下面这张图表,图中展示了Meta的 DLRM 推理模型在过去三年中的规模和计算需求如何增长,以及未来十八个月的成长:

他指出,

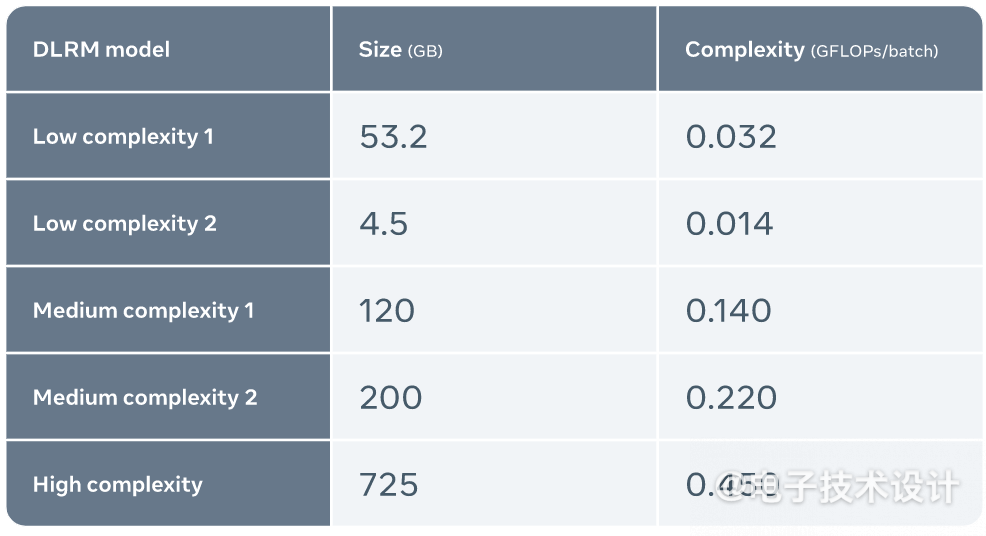

Meta也收集了MTIA 与其他加速器性能的结果。比较基于运行五个不同 DLRM 的端到端性能,代表低到高复杂性的工作负载。

其他科技巨头也都已开启自己的定制 AI 芯片之路:

最前沿的电子设计资讯

最前沿的电子设计资讯