AI浪潮中,整个市场对于算力的巨大需求,让NVIDIA(英伟达)成为了最大受益者,A100等加速卡供不应求。面对如此大的蛋糕,显然其他厂商也不会坐以待毙,作为GPU领域英伟达最有力的竞争者之一,AMD带来了自己的方案。

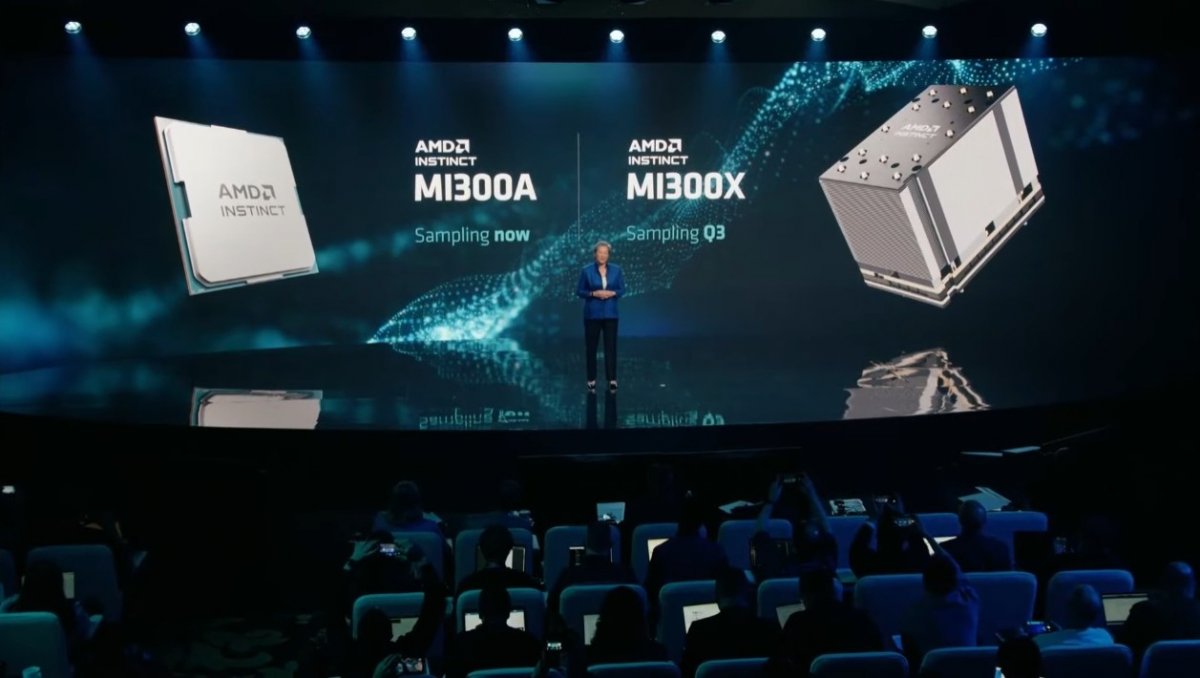

6月13日,AMD举办的“AMD数据中心与人工智能技术首映会”上,公布了外界期待已久的数据中心APU(加速处理器)Instinct MI300的更多细节和更新。

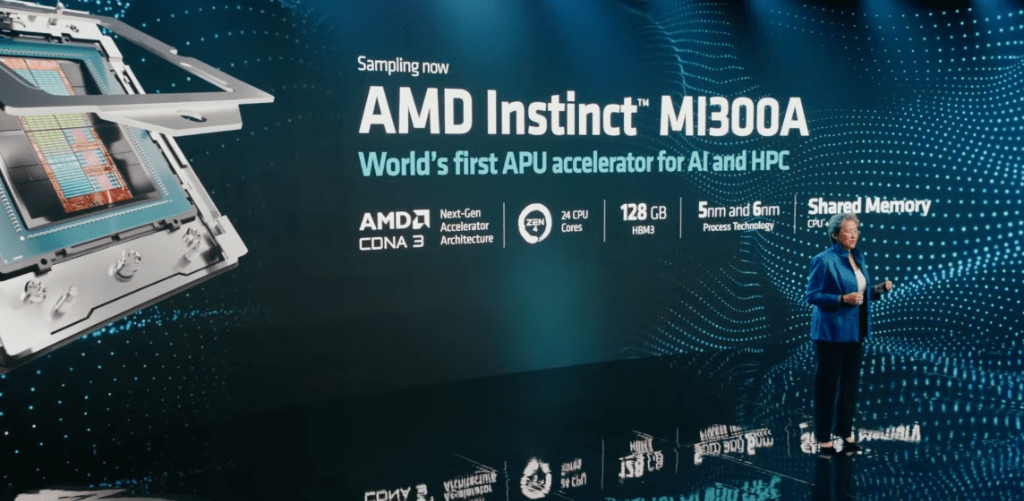

据AMD CEO苏姿丰的介绍,AMD的Instinct MI300A是全球首款针对AI和高性能计算(HPC)的加速处理器,作为市场上首款“CPU+GPU+内存”的一体化产品,MI300A拥有13个小芯片,其晶体管数量高达1460亿个。它采用CDNA 3 GPU架构和24个Zen 4 CPU内核,配置128GB的HBM3内存。相比前代MI250,MI300,在AI上的算力(TFLOPS)预计能提升8倍,能耗性能(TFLOPS/watt)将优化5倍。

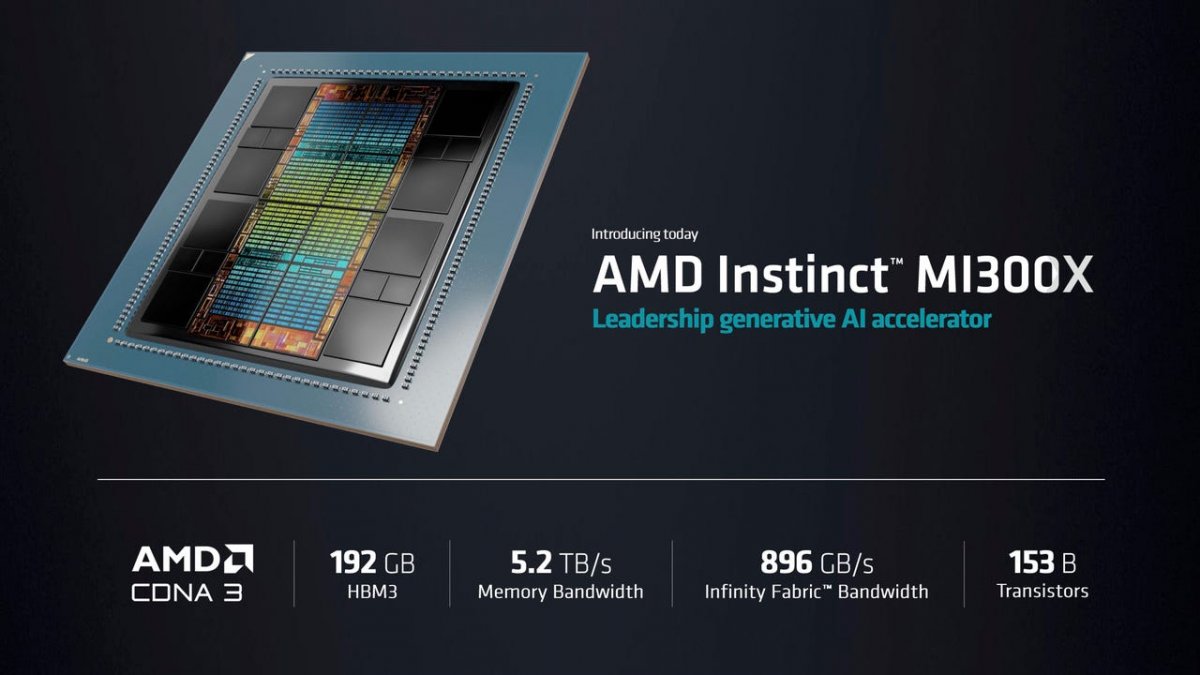

同时,AMD还推出l了一款GPU专用的MI300,即MI300X,该芯片专为大型语言模型和其他尖端AI模型设计,拥有192GB的HBM3内存、5.2TB/秒的带宽和 896GB/s的Infinity Fabric 带宽,晶体管数量达到1530亿个,而目前AI模型常用的英伟达H100仅有800亿个晶体管。

AMD称,MI300X提供的HBM密度最高是英伟达AI芯片H100的2.4倍,其HBM带宽最高是H100的1.6倍。发布会上,苏姿丰以Hugging Face AI模型进行了演示,这个大语言模型在现场写了一首关于旧金山的诗。单个MI300X即可运行一个800亿参数的模型,这是首次在单个GPU上运行这么大的模型。苏姿丰指出,模型尺寸越来越大,你实际上需要多个GPU来运行。随着AMD芯片上内存的增加,开发人员将不需要那么多GPU,可以节省成本。

除了MI300芯片,AMD还发布了AMD Instinct平台,将8个MI300X加速器组合在一个系统中,采用行业标准OCP设计,提供总计1.5TB的HBM3内存。英伟达和谷歌也已经开发出类似系统,将8个或更多GPU组合起来用于AI应用。

据苏姿丰透露,MI300A现已开始提供样品,MI300X和Instinct平台将在今年三季度提供样品,四季度正式推出。

最前沿的电子设计资讯

最前沿的电子设计资讯