7月28日,Google DeepMind宣布以训练AI聊天机器人的方式训练了一款全新的机器人模型Robotic Transformer 2(RT-2),这是一种新颖的视觉-语言-动作(VLA)模型,可以从网络和机器人数据中学习,并将这些知识转化为机器人控制的通用指令。

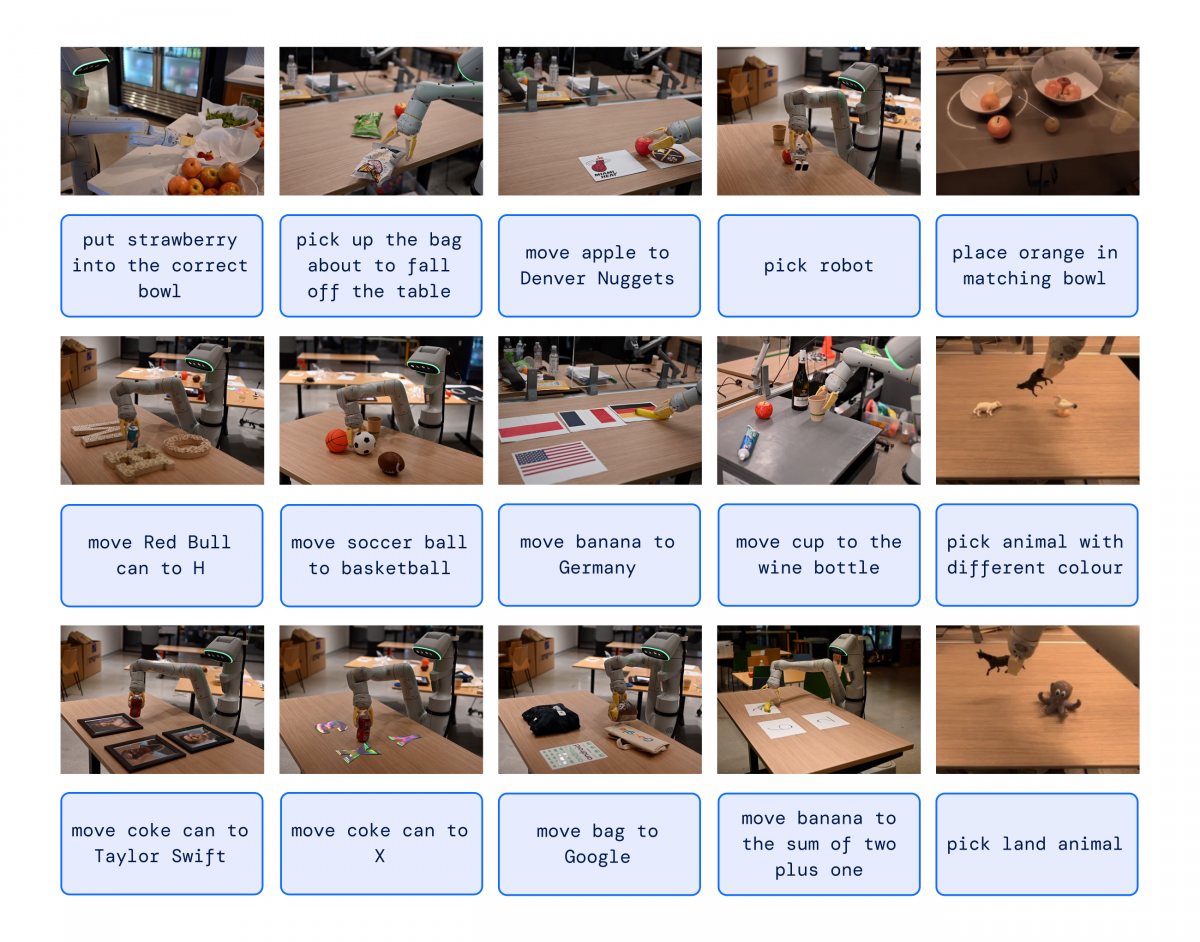

据了解,RT-2机器人项目,是去年年底发布的RT-1的迭代版本,与前代模型相比,这一代模型的泛化能力有所提高,在新的、未见过的任务上表现更好。简单来说,RT-2不但可以理解人类发出的直接指令,还可以对人类的指令进行推理,并将其转变为机器人能理解的控制指令,从而分阶段的完成任务,比如“捡起桌子上快掉下去的袋子”、“将香蕉移动到2加1的总和处”这些指令,RT-2都可以很好的完成。

而RT-2之所以可以顺利的完成这些抽象概念的任务,主要归功于其具备三大能力:符号理解(Symbol understanding)、推理(Reasoning)和人类识别(Human recognition):

根据介绍,在符号理解、推理和人类识别这三个细分能力上,RT-2比RT-1和另一种视觉预训练方法Visual Cortex(VC-1)要好得多,性能最高是其他方法的3倍以上。泛化能力评估上,通过与多个基线模型的多类细分测试,表明RT-2性能提高了大约2倍。同时,研究人员在机器人任务的开源Language Table套件上进行评估,模拟中实现了90%的成功率,高于之前的基线,包括BC-Z(72%)、RT-1(74%)和LAVA(77%)。

最前沿的电子设计资讯

最前沿的电子设计资讯