人工智能(AI)技术正在给人们的工作方式带来颠覆性的改变,以ChatGPT为首的生成式AI可以让人们更加轻松的完成以往复杂而繁琐的工作,而这些人工智能的模型之所以能拥有如此高的智能,是因为其经过大规模的训练拥有海量的参数,例如ChatGPT的GPT模型已经拥有超过1万亿的参数。然而,想要运转如此大规模的AI模型,势必要消耗巨大的算力、时间和能量,训练GPT-4就要用到16000个英伟达A100 GPU芯片,并且需要连续运转4至7个月,消耗的成本高达1亿美金。

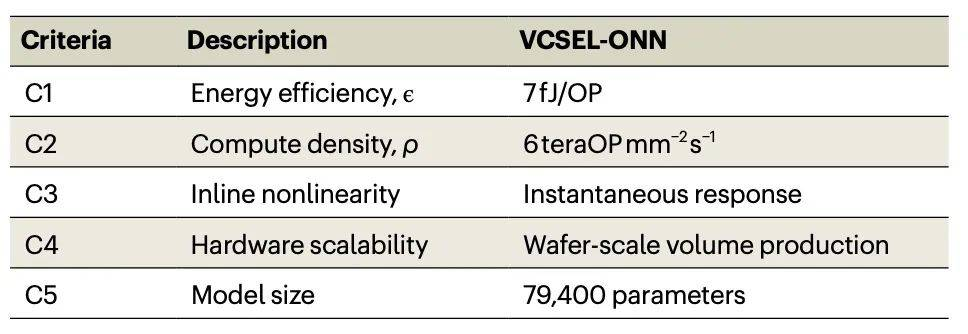

因此,如果大模型想要继续演进,仅依靠传统的计算机是远远不够的,继续增加GPU芯片提高算力的速度已无法跟上大模型演进的速度,并且从成本上也没有企业可以承受无限制的增加GPU芯片,我们需要引入新的技术带来算力突破。而就在最近,MIT(麻省理工学院)的光学人工智能团队首次提出了将“时间-空间复用”应用在光子计算芯片的设计理念,并采用光电效应做乘法和加法运算。据了解,这个计算架构在垂直表面发射激光器(vertical-cavity surface-emitting laser,VCSEL)阵列实现,并进行实验验证,达成了光子计算芯片对电子计算的优势,提升了100倍的能量效率和20倍的计算密度,同时有望在近期内实现多个数量级的性能提升。

新型光芯片架构整体性能的突破

目前,与电子计算芯片相比,光子计算芯片的能耗、计算密度等性能仍然有显著差距,可规模化程度低,其主要原因在于电光转换的效率较低导致的高能耗、集成光器件的尺寸较大导致的计算密度低、缺少非线性运算导致的高延时等,而该团队研发的这种新型光电系统则具有低能量损耗、高计算密度和光学非线性这三方面的优势。

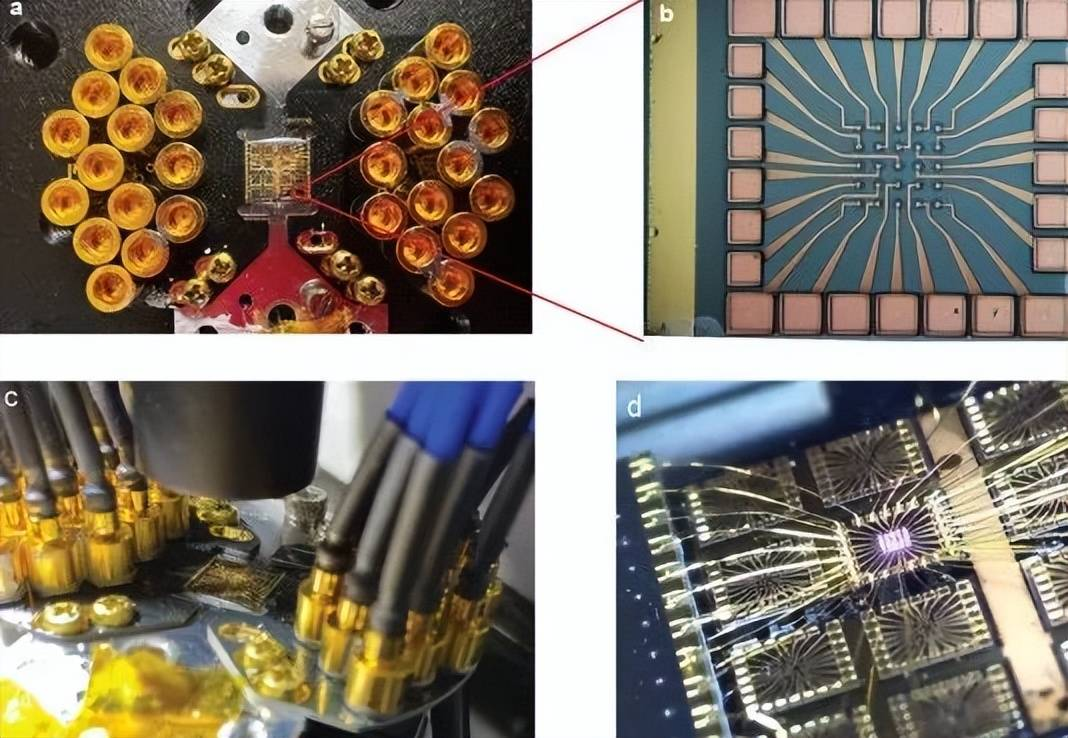

MIT光计算芯片原型

研究团队使用了一种微型激光器新型的调制模式(半波电压仅为4mV),实现了5x10-18 J/symbol的转化效率,这个转化效率高于其他光电调制器5个数量级。同时,由于传统的光电系统需要集成光学器件的体积较大要占据大量空间(最先进的光学调制器长度约为1厘米),该团队在计算架构采用了一种尺寸非常小的激光阵列(每个器件小于100微米),可以直接从光源上进行调制,无需依赖外接光调制器,增加了计算密度。除此之外,这个新架构中还首次采用了光电效应引入非线性,用以解决光学不适合做非线性计算的难题。

对于此项研究成果,光学计算领域专家耶鲁大学的Logan Wright教授表示,虽然目前这技术仍远未达到实际有用设备所需的规模和成本,但对未来几年可以实现的目标感到乐观,特别是考虑到这些系统必须加速非常大规模、非常昂贵的人工智能系统,例如ChatGPT等流行文本GPT系统中使用的系统。

最前沿的电子设计资讯

最前沿的电子设计资讯