如今我们随处都能看到和听到有关人工智能(AI)和机器学习(ML)的内容。有些人声称,它几乎可以解决我们所有的问题,就像几年前对5G的热炒一样。人们的观点不一,有的认为这是历史上最可怕的发明,有的认为这是可以想象的最先进的技术进步,还有许多人认为这是一件好事情,但也有很多担忧和警告。

无论你对人工智能的前景或威胁有何看法,有一件事是无可争议的:人工智能的实现需要大量的算力和电力。例如,较大的流行模型GPT-3,拥有1750亿个参数或权重。在如此多的维度上存在这么多类型的关联和计算,因此通过人工智能算法进行工作是一项重大的投入。

这一问题已得到充分认识,而克服这一问题的可行方法之一就是模拟计算。这当然有一种“Back To The Future”(回到未来)的感觉,因为早期的电子计算机是全模拟的,使用真空管放大器,然后是分立晶体管,最后是运算放大器IC(op amp)。

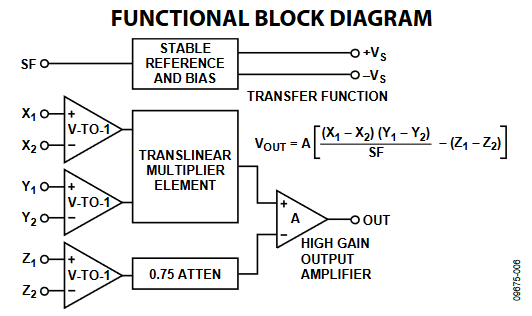

模拟电路并不局限于满足大规模计算需求。即使是乘法这样的基本功能,也可以通过几个有源器件来完成,而且这通常是成本效益最高、功耗最低的方法。例如,由ADI公司的Barrie Gilbert于1976年设计的AD534模拟乘法器,它采用了巧妙的晶体管排列(图1),至今仍在销售。它可以提供与瞬时功率(电压乘以电流)成比例的连续、实时输出。

图1 久负盛名的AD534模拟乘法器采用两个电压输入并提供并发模拟电压输出,该输出与乘积成正比,几乎没有时滞。来源:ADI

更高带宽的模拟乘法器可用于RF信号链,以确定复杂波形的均方根(rms)电压。这种单芯片模拟计算的速度可达数千兆赫兹,比过采样数字系统所能支持的速度快一到两个数量级。

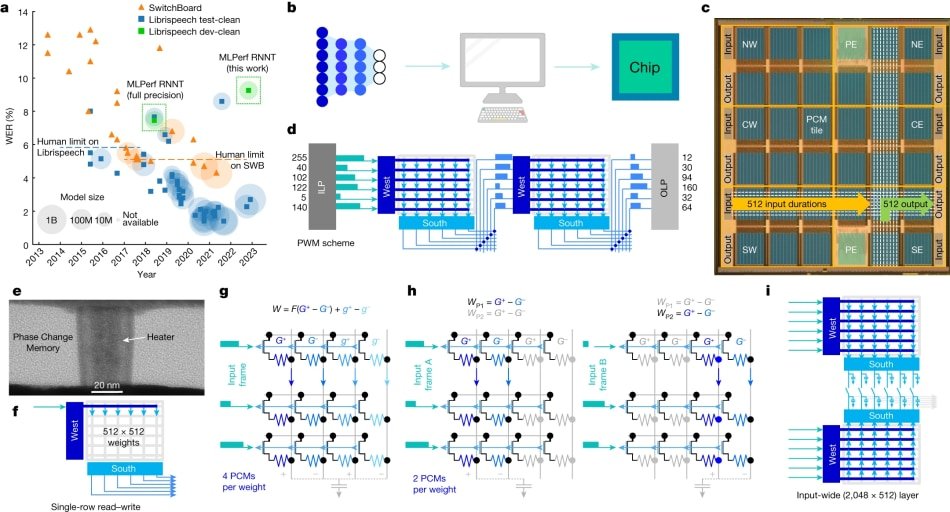

模拟AI是一种不同类型的模拟拓扑。在众多致力于“模拟AI”的厂商中,IBM已经开发出了使用相变存储器(PCM)的计算核心,但不要与脉冲编码调制相混淆(见图2)。请参阅《自然》杂志的文章,“An analog-AI chip for energy-efficient speech recognition and transcription”。

图2 基于相变材料的模拟方法的构造和布置概览。资料来源:IBM

在这种设计中,对材料施加一个电脉冲,这个脉冲会改变器件的电导率。材料会在非晶态和晶体态之间切换,较小的电脉冲会使器件更加晶体化,从而提供较小的电阻,而足够大的电脉冲则会使器件非晶化,从而产生较大的电阻。

这种PCM器件会将其状态记录为非晶态和晶态之间被称为突触权重的连续值。该值可以存储在每个器件的物理原子配置中,从而将神经网络的权重直接编码到物理芯片上。这种存储器是非易失性的,因此当电源关闭时,权重仍会保留。

IBM研究团队的设计可以为每个芯片编码3500万个相变存储器件,可用于具有多达1700万个参数的模型,并针对主导深度学习计算的乘积累加(MAC)运算进行了优化。通过读取电阻式存储器(NVM)阵列的行,然后沿列收集电流,IBM团队使它可以在存储器内执行MAC。

这样就无需在芯片的内存和计算区域之间或跨芯片移动权重。模拟芯片并行执行许多MAC运算,从而节省了时间和能源。IBM团队进行了各种AI测试,结果表明,他们原型的每瓦性能(效率指标)比同类系统高出大约14倍。

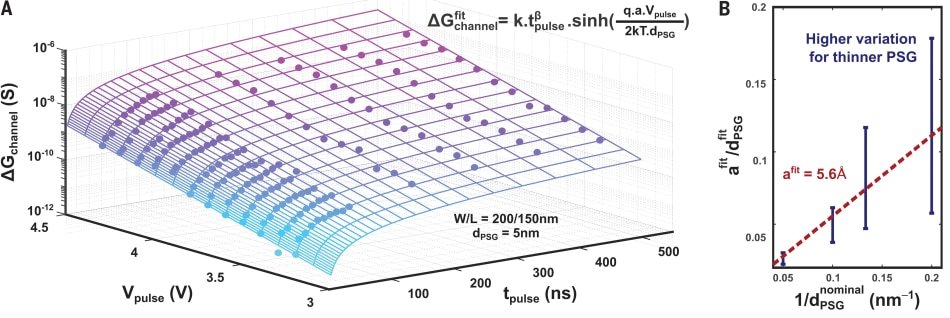

IBM并不是唯一一家寻求使用模拟技术来减少人工智能需求的组织。麻省理工学院(MIT)的一个团队设计了一种实用的无机电阻材料,他们称之为质子可编程电阻器,其制造工艺使其器件的运行速度比以前的版本快100万倍(参见《科学》杂志文章,“Nanosecond protonic programmable resistors for analog deep learning”)。与他们早期版本的器件中使用的材料不同,新材料与硅制造技术兼容。

电导由质子的运动控制。在这种方法中,设备的工作机制基于最小离子(质子)插入绝缘氧化物的电化学过程,以调节其电子导电性。这需要使用一种类似于电池的电解质,它能传导质子,但阻挡电子。为了增加电导率,可将更多质子推入电阻器中的通道,而将质子取出则可降低电导率(图3)。

图3 AI拓扑的电导调制的电压相关性是基于电化学方法将质子插入绝缘氧化物,以调制其电子电导率。资料来源:MIT

由于他们使用的是非常薄的器件,因此可以通过使用强电场来加速这种离子的运动,并将这些离子器件推向纳秒级的运行状态。他们在纳米级厚度的可传导质子的特殊固体玻璃薄膜上施加高达10V的电压,而不会对其造成永久性损坏,电场越强,离子器件的速度就越快。

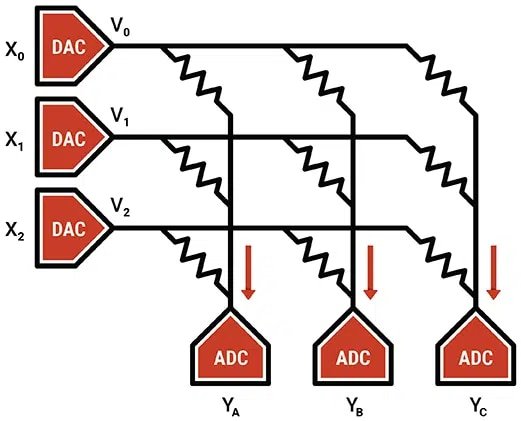

其他公司也在追求模拟AI的方法。Mythic集成了闪存阵列和ADC,将它们相结合可以存储模型参数并通过Mythic模拟矩阵处理器执行低功耗、高性能的矩阵乘法。

该公司的单芯片M1076 AMP Mythic模拟计算引擎(Mythic ACE)能提供GPU的计算资源,而功耗仅为GPU的十分之一。它将闪存阵列与DAC和ADC集成在一起,共同存储模型参数并执行低功耗、高性能的矩阵乘法(图4)。

图4 该方法将用作可调电阻器的闪存元件阵列与DAC和ADC集成在一起,它们共同存储模型参数,并执行低功耗、高性能的矩阵乘法。来源:Mythic

通过将内存计算方法发挥到极致,它直接在内存阵列本身内部进行计算。其将存储元件作为可调电阻,以电压形式提供输入,以电流形式收集输出。换句话说,它使用模拟计算进行核心神经网络矩阵运算,即输入向量乘以权重矩阵。

基于这些研究和半商业化行为的努力,模拟的概念和方法似乎可能是克服现在基于数字、计算和功耗密集型AI系统所面临挑战的关键。

这里有一些讽刺意味,就好像是已故的伟大模拟元件和电路天才Bob Pease曾说过的话的另一种体现:“一个好的运算放大器胜过一千个逻辑门。”人工智能将在多大程度上支持这一论点?您认为模拟方法能够实现各类人工智能系统所需的性能吗?

(原文刊登于EDN姊妹网站Planet Analog,参考链接:Will the new “analog” save AI?,由Ricardo Xie编译。)

最前沿的电子设计资讯

最前沿的电子设计资讯