在美国拉斯韦加斯举行的CES 2024,展示了一款能执行多模式大语言模型(LLM)的新型低功耗SoC,声称其每次推论功耗(power-per-inference)仅为领先GPU解决方案之一小部份。影像芯片业者安霸(Ambarella)的目标在于透过这款SoC将生成式人工智能(Generative AI)导入视讯安全分析、机器人和众多任务业应用的边缘端点装置和本地硬件。

Ambarella公司总部位于加州圣克拉拉,该芯片开发商称,其N1系列SoC每次产生代币的能源效率比GPU和独立AI加速器更高3倍。Ambarella最初将为其中高阶SoC提供优化的生成式AI处理功能,以实现5W以下的装置效能。此外,也将在其N1系列中发布50W以下的服务器级SoC。

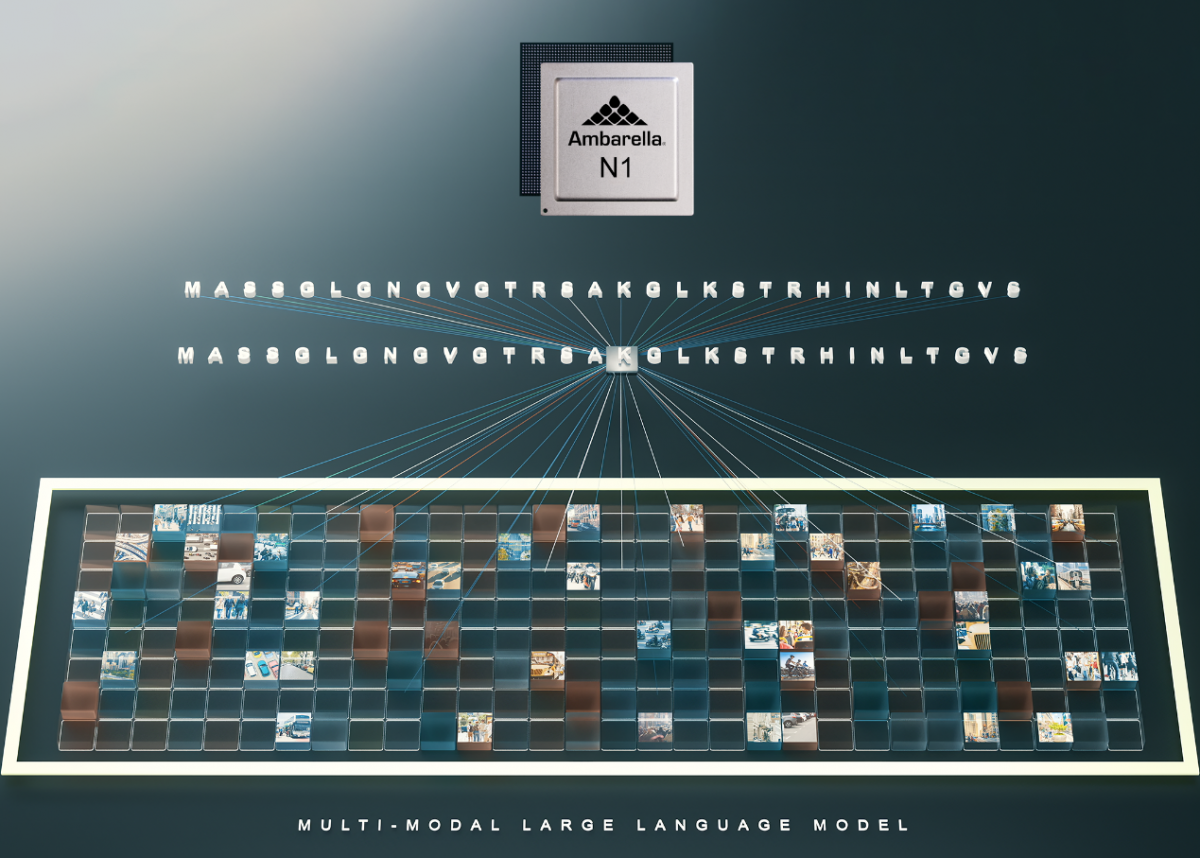

生成式AI将成为计算机视觉处理的阶跃函数,为安全装置和自主机器人等各种装置带来情境架构和场景理解。(来源:Ambarella)

Ambarella声称其SoC架构本身极其适合以极低功耗同时处理视讯和AI。因此,相较于独立的AI慧加速器,它们可以对多模式LLM进行高效处理,同时仍执行所有系统功能。这些SoC支持的装置上LLM和多模式处理范例包括安全的智能情境搜寻、可以使用自然语言命令控制的机器人,以及可以执行从程序代码产生到文字和影像产生等任何操作的不同AI助理。

Ambarella技术长兼联合创办人Les Kohn表示,生成式AI网络正跨越各种应用以实现先前无法达到的新功能。“所有边缘装置都将变得更加智能,芯片能够以非常有吸引力的功耗/价格范围实现多模式LLM处理。”

Omdia资深运算首席分析师Alexander Harrowell同意上述观点,并认为在未来18个月内,几乎所有边缘应用都能以生成式AI进行增强。他补充说:“当将生成式AI工作负载转移到边缘时,游戏的重点就在于每瓦性能,以及与边缘生态系的其他部份进行整合,而不仅仅是原始吞吐量。”

这些AI芯片由该公司的Cooper开发者平台提供支持,Ambarella在该平台上预先移植并优化了流行的LLM,包括Llama-2以及执行于N1 SoC上的大型语言和视讯助理(Large Language and Video Assistant;LLava)模型,可对多达32个相机来源进行多模态视觉分析。这些预先训练和微调的模型将可供芯片开发人员从Cooper Model Garden下载。

Ambarella还声称,其N1 SoC非常适合特定于应用的LLM,通常可针对每个场景在边缘进行微调。这与使用更大、更耗电的LLM来满足每个用例的经典服务器方法不同。

凭借这些功能,Ambarella相信其芯片可以帮助OEM快速将生成式AI部署到任何功耗敏感的应用中,从本地AI盒子到送货机器人。

(原文发表于ASPENCORE旗下EDN美国版,参考链接:Chips taking generative AI to edge;编译:Susan Hong)

最前沿的电子设计资讯

最前沿的电子设计资讯