2023什么最火?无疑是以ChatGPT为代表的AGI (通用人工智能)了,甚至被称之为第四次工业革命的推动者。比尔·盖茨说,“ChatGPT像互联网发明一样重要,将会改变世界。”

AI芯片和AI服务器 – 掀起大规模建设热潮

ChatGPT的强大让很多人看到了AI所带来的无限可能,国内外互联网公司纷纷入场,掀起了建设大模型建设的热潮,一座座数据中心拔地而起,高算力显卡被炒到了天价,仍然一卡难求。相关媒体数据显示,2023年全球最大的社交网络公司购买了多达15万块NVIDIA GPU,而其它IT知名巨头可能只拿到了5万块左右。新年之初扎克伯格发文称,计划年底前向英伟达再购买35万个H100 GPU芯片,从而使该公司的GPU总量达到约60万个。

AI PC – 未来每个人拥有一个专属自己的AI PC

IDC预测, AI PC在中国PC市场中新机的装配比例将在未来几年中快速攀升,将在2024年暴增到55%,在2027年达到85%。2024年将成为AI PC元年。

2023年底,联想集团与IDC联合发布了首份《AI PC产业(中国)白皮书》。出于数据安全和隐私保护的考虑,以及更高效率、更低成本响应用户需求的考虑,人们既希望获得公共大模型强大的通用服务,又希望AI能够真正理解自己、提供专属个人的服务,并且能够充分保障个人数据和隐私安全。未来,每个个体都可以拥有一个专属于自己的AI PC,运行属于自己的“个人大模型”。

AI手机 – AI+手机成为行业共识,未来有望将手机行业带入第三阶段

AI大模型的火热,也让手机厂商看到了在软件体验上实现革新的可能。一方面,AI的进化有望提升智能手机的使用体验,另一方面跳出硬件互“卷”的怪圈,寻求新的竞争点,现在“AI+手机”这一概念已经成为了行业共识。随着三星新一代旗舰S24系列的正式发布,喊出“开启移动AI新时代”的口号,在新机中引入视频AI处理、AI聊天机器人、影像画面处理、通话实时翻译等多项AI功能,AI手机正式成为国内外手机厂商共同的“进化趋势”。此前,国内手机的两场发布会以及几家公司的自演模型,都非常默契地锁定了AI能力在新手机和新系统上的落地。业界大佬称,2024 年是 AI 手机元年,未来五年AI 对手机行业的影响,完全可以比肩当年智能手机替代功能机。AI 手机也将成为继功能机、智能手机之后,手机行业的第三阶段。

AI赋能汽车 – 继家庭和办公场所外的第三空间

作为继家庭和办公场所之外的“第三空间”,汽车正在变成一个新型智能终端。ChatGPT到来了之后,车机关系也受到了更多的影响。从整个参与的车企来看,其发展大模型的方向和侧重点并不相同。从功能上来看其主要可以分为以下两类:

一类是用于人工智能交流对话领域,多数应用在智能座舱上。车载大模型语音助手,可以处理完整的对话,如追问,并能保持对前后文的理解,形成较为良好的语音交互体验。驾驶员未来有望通过车载系统完成预订餐厅、预订电影票等任务,极大地丰富智能汽车与人之间的交互体验。

另一类是聚焦智能驾驶的大模型应用。帮助解决认知决策问题,最终实现端到端的自动驾驶;或者摆脱对高清地图的依赖,让汽车做到更接近人类司机的驾驶表现。

事实上,AI 已经无处不在。在CES 2024上,我们看到了眼花缭乱的AI产品。AI步行鞋帮助人们实现2.5倍步行速度,AI地毯实时收集宠物健康和环境数据,AI智能腰带帮助盲人进行环境监测和路线导航,AI 枕头帮助用户解决打鼾问题,AI牙刷检测刷牙习惯和牙齿健康并实时给出语音建议,AI镜子会告诉你当前的精神状态并提供个性化建议。2月中,Open AI在文本模型ChatGPT、图像模型Dall-E大杀四方后,又祭出爆炸性的大杀器 - 视频模型Sora。Sora可以根据一段描述性文字生成长达一分钟的视频。无论多天马行空的想法,AI 都可以给你表达出来,长达60秒。业内分析指出,这将对于广告业、电影预告片、短视频行业带来巨大的颠覆。

Sora也好,ChatGPT也好,大模型训练的背后是由高算力芯片所组成的大规模运算网络。Meta等巨头一出手就是几十万个高算力芯片,近千亿的投资来建设数据中心。而作为终端的AI产品,比如AI PC、AI 手机、AI汽车、AI智能家居,依赖的就是终端产品内的算力芯片。

晶体管是芯片的基础组成单元,晶体管的数量越多,芯片的性能越强。各大芯片设计厂家和晶圆厂,就是想方设法在有限的空间里,通过更小的工艺尺寸(如3nm),来堆积更多的晶体管。

晶体管工作的时候需要变化的电压,代表逻辑1和逻辑0,进而实现计算或控制。由于开关损耗、短路功耗和漏电功耗的存在,晶体管在工作的时候会消耗掉电源功率,产生热量。晶体管数量越来越庞大之后,散热这个很现实的问题就摆在芯片和系统设计师的面前。处理器芯片每平方厘米的面积上,就能产生300瓦的峰值功率,算下是150瓦/平方厘米,已经超过了典型的核反应堆的功率密度了。现在的数据中心很多都已经使用浸没式液冷来进行散热,把服务器和算力芯片浸没在绝缘的、导热性良好的液体里面,通过液体的流动快速带走热量,比传统的风扇散热效率更高,但这还远远不够。

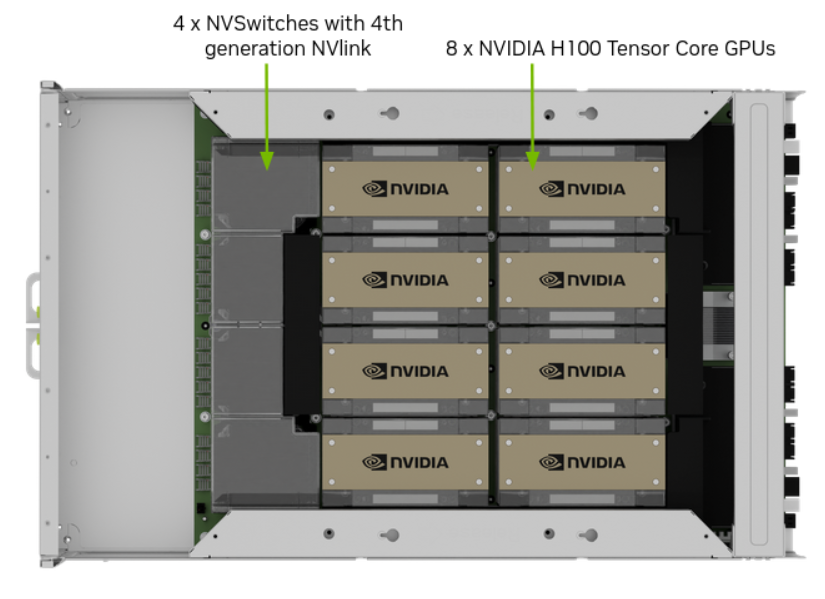

图1: 典型的8 x GPU算力系统(图片来源NVIDIA)

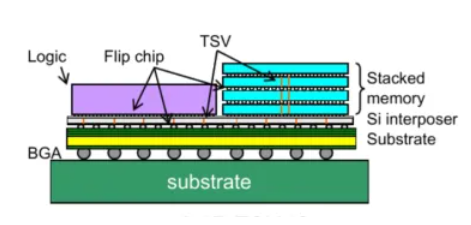

图2: Chiplet封装示意图,存储单元可以多层堆叠而算力单元只能平铺

散热和工艺尺寸一样,是制约晶体管的密度和规模增加的难题之一。解决散热的其中一个方案,就是从源头想办法,降低电压。使用更低的工作电压,将每一颗晶体管的功耗降下来,就可以堆叠更多的晶体管。早期算力芯片工作电压是5V,慢慢演化到3.3V,1.8V,1.5V,如今,算力芯片和高速接口芯片的工作电压基本都在1V左右,甚至更低。这就对电源设计和测量提出了更高的要求。

电源是算力芯片的能量来源,是逻辑状态的参考基准。如果电源的纹波和噪声过大,会给高速变化的逻辑信号上产生大量抖动,进而产生误码(注: 误码即错误的码元, 将逻辑1当成逻辑0, 或者将0当成1),影响芯片的性能,甚至导致芯片无法正常工作。高速信号验证中非常重要的随机抖动和低频的周期性抖动,就是由于电源的噪声和纹波所引入的。

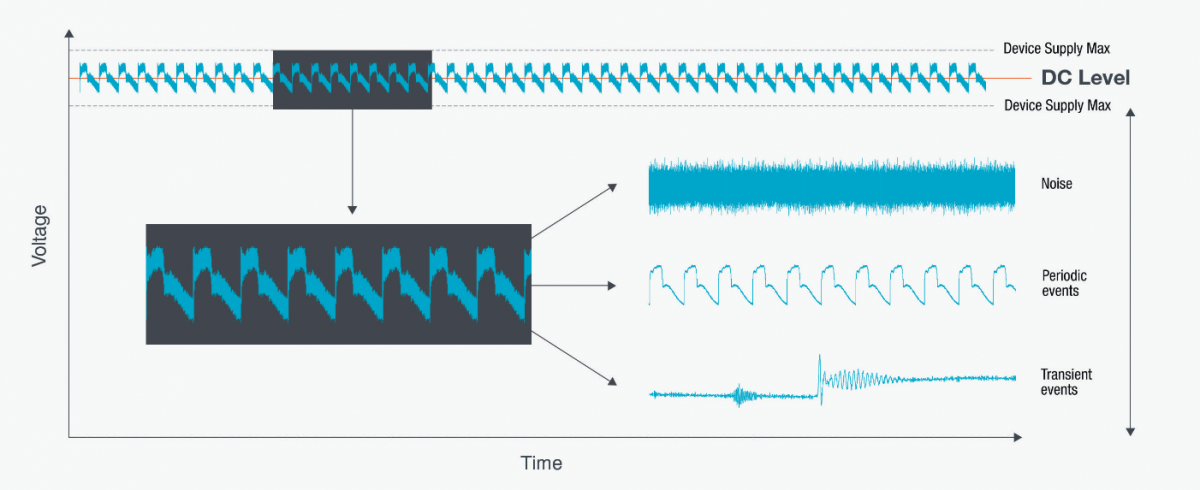

图3: 电源纹波和噪声

电源的纹波和噪声测量,一直都是电源工程师们最关注的问题之一。算力芯片更低的工作电压,导致电源留给纹波和噪声的裕度变得更小了,给设计和测试都带来了难题。设计上,算力芯片普遍采用POL的降压方式,将DC-DC变压器尽可能靠近负载端,可以有效避免传输链路上引入的外部干扰。测试上,使用更高精度、更低底噪的示波器,和专用的电源纹波探头,降低测量系统引入的噪声,才能更准确地测量电源纹波和噪声。

泰克的MSO6B系列示波器的底噪性能非常优异,底噪的有效值在20MHZ带宽下低至8.68uV,1G带宽下低至51.5uV,是测量电源纹波和噪声的最佳选择。如果电源电压是1V,示波器的底噪稍微高一点,裕量还有很大空间,是可行的吗?这里需要了解两个问题:

仪器的底噪指标用的都是有效值。而电源纹波和噪声的测量规范,一般都是用峰峰值。峰峰值和测量样本数相关,测量的样本数越多,峰峰值越大,我们可以近似的认为峰峰值是有效值的10倍以上。

电源工程师测量底噪和纹波都会使用探头,而探头会引入额外的底噪。为什么一定要用探头呢?有几个方面的原因,一是探头使用便捷,二是探头提供较高的输入阻抗,对待测电路的影响小,三是探头提供较大的偏置电压,可以在测量噪声和纹波的同时,观察到电源直流电压的变化。尤其当芯片的负载处于动态变化时,电源的直流电压也会随之改变。

示波器加上探头,再去测量一下底噪的峰峰值,你会发现原来底噪并不小。手上有示波器和探头的工程师不妨试试看,将示波器接上探头,不接任何待测信号。在示波器上打开峰峰值测量,测量结果就是系统底噪。

常规的示波器和探头,系统底噪峰峰值在5 mV以上。而有些算力芯片和通信芯片,要求电源噪声的峰峰值必须小于3 mV。测量系统的底噪都这么大,测量结果怎么可能Pass呢!

为了更准确的测量电源纹波和噪声,泰克推出了专用的电源轨探头TPR系列,20MHZ带宽下的底噪的峰峰值(注意是峰峰值) 低至 300uV,即便在4GHZ的全带宽下,底噪的峰峰值依然只有1.3 mV。而且TPR探头还支持高达60V的偏置电压,多种多样的探头附件,不仅测得准,用起来还很方便。

最前沿的电子设计资讯

最前沿的电子设计资讯