计算正越来越专用化,通用CPU已不再能满足需求。在过去,软件和硬件分别由不同的公司负责开发,而这样老旧的模式已经无法满足现在对性能的需求,也无法适配软件或硬件的复杂性。企业希望其部署的硬件,甚至在微架构层面,都能被优化,以便顺利运行其软件工作负载。但是此类联合优化很难实现,需要软硬件双方做出巨大的投入才能够完成。

而头部云计算和网络企业对其数据中心、计算设备及运行其中的工作负载非常熟悉,他们高度专注于优化其基础设施的每一层,目的是让这些多样化的工作负载获得最佳性能,更重要的是获得最佳的每瓦性能。但是没有一个基准测试能展现所有工作负载的性能表现,这带来了深入了解每个用例的必要性,并需要有针对性地对其进行调优。

Arm架构作为全球应用最为普及的CPU架构,在多个领域的技术革新中发挥着主导作用,众多国际知名的大型科技企业正基于Arm平台构建新一代系统和基础设施,Arm全面设计(Arm Total Design)生态项目也为此提供助力,它提供了一个生态系统,让参与其中的企业能无缝交付基于Arm Neoverse计算子系统 (CSS)的定制芯片。

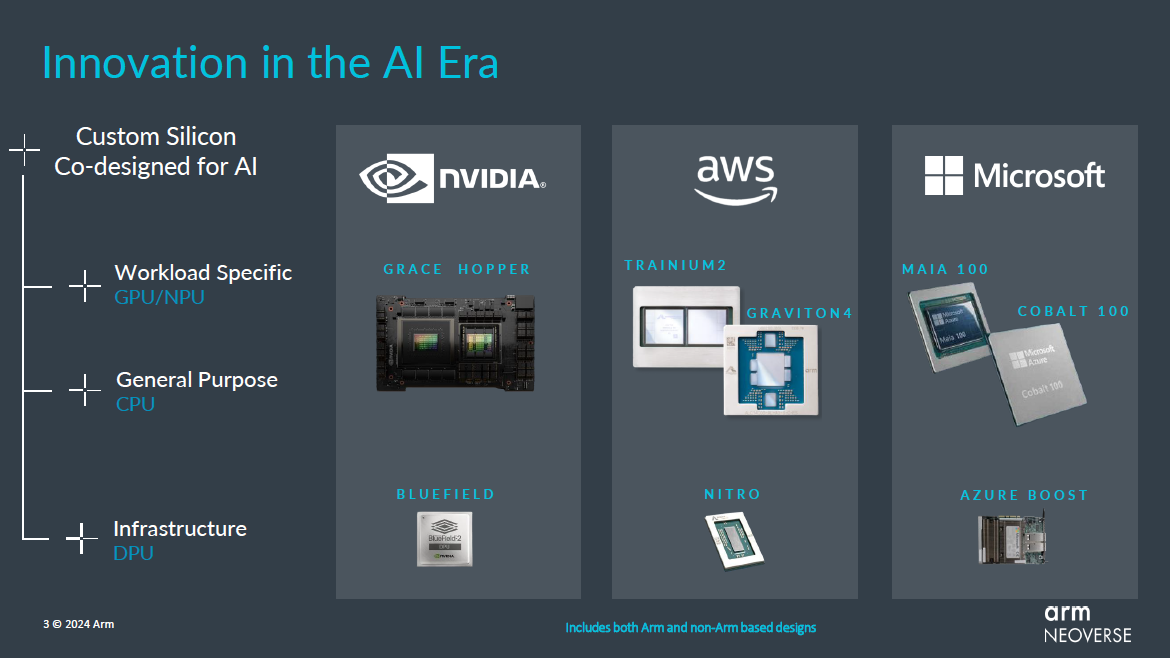

人工智能时代的创新

Arm高级副总裁兼基础设施事业部总经理Mohamed Awad表示:“科技企业选择Arm的原因很简单,因为我们独特的定位能赋予合作伙伴快速创建定制解决方案的能力,并充分利用到强大的生态系统,正是这些特性使Arm Neoverse夯实了全球AI愿景的根基。AI的适用范围不仅是应用服务器和数据中心。AI正成为包括网络、安全和存储等诸多领域不可或缺的一部分,它可应用到包括小型终端到交换机、路由器和基站等各种设备在内的整个基础设施中。我们很荣幸能在其中发挥关键作用,协助科技先行者解决由AI转型带来的不断增长的数据和计算需求。”

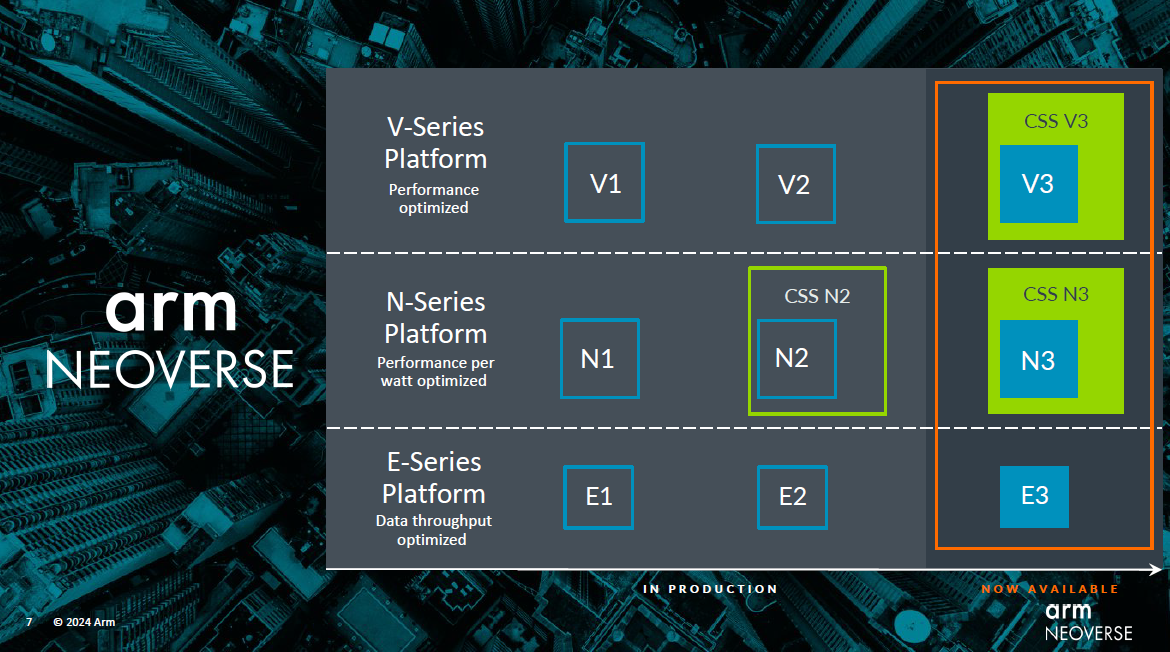

Neoverse CSS是Arm在2023年推出的,它可以让定制芯片变得更迅速,且更易实现。在Neoverse CSS中,Arm负责配置、优化和验证一套完整的计算子系统,并针对基础设施市场的各种关键用例进行配置,从而让其合作伙伴能够专注于,针对特定系统级工作负载塑造差异化竞争优势,比如软件调优、定制加速等。而就在2月22日Arm举办的技术媒体沟通会上,Arm推出了两款基于全新第三代Neoverse IP构建的新的Neoverse CSS产品——Neoverse CSS N3和Neoverse CSS V3。

Neoverse CSS N3聚焦能效,与CSS N2相比,其每核心的每瓦性能提升20%,可满足基础设施性能要求的高效计算。CSS N3的首个实例可提供32 核,热设计功耗(TDP)低至40W。其可扩展性非常强,可覆盖电信、网络和 DPU 等一系列应用,Arm也同时在考虑横向扩展云配置。CSS N3基于新的Neoverse N3 IP平台打造,为新的N系列引入了Armv9.2功能,能为每个核心提供2MB的专用L2缓存,并支持最新的PCIe和CXL I/O标准以及UCIe芯粒标准。

而对于用户更高性能的需求,Arm推出了Neoverse CSS V3,与CSS N2产品相比,其单芯片性能提高了50%,在单芯片上最多可扩展至128核,并支持最新的高速内存和I/O标准。CSS V3基于Arm新的Neoverse V3核心打造,这是Arm目前单线程性能最高的Neoverse核心。V3还为Arm机密计算架构(CCA)提供硬件支持,同时V3和N3核心均可提供业界领先的专用L2缓存大小,显著改善性能表现。

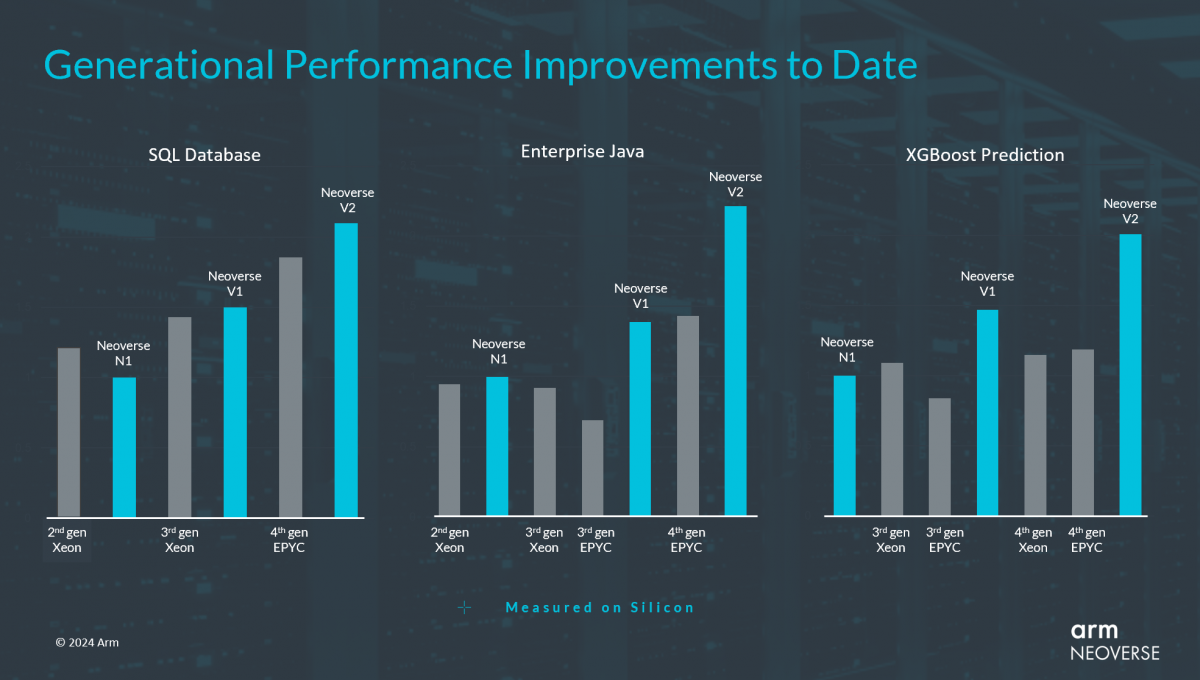

代际性能提升

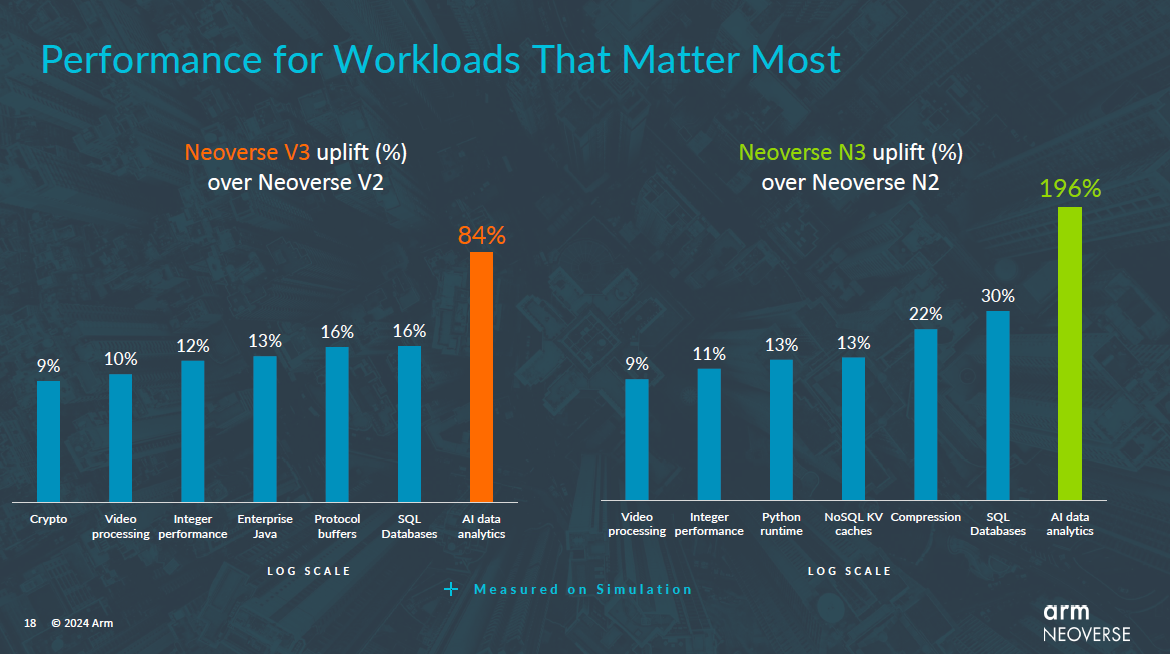

对于这两款新产品,Arm基础设施事业部产品解决方案副总裁Dermot O’Driscoll表示:“新产品全方位地实现了非常良好的提升,从视频处理到SQL数据库的性能均有所跃进。如今,人们常常忽视的一点是,有多少计算周期最终被用于压缩和协议转换等后台任务。N系列在压缩方面取得了性能优势,可降低云服务运营商的成本,并最终降低云服务客户的成本。同样地,V系列显著提高了协议缓冲区的性能,这是在数据中心内传输数据的一项关键功能。”

新系列产品工作负载性能较前一代产品大幅提升

这两款新产品在AI数据分析工作负载方面的优势更为引人注目。以XGBoost为例,这是一种强大的机器学习(ML)算法,可以帮助人们理解数据并做出更明智的决策,支持Java、C++、Python、R等多种语言。作为一个被广泛使用的经典ML应用,无论是为人们推荐下一个媒体内容,预测高峰时段的打车费用,还是提供相关的机票优惠,我们日常生活中大量使用的各种预测性和定制化在线服务均使用XGBoost作为主要数据库来驱动相关核心算法。

而通过分析应用的关键工作负载核心的特定关键任务算法,Arm能够明确并实施,对提升性能最有效的微架构调整方法。在XGBoost用例中,包括改进分支预测,更好地管理最后一级缓存和相关内存带宽,以及大幅增加 L2 缓存。其结果是,N3的性能提升高达196%,并且这是基于已经超越其他同类厂商的工作负载进行的。

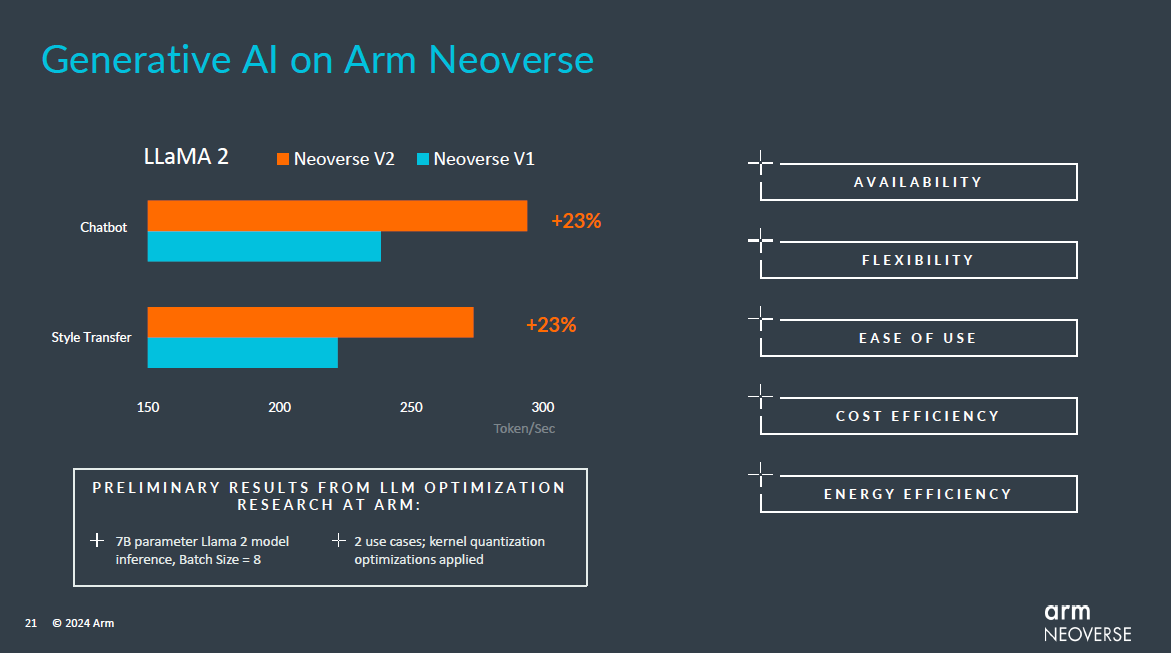

对于2023年爆火的生成式AI和大语言模型(LLM),Arm当然也十分的关注。Arm认为,目前行业重点更多放在训练LLM 上,但随着生成式AI广泛应用于实际业务场景,其工作重点将转向推理。有分析师估计,已部署的AI服务器中有高达80%专用于推理,且这一数字还将持续攀升。这一转变意味着要找到合适的模型和模型配置,并加以训练,然后将其部署到更具成本效益的计算基础设施上。

对此,Dermot O’Driscoll表示:“吞吐量是其中一部分考虑因素,而在当今广泛部署的基于Arm架构的芯片上,Token生成吞吐量表现相当优异。但还有许多其他因素需要纳入考量。CPU广泛可用,并可灵活用于ML或其他工作负载,此外,CPU还易于部署,并可支持各种软件框架,具备低成本和高能效等优势。因此,CPU推理将是生成式AI计算应用的关键组成。我们可以看到,诸多工作负载已从ML专用的Neoverse功能(如Bfloat16、MatMul、SVE和SVE2),以及我们的微架构优化中受益,而且这一趋势还将继续。”

Neoverse系列产品生成式AI表现

当前AI计算领域火热,面对不断变化的芯片技术要求,Arm在基础设施领域的前进脚步未曾停歇,始终紧跟市场发展节奏。聚焦Arm Neoverse平台来看,其着手的方向主要包括以下几点:

从AI到5G,从云数据中心到边缘计算,全球各地打造新一代计算基础设施的技术先行者,越来越多的开始转向Arm Neoverse平台。据了解,Arm全面设计生态项目于2023年10月正式推出,仅仅经过四个多月的发展,Arm全面设计已经有20多家成员加入,其中包括新的EDA和配套IP提供商,以及来自包括韩国、中国大陆及台湾地区和印度等战略市场的知名芯片设计企业。

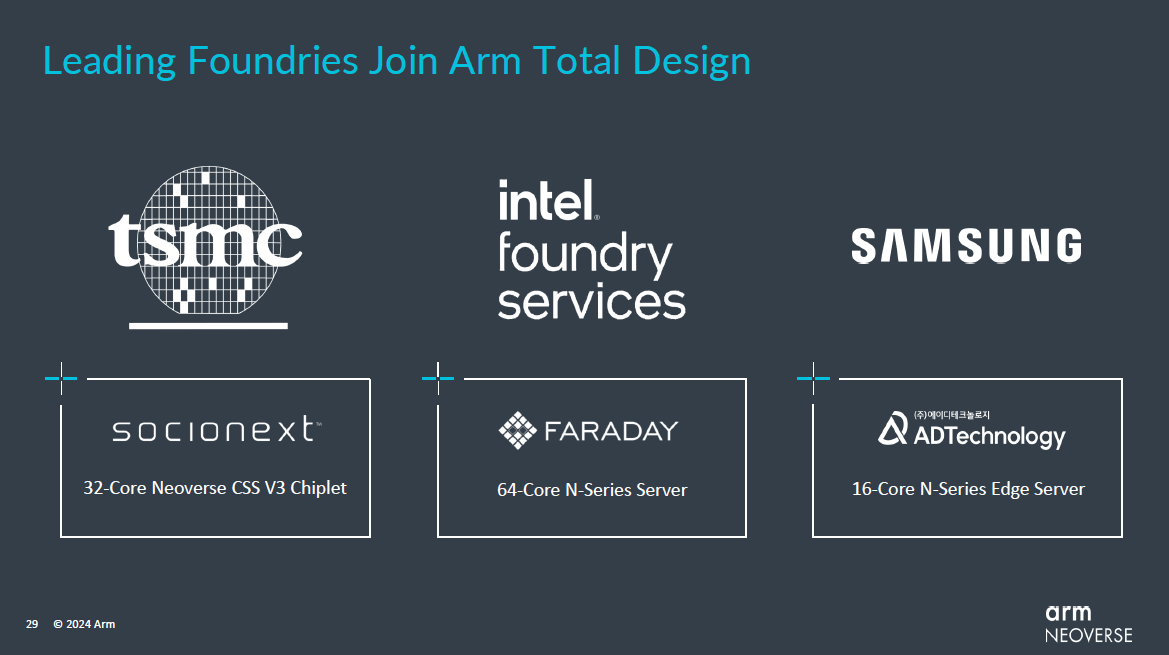

同时,Arm一直在与合作伙伴一起构建和优化云原生软件,以便让其最佳地运行在Arm平台上,Arm基础设施事业部营销副总裁Eddie Ramirez介绍到:“Arm全面设计的合作伙伴正在努力将基于Neoverse CSS的设计推向市场。去年十月,Socionext成为首家宣布计划在台积公司领先的2纳米工艺上开发基于CSS芯粒的合作伙伴。这款配置32核的芯粒可与其他芯粒结合使用,提供可扩展且经济高效的计算解决方案。该设计将基于新推出的Neoverse CSS V3来打造。智原科技也在构建基于芯粒的服务器芯片,该芯片将搭载64颗N系列核心,并基于英特尔代工服务的18A工艺节点进行生产制造。此外,ADTechnology 将提供高性价比的16核CSS N系列边缘服务器平台,他们将与三星代工厂合作,为边缘计算释放更强大的算力。”

据悉,Arm Neoverse软件生态系统正在不断扩展,以满足所有开发者的需求。从主流编程语言、软件工具、所有主要Linux发行版,到支持网络、存储和大数据以及AI应用的项目,包括软件栈各个级别的知名开源企业,此外还包括大量独立软件供应商(ISV),这一生态系统正成为云服务提供商部署其云服务的上佳之选。

最前沿的电子设计资讯

最前沿的电子设计资讯