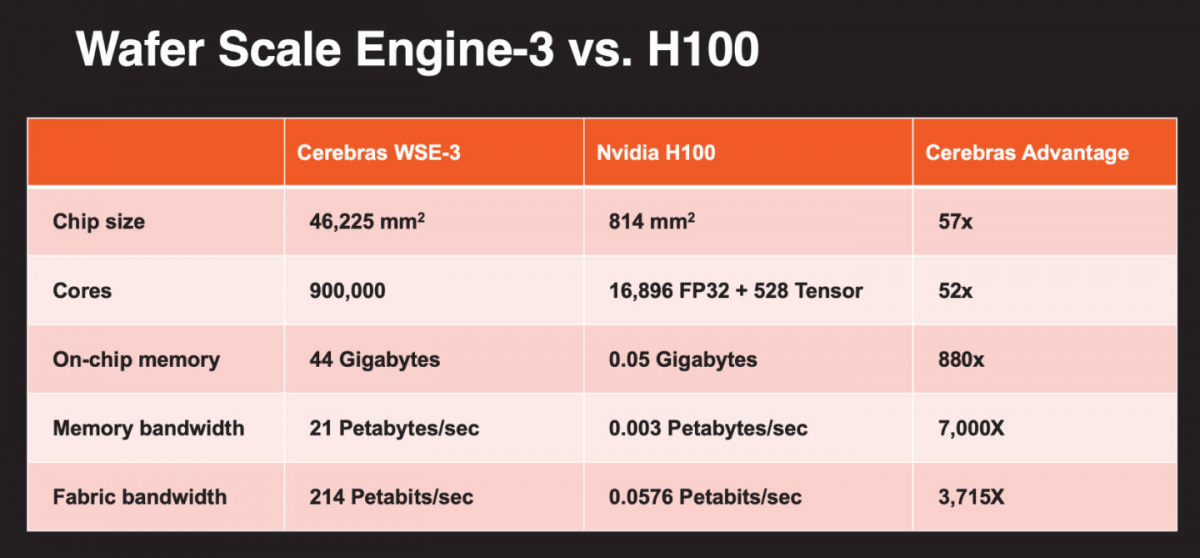

近日,美国AI芯片独角兽公司Cerebras宣布推出了其第三代晶圆级AI加速器——CS-3(WSE-3),这款产品拥有超过4万亿个晶体管,单颗面积达到了约46225平方毫米,是目前最大GPU(英伟达的H100)的57倍,专门用于训练最先进的AI模型,速度要比前代产品快两倍。

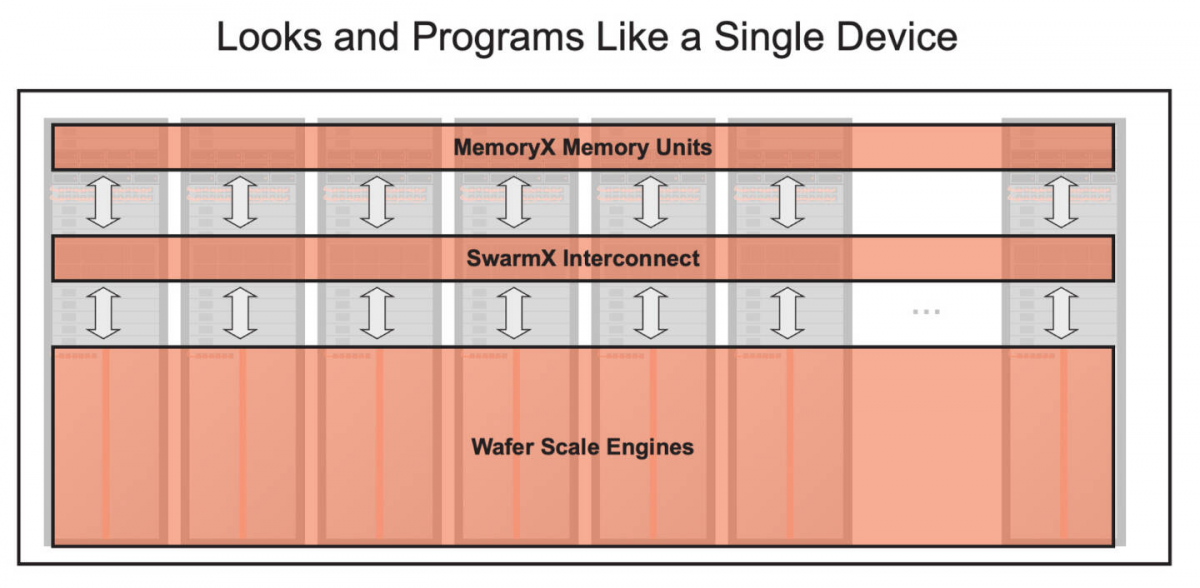

据了解,CS-3基于台积电5nm工艺,晶体管数量为4万亿,单芯片上封装了90万个AI核心,采用44GB超高速片上SRAM,内存带宽达21PB/s(1PB=1024TB),外部搭配内存容量支持1.5TB、12TB、1200TB。通过该公司的SwarmX互连技术,最多可将2048个CS-3系统连接成一个超大规模AI超级计算机,算力高达四分之一zettaflops(10^21flops),可以比肩一些顶级的超级计算机了。

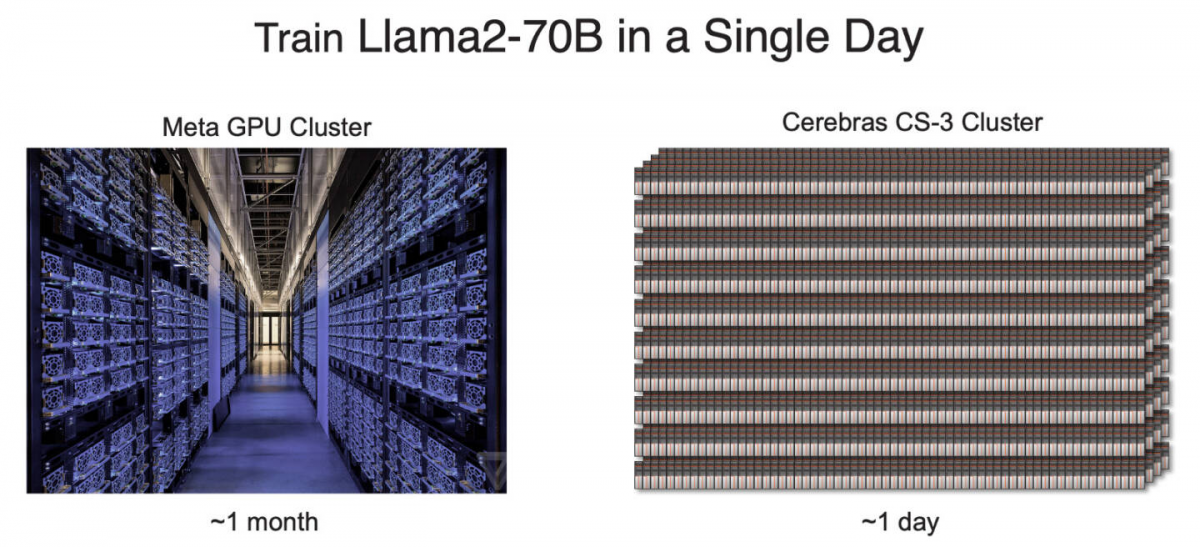

具体来说,一个完整的2048个系统组成的集群可提供256 exaflops(10^18flops)的AI计算能力,能够在不到一天的时间内从头开始训练Llama2-70B模型(700亿参数),而在Meta的GPU集群上同样的工作需要约一个月的时间。

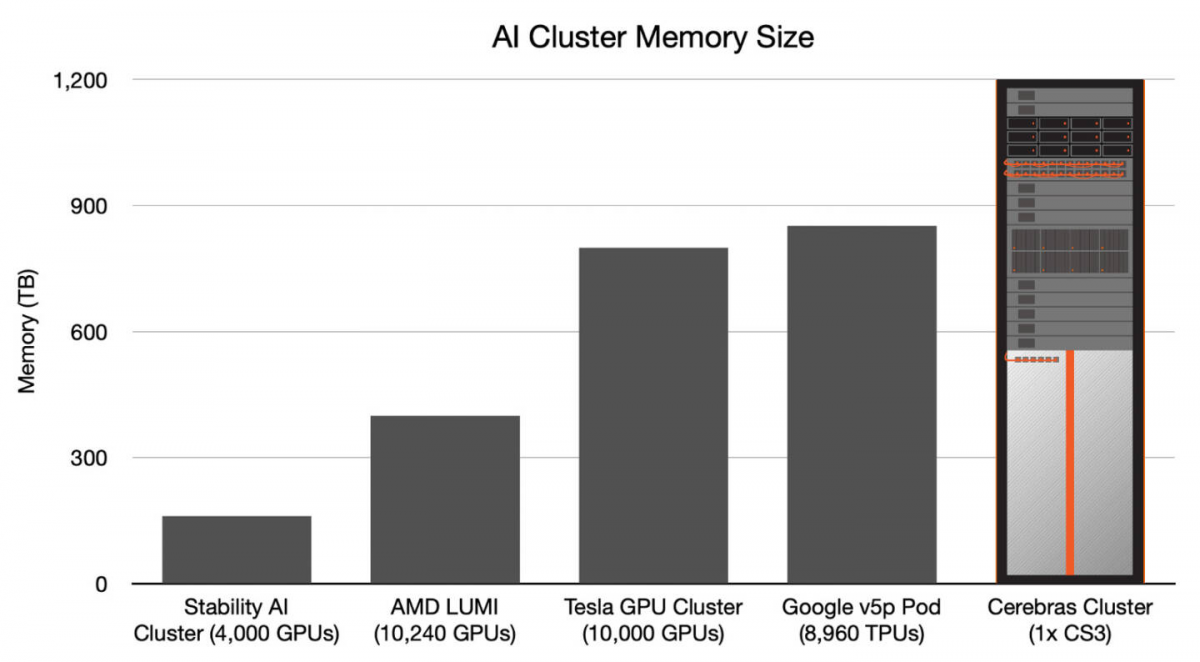

CS-3的另一个亮点在于计算和内存组件的解耦,使得Memory X单元的内存容量可以轻松扩展。以面向超大规模企业的1200TB选项为例(1200TB能够存储具有24万亿个参数的模型),单个CS-3能与之配对,意味着单个CS-3机架可以存储的模型参数量比10000个节点的GPU集群还多,而在一台机器上开发和调试万亿级别的参数模型,这在GPU领域还是前所未有的。

虽然目前CS-3具体的功耗和价格还没公布,但Cerebras已经预告了第一个将使用CS-3构建的AI超级计算机——Condor Galaxy 3(CG-3),还是继续由G42和Cerebras合作构建。CG-3使用了64个CS-3芯片,计算能力达到了8 exaflops,是CG-2的两倍,而占地和功耗却没有增加。CG-3将在美国得克萨斯州达拉斯建造,并计划于2024年第二季度上线。

最前沿的电子设计资讯

最前沿的电子设计资讯