我们对生成式AI端侧应用的想象力,似乎还相当欠缺。比如说K歌软件应用AI技术,大部分人能想到的应该是唱完以后AI修音+美化。

但其实在最近MDDC天玑开发者大会上,全民K歌展示的是,只需要对着麦克风唱歌30秒,基于端侧模型,就能用你的声音生成所有你想唱的歌曲——不需要你自己唱...这在几年前应该是个完全不可想象的应用场景。

这其中有个潜移默化的转变:以过往开发生态的传统来看,这类app通常借助操作系统或更上层的标准API,亦或与OEM厂商合作来实现不同的功能。但在AI渴求芯片高效算力的时代,此类生态的中心却开始向芯片厂商倾斜了。上述全民K歌的“AI歌声”特性,就是全民K歌和联发科合作,将端侧模型落地到天玑9300上实现的。

王小川(百川智能创始人、CEO)在圆桌发言中提到,他当年还在做输入法时合作的都是终端厂商,但现在做大模型“涉及到算力”,“开始和芯片厂商产生碰撞。”“在生成式AI到来以后,联发科所在的生态位,肩负的责任变得更大。”MDDC本身是联发科首次公开举办的大规模生态合作活动,推广“天玑AI先锋计划”,在我们看来算得上是吹响构建移动AI生态的号角。

所以我们看到联发科协同Counterpoint,与包括阿里云、百川智能、虎牙直播、酷狗音乐、零一万物、OPPO、vivo、腾讯AI Lab等在内的合作伙伴联合发布了《生成式AI手机产业白皮书》,率先定义 “生成式AI手机”。与此同时,面向开发者发布“天玑AI开发套件”;覆盖“全场景终端”,囊括手机、平板、IoT、汽车,乃至可能在规划中的笔记本PC。

陈冠州(联发科技董事,总经理暨营运长)表示:“通过天玑平台的优势,以及‘天玑AI先锋计划’,联发科将融合产业生态伙伴的力量,高效地赋能开发者,加速构建从云端到终端的AI新生态,推动生成式AI技术在智能终端上的应用普及,让更多用户享受到全新的高端生成式AI体验,加速万物AI时代的到来。”。

这样一来,本次发布的天玑9300+芯片就成为了整个天玑AI生态战略的一个维度。怪不得在通用计算加速和AI时代来临以后,英伟达一直在强调自己不是家芯片公司。但AI生态构建可不简单,尤其是生成式AI于端侧生态发展初期。借助MDDC活动上看到的,我们来谈谈联发科的移动AI生态具体是怎么做的,生态现状如何,未来又将是怎样。

李彦辑(联发科技无线通信事业部副总经理)在采访中谈到,云上AI开发的工具链发展相对“完整”。“可是端侧的工具链,尤其手机端——体量如此之大的终端消费电子,其实还没有完善的工具链来发展生成式AI”。

我们知道即便是以数据中心以依托的企业生成式AI市场发展都仍处于早期阶段,则基于开发生态现状,不难发现消费市场的端侧生成式AI的发展阶段比企业数据中心更初级。“生成式AI去年处在萌芽阶段,今年准备要起飞。”这是联发科推出天玑AI先锋计划的时代背景,“希望加速推动生态往生成式AI迁移。”

所谓的生成式AI技术要落到实处、芯片厂商要构建围绕自己的生态系统,基础部分有两点:(1)芯片及硬件基础;(2)开发工具及AI模型。

硬件基础自然是联发科天玑芯片。天玑9300应当是生成式AI在手机平台落地的开端。这次新发布的天玑9300+,强调的一样是AI。其中AI部分的关键构成,除了CPU全大核有加成以外,最关键的还是APU 790——我们在天玑9300芯片的解析文章里已经详细介绍过。

值得一提的是APU 790对于Transformer算子加速的支持——Transformer是现在大部分生成式AI模型的基础结构。其实仔细想一想,率先做出此番支持的天玑9300发布于2023年11月初。基于此类芯片设计至少12-18个月的周期,天玑9300的设计起码是2022年下半年就开始的,早于ChatGPT的全面爆发。

陈冠州也在圆桌讨论中提到,联发科“几年前就意识到Transformer的优越性,当时就相信它会在未来大量被采用”,“所以我们在天玑9300芯片上,第一时间将Transformer的支持固化到芯片里,大大降低了大语言模型推理过程中的功耗、成本和效率。”

天玑9300+的生成式AI特性部分,李彦辑提到“推测解码加速”在端侧实现,令端侧大模型“推理性能大幅提升120%”,“业界首款支持Llama 2 7B参数模型,运行速度22 tokens/秒”,“业界首款生成式AI端侧双LoRA融合”,支持最新的AI框架ExecuTorch,并且支持阿里云通义千问大模型、百川大模型、文心大模型、谷歌Gemini Nano、零一万物终端大模型、Meta Llama 2和Llama 3等前沿主流的AI大模型。

这其中的绝大部分特性,实则还是与软件工具、生态更为相关,是以天玑芯片、APU 790硬件级生成式AI引擎为基础的上层构建。虽然联发科从未主动谈过公司内部软件团队构建情况,但相信现阶段联发科在软件上的投入应该是不小的。

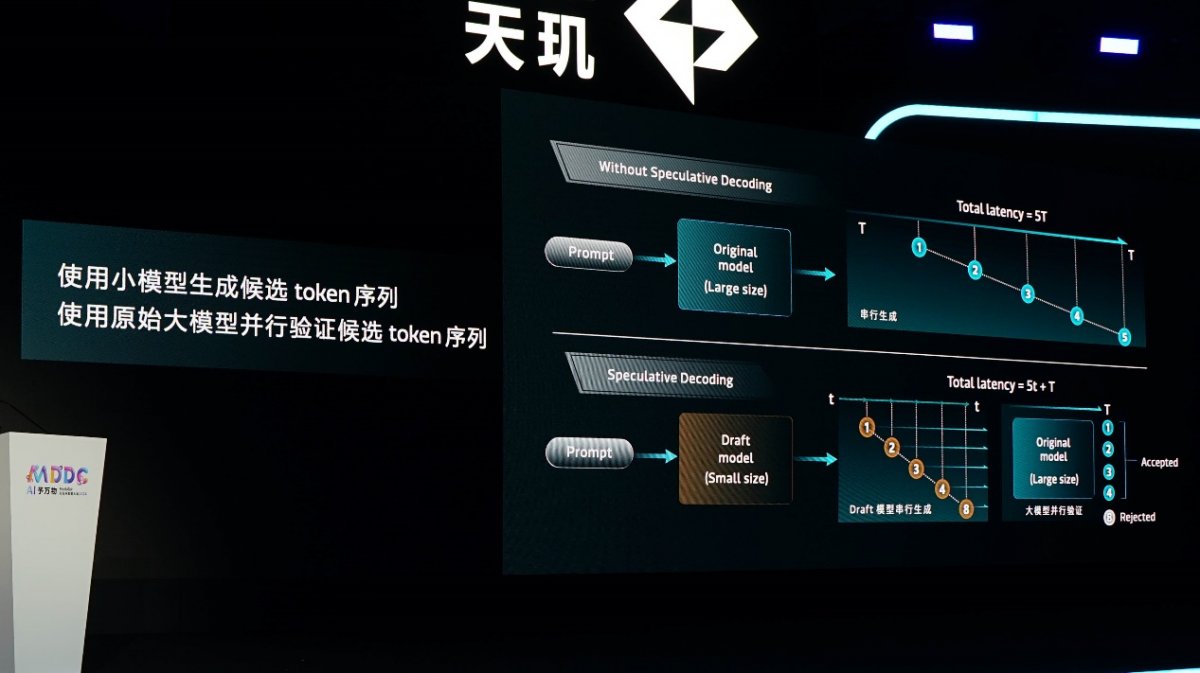

比如说推测解码(speculative decoding)加速——开发者大会上,联发科AI专家解释说这项技术主要是用小模型(draft model)生成候选token序列,同时原始大模型验证该序列,如此能够实现Token生成加速并有效缓解内存访问带宽的瓶颈问题。

联发科提供的数据是,7B参数量的原始模型,加上1.3B以下小模型,token生成可提速1.5-2.1倍。开发者提供预训练好的大小模型,“就能快速部署到天玑平台上,实现token加速”。李彦辑提到的Llama 2 7B参数模型达成22 tokens/秒的生成速度,应该就是基于这一特性实现的。

而所谓的“双LoRA融合”是天玑9300+相较此前天玑9300的进一步提升。LoRA(Low-Rank Adaptation)是现如今生成式AI领域最热门的技术之一了:基础大模型+少量差异,fine-tune为具备新特性的模型。它对端侧部署的价值体现在,多个特性共享一个基础大模型,显著减少模型部署尺寸。

比如说常见的照片风格化,如果总共有4种风格,每种算法占据1.2G空间,则总共需要4.8G。用LoRA方法,则每种风格200MB差分包,加上1G基础模型,总共1.8G尺寸就能达成相同的效果——端侧也能进行LoRA快速切换。工程师说,当这样的LoRA“技能”(即此例中的不同风格)足够多时,单一风格存储成本节省最多90%。

在天玑AI开发套件中,开发者提供预训练LoRA模型,则工具箱就支持端侧部署及LoRA Fusion。发布会上提到的“双LoRA融合”,被联发科称为“天玑AI LoRA Fusion 2.0技术”。应该是能够进一步扩充大模型“技能”,提升生成效率且降低内存占用的方案。

上述推测解码加速,以及双LoRA融合特性,都是天玑AI开发套件的组成部分。如前所述,端侧生成式AI开发工具链资源少。所以“联发科是第一家提出覆盖手机、车机等消费终端设备完整工具链、开发环境的企业”。

从更实际的角度来看,以手机为代表的移动端侧部署生成式AI,本身就有其特有的难点,比如说生成式AI模型要跑在资源有限的端侧设备上,涉及到模型量化、精度维持;移动平台的性能与功耗调校等问题。联发科AI专家提到,最新的大模型优化技术都是从PC平台孵化的,要移植到功耗敏感型设备上难度更大。

天玑AI开发套件的发布“就是个很好的开始”。 套件总体有四大模块,分别是Gen-AI Model Hub,Gen-AI最佳实践,Gen-AI优化技术,以及Neuron Studio——这是个IDE。

Model Hub顾名思义就是个模型库了,现阶段有Llama 2/3, 百川大模型, 通义千问, Stable Diffusion/XL等主流大模型的覆盖——联发科表示还在不断新增更多支持;“Gen-AI最佳实践”涵盖模型量化、编译和推理,强调的是加速大模型的端侧部署,据说能够将原本2-3周才搞定的工作,缩短到1天;

“Gen-AI优化技术”主要包括前文提到的推测解码加速和LoRA融合;还有作为IDE的Neuron Studio是个“可视化AI应用开发环境”——联发科强调说AI应用开发者不需要在不同的工具间来回切换,一个IDE就完成模型修改、编译、平台试运行、一键部署终端等工作。

AI专家在演讲中解析了从模型准备、模型量化,到模型编译和模型推理的全流程。比如模型量化的校准数据集一键生成;模型编译过程中不需要手动做内存与缓存配置,自动匹配优化参数;

以及模型推理步骤原本需要开发者由Python → C++重新编写,尤其要考虑移动端更紧凑的计算资源,开发工具“提供基于天玑平台充分优化后的流程串接通路,C++源码,让开发伙伴什么都不改就能跑起来”,“想做客制化也只需要几步操作”,“节省至少50%的开发时间”。

抖音技术专家介绍说,抖音的SDXL-Lightning文生图模型,基于天玑生成式AI工具箱部署到天玑平台,达成内存峰值4.x G,初始化时间10+秒的整体指标;2step <5秒完成生成

章立(联发科技无线通信事业部生态发展资深总监)表示联发科未来“每年MDDC,工具这块都会有迭代”,而这次发布的版本“是我们交的第一份答卷”,“明年我们的工具会更强大”。

在我们看来,整套开发工具强调的是“一站式”和尽可能的“自动化”。 还是那句话,虽然联发科没怎么谈在软件上下的功夫——对开发者而言,“自动化”和“一站式”本身就是在尝试隐藏开发的更多复杂性;而这些复杂性无疑是需要联发科买单的,或者说浓缩了联发科与模型厂商、操作系统供应商、OEM厂商等角色间的合作。

所以本次宣布的“天玑AI先锋计划”一方面是强调与下游应用开发者的合作与扶持;另一方面则是和模型、OEM厂商等角色的联合协作。毕竟移动生成式AI生态要建起来,光靠联发科做芯片、做工具必然是不够的。想必明年的MDDC上,这一计划的名单会做持续扩充。这也是联发科作为移动生成式AI生态核心角色,举办MDDC,聚拢各层级合作伙伴的意义所在。

RWKV作曲,能够基于用户给出的少量音符完成整首乐曲的创作

这其中有个问题很值得探讨:为什么是联发科这样的芯片厂商作为核心去发展AI生态,而不是操作系统、模型或OEM厂商。该问题同样适用于PC、数据中心领域。对模型、OEM厂商这样的下游而言,这些角色各自不同的策略方向不利于构建更大的AI生态。

于上游,有观点认为,和图形渲染生态前期标准、API不统一的情况类似,当年芯片厂商自为政,直到GPU硬件架构趋同,以及中间层标准出现(如DirectX, Vulkan),芯片厂商才不再担纲领衔生态的角色。

趋势可能仍有待观察,不过和早年图形生态发展时代有所不同的是,现在的时代背景是摩尔定律迟滞,而应用尤其是AI应用仍然非常渴求算力。这使得上层应用开发者、模型供应商尝试直接与芯片企业合作。此时更多的中间角色都将无益于算力获取。所以英伟达没有打算让渡CUDA的生态核心地位,Intel似乎也不打算在PC上将AI生态话语权交给微软。

移动AI生态起步相对更晚,未来格局未为可知。另外移动与嵌入式领域,芯片与操作系统的耦合深度又与数据中心、PC不同。但无论如何,我们认为芯片厂商在此局中的话语权,必然远大过当年图形生态发展期。就连EDA厂商现在都在强调芯片设计“以应用为导向”,可见价值链重心正在变化:就看未来各层级参与者入局,移动AI生态是否会收敛了…

只不过联发科的行动的确相当早。手机作为生成式AI最早能够见到的移动端载体,后续扩展到车机、PC、IoT等端侧,联发科正在构建的天玑AI生态是在为未来做准备。竞争对手尚在谈自家芯片能跑多大参数规模的AI模型时,联发科已经尝试站在生态中心,呼唤生态粘性了。“当别人还在说模型支持的时候,我们已经从用户角度去看应用了。”

陈冠州在圆桌环节则总结现在联发科在做的事情是规范化和优化。“规范适合由平台厂商提出;且端侧相比云端算力有限,生态和标准肯定是芯片厂来做。”而构建起生态与标准,做规范与优化的目标,还是为应用开发者提供环境,让应用来填充生态。

MDDC活动现场,我们还是看到了不少开发者围绕天玑AI生态开发出的AI应用。比如文首提到的全民K歌“AI歌声”;再比如Soul APP,基于大语言模型+Stable Diffusion打造所谓的情感陪伴AI对话(下图),和不同的形象做图文聊天,而且是完全在端侧本地推理——这其中就引入了LoRA达成单一模型的多风格虚拟人物切换;

还有MOBA类游戏的AI游戏教练、虎牙直播AI换脸、酷狗音乐的歌词生图、火山引擎的AI创作SDK套件实现端侧图片/视频的AI创作;还有诸如车机平台对话式的操作指引、新闻智选等……联发科甚至在想借助生成式AI于手游中,打造类似NVIDIA ACE技术那样,能与玩家自然沟通、且千人千面的NPC。

不过或许更多人关心的还是生成式AI的杀手级应用——圆桌环节,主持人问了个问题:生成式AI的杀手级应用未来多久会问世。现场至少6成观众认为1-2年内就会出现,3成观众认为需要3-5年,不到一成选择了5年以上。这表明开发者对生成式AI于端侧的发展整体还是相当乐观的。

章立是这么描绘对杀手级应用的预期的:“我们是将土壤、环境、阳光、水培养好,种子撒下去,就能确保这里能够长出大树。”对于端侧应用创新的沉寂,“生成式AI给了很多开发者新的机会”,“一个技术能够带来创新的用户体验,就不用担心是否会出现爆品”,“一定会有爆品涌现。”

与此同时,章立也提到“存量头部app”正在生成式AI化,比如抖音顺理成章应用AI视频风格,手机摄影的高倍率变焦用生成式AI补全细节,以及手游的潜在AI超分特性等——它们在生成式AI时代之前就已经是杀手级应用了。

这些都是潜在的杀手级应用或发展机会。不过在我们看来,联发科于主题演讲环节表达了属于生成式AI真正的杀手级应用潜力:交互方式的革新。

17年前,人与手机交互主要依托于键盘;智能手机时代,触控替代键盘成为新的交互方式,且因此涌现了大量新的应用,生产力、娱乐、社交等等,创造了难以估量的市场价值;随后,在某些特定场景,例如行车过程、智能家居使用等,语音VUI贡献了新的交互形式…

当包括手机、车机、PC等在内的计算机系统变得异常复杂,人们已经记不住繁琐操作流程,更不清楚系统海量特性,而且个性化需求与日俱增;则上述交互方式都不再适用。以生成式AI为基础的所谓“智能体”(Agent AI),此时可提供最符合直觉的交互体验。

比如当车机智能体掌握数百页的汽车用户手册,则用户要执行有关汽车的某项操作只需要说句话——这句话涵盖的指令序列对计算机而言可能非常复杂,但对用户而言,就只是一句话的问题。实际上现在已经逐渐流行的AI通话摘要、会议记录、私人助理等都属于“智能体”交互。

现有的手机生成式AI应用中,这一雏形典型如通义千问AI智能体,通过与用户的对话、分析需求、形成任务,调用三方应用完成任务。现在我们还很难说这是个杀手级应用,但随生成式AI技术发展和能力强化,这种智能体交互成为日常交互的常态,则它自然就在潜移默化中成为了杀手级应用。

“现在我们主要还停留在语音或文字,将来多模态也会有影像、视频。”“另外还包括专家系统(MoE),具备各式各样不同的专家能力,随时根据需求做切换。”李彦辑在展望未来时候说,“在端侧实现这样的能力,也是在不久的将来了。”

胡志鹏(网易集团高级副总裁、网易雷火游戏事业群CEO)在圆桌讨论时说,AI发展很快,“今天说的话明天可能就不作数了。2017年Transformer发明,现在看来那已经是史前时代了;而AlexNet大概可以叫超史前时代。”

“几个月前20亿参数(模型)已经比半年前70亿参数(模型)还要聪明了。”陈一强(联发科无线通信事业部副总经理)谈到,“生成式AI的发展很快。”“它会改变交互方式,彻底颠覆应用模式,包括软件系统架构设计。”

虽然本文没有提及,但包括光线追踪在内的图形生态建设也是本次MDDC的重要组成部分…

大会开场时,陈冠州谈到过去一年,全球AI系统建设支出打到了惊人的1540亿美元。生成式AI正在给半导体产业带来极大的潜在市场机会。

主流行业分析师此前原本预期2030年半导体市场价值会超万亿美元。但在生成式AI面前,万亿美元估值显得如此保守,所以才会有传言中Sam Altman的7万亿芯片计划。而在这其中,端侧生成式AI作为无可争议的产值大头,潜力无需赘言。

我们从首届MDDC看到的,不仅是联发科率先布局构建移动生成式AI生态,在生成式AI时代于端侧先发制人,天玑从过往更多人认知中单纯的芯片产品,转向了联合上下游的生态;还包括芯片企业正尝试主导AI生态,俨然成为价值链上的主角。这是在过去的移动时代,我们都不曾见过的。 那么大约2年以后,生成式AI快速发展下的移动体验大概都会和现在大不一样了。

最前沿的电子设计资讯

最前沿的电子设计资讯