高带宽内存(HBM)芯片由于能够有效地处理具有较高内存要求的复杂算法,因而改变了人工智能(AI)应用的游戏规则。此外,HBM还解决了内存带宽这一关键瓶颈,更成为AI应用中的主要构建模块。

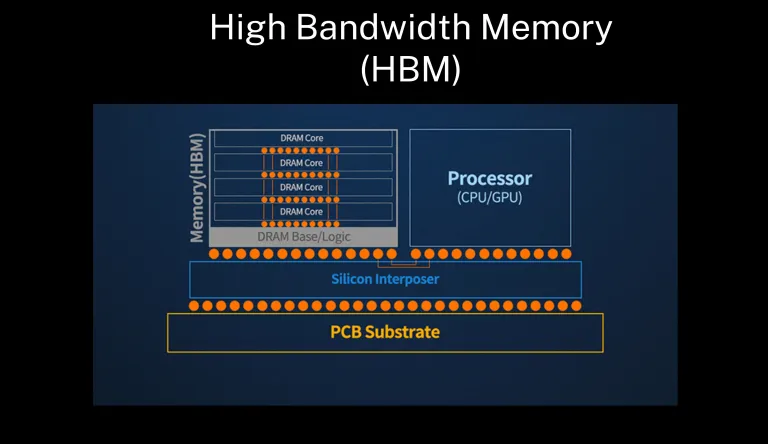

图1:HBM由许多以TSV互连垂直连接的DRAM芯片组成。内存芯片堆栈位于连接至处理器的逻辑芯片顶部。(来源:Gen AI Experts)

三星电子内存产品规划团队首席工程师Jinhyun Kim指出,AI和机器学习(ML)推理的主流化导致了HBM的主流化。但是,AI和HBM之间密切相依的这段“恋情”最初是如何开始的呢?

正如Objective Analysis首席分析师Jim Handy所说,GPU和AI加速器有着令人难以置信的高带宽需求,而HBM能够帮助它们达到目的。“如果你尝试使用DDR来完成这项任务,最终将必须使用多个处理器,而无法只以一个处理器来完成同样的工作,而且处理器的成本最终将超过你从DRAM所节省的成本。”

AI模型需要同时处理大量数据,而DRAM芯片越来越难以跟上复杂的AI模型日益增加的要求。另一方面,HBM芯片采用3D堆叠架构,提供明显高于传统DRAM的带宽,从而有利于缩短数据路径,加快了处理器与内存之间的通信速度。

这使得AI应用可以在更大、更复杂的数据集上进行训练,进而建立更准确且更强大的模型。此外,作为3D堆叠DRAM的内存接口,HBM可堆叠多达八个DRAM芯片和一个可选的基础芯片(其中包含缓冲电路和测试逻辑),在外形尺寸上明显小于DDR4或GDDR5,并因而降低了功耗。

接下来,每一代HBM都会根据最新GPU、CPU和FPGA的发布情况进行改进。例如,HBM3的带宽跃升至819GB/s,每个HBM堆栈的最大密度增至24GB,以管理更大的数据集。

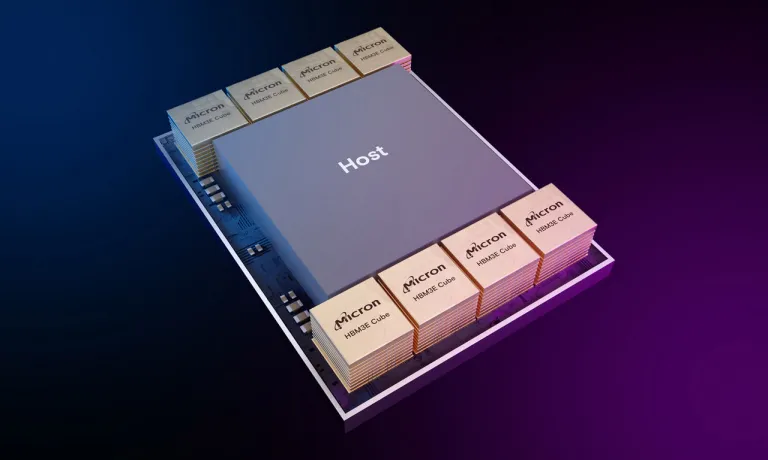

图2:AI设计中的GPU和FPGA等主机设备因其更高的带宽需求而采用HBM。(来源:Micron)

AI应用中的神经网络需要大量数据进行处理和训练,仅训练集每年就增长约10倍。这意味着对HBM的需求可能会进一步增长。

值得注意的是,HBM芯片的市场仍在不断发展中,而且HBM芯片并不局限于AI应用。这些内存芯片在高性能计算(HPC)和数据中心等的应用也正与日俱增。

(原文刊登于EDN美国版,参考链接:Why HBM memory and AI processors are happy together,由Susan Hong编译)

最前沿的电子设计资讯

最前沿的电子设计资讯