汽车厂商正从安装传统域架构中执行特定功能的黑盒解决方案,转向基于分区架构和功能自主的处理主干网络,并由其中每个节点负责处理特定位置的数据。

伴随这一趋势,传感器功能优化也成为关键,通过多模态数据的融合和机器学习(ML)实现情境感知。传感器不再仅仅用于单一功能,而是可以用于一系列汽车系统中,例如驾驶员监控系统(DMS)和智能门禁系统等。因此,摄像头和传感器的数量得以减少,功耗也得到了优化。

在CES 2025的多个展位中,我们看到了针对汽车的一系列解决方案。

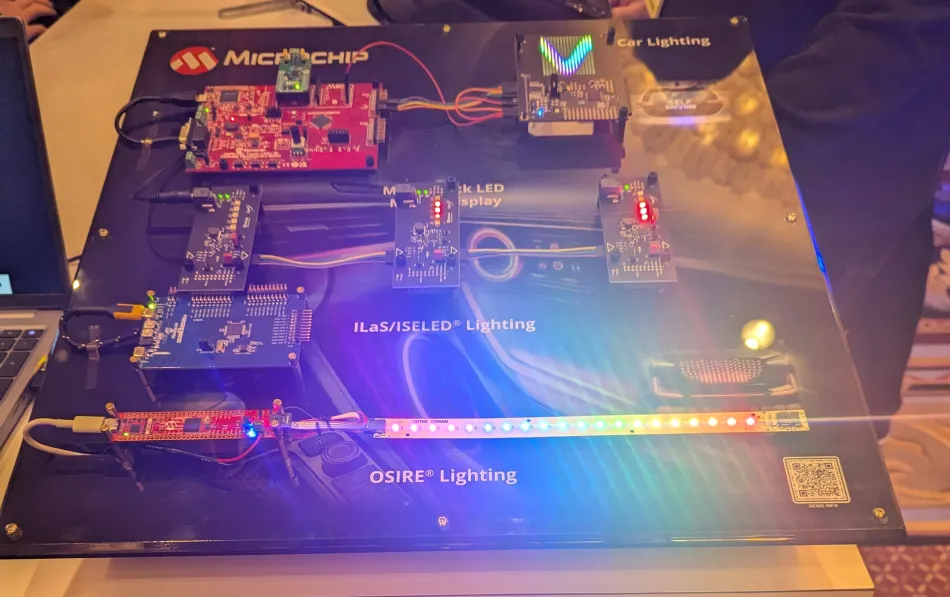

Microchip的智能嵌入式LED (ISELED)、ISELED灯和传感网络(IlaS),以及Macroblock照明解决方案,如图1所示。ISELED协议解决了每个LED需要外部IC控制单个色彩/亮度的问题。取而代之的是,Microchip将智能ASIC集成到每个LED中,整个系统可以通过一个简单的16位MCU控制。该解决方案不仅提升了灯光造型灵活性,还增加了一些其他使用案例,例如通过显示器上的矩阵照明文字播送汽车的状态等。

图1:Microchip ISELED照明解决方案,可单独控制每个LED的色彩和亮度。

ADI 10BASE-T1S以太网络到边缘总线(E2B)技术用于作为车身控制和汽车照明连接解决方案,虽未直接控制LED,但可用于更新采用该10BASE-T1S以太网总线的OEM汽车照明系统。

儿童车内遗留检测(CPD)和乘客监测系统(OMS)是CES的热门主题,许多公司展示了他们的超宽带(UWB)检测和/或测距技术以及60GHz雷达芯片等产品。推动这一发展的主要原因来自于OEM面临的严格安全法规的压力。例如,欧洲Euro NCAP计划仅对采用CPD直接传感系统的OEM车厂提供奖励。针对UWB传感,典型配置是在车内外放置UWB节点,以检测装有UWB的手机。

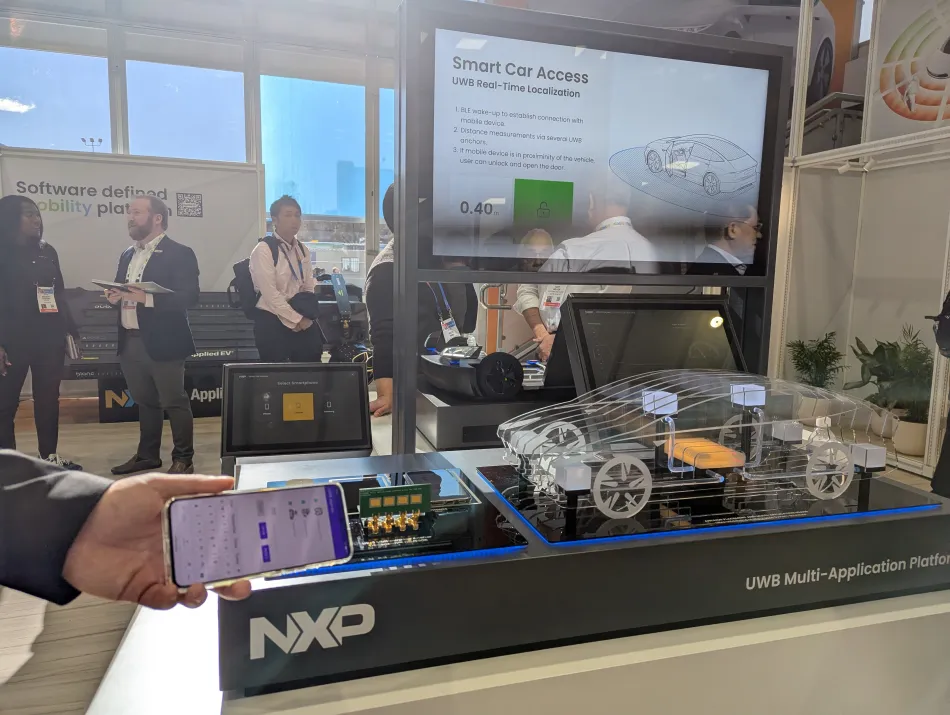

NXP展出的车用UWB解决方案(图2)展示了UWB雷达可识别手机与UWB节点的距离、如何通过UWB测距功能与飞行时间(ToF)测量解锁汽车。同样的原理还可应用于智能门锁或火车站的自动通行系统,让预购火车票的乘客可以从站外通过闸机进到站内。

图2:NXP的车用UWB雷达智能汽车门禁解决方案。

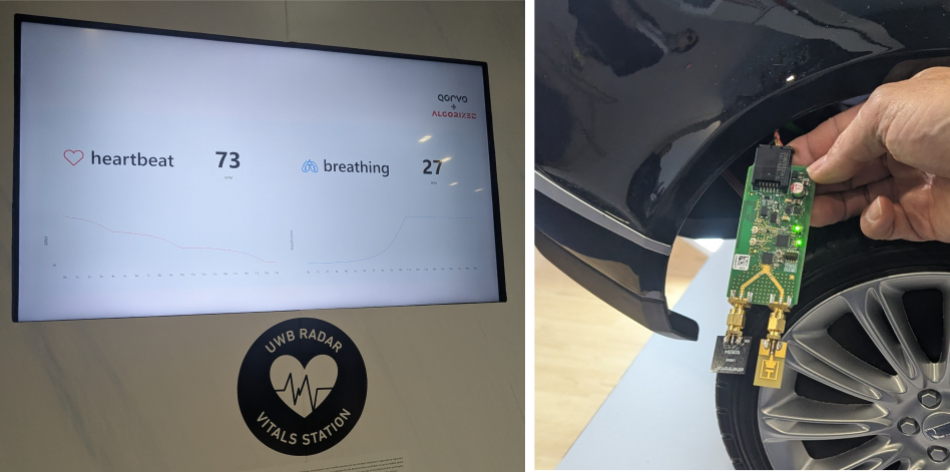

Qorvo也展示了其UWB解决方案。图3展示了在玩具车上的一个UWB节点,可用于无钥匙进入。另一项展示强调雷达(UWB或60GHz)的生命体征监测应用:呼吸和心跳检测。

NXP的工程师解释了UWB的基本应用流程:该技术可测量乘车者的信号反射,以检测例如胸部扩张/收缩的频率,从而测量呼吸频率。这样就能通过算法直接检测乘客,从而判断车内是否有儿童,并通过既有的传感器基础架构,提供CPD、OMS、入侵与接近警报,以及许多其他功能。很显然地,无线芯片的数量并无明确的答案,但明显的能感受到的是传感器越来越智能化,以尽量减少组件数量——单个雷达芯片就可以省去五个座内重量传感器。

图3:Qorvo与其他公司合作的UWB智能门禁(免钥匙)与生命体征监测解决方案。

从图4可看到TI展示的CPD、OMS和驾驶监控系统(DMS),以及其60GHz雷达芯片与摄像头的组合。由于60GHz雷达波长短,能提供更高的分辨率,因此这套系统在CPD应用上可能会更精确。然而,使用60GHz雷达最明显的好处可能是单一模块即可取代CPD、OMS、入侵检测、手势检测等6种UWB模块。然而,这并不能完全避开UWB技术,UWB的测距功能可以实现精确的智能门禁,但这对60GHz技术而言可能并不实际,尤其是考虑到该频率的大气吸收。

图4:TI在CES展示其CPD、OMS以及DMS等系统。

多个展位展示了用于自动驾驶(AD)和高级驾驶辅助系统(ADAS)功能的汽车全景摄像头。Microchip的解决方案如图5所示,其串行器应用于三个摄像头,传输速度高达8Gbps。Microchip的解串器则被配置为接收视频数据,并通过Automotive SerDes Alliance Motion Link (ASA-ML)标准汇聚数据至中央计算或高性能计算机(HPC),仿真分区架构。

图5:Microchip的ASA-ML标准360度全景解决方案。

ADI还展示了一个支持Gigabit多媒体串行链路(GMSL)的串行/解串器(SerDes)解决方案。GMSL的特色在于其轻量级设计,单线缆即可双向传输高达12Gbps的数据,从而显著减轻重量。

图6:ADI GMSL展示将六个摄像头的数据汇聚到解串器板中,并传送至Jetson HPC平台上的单个MIPI端口。

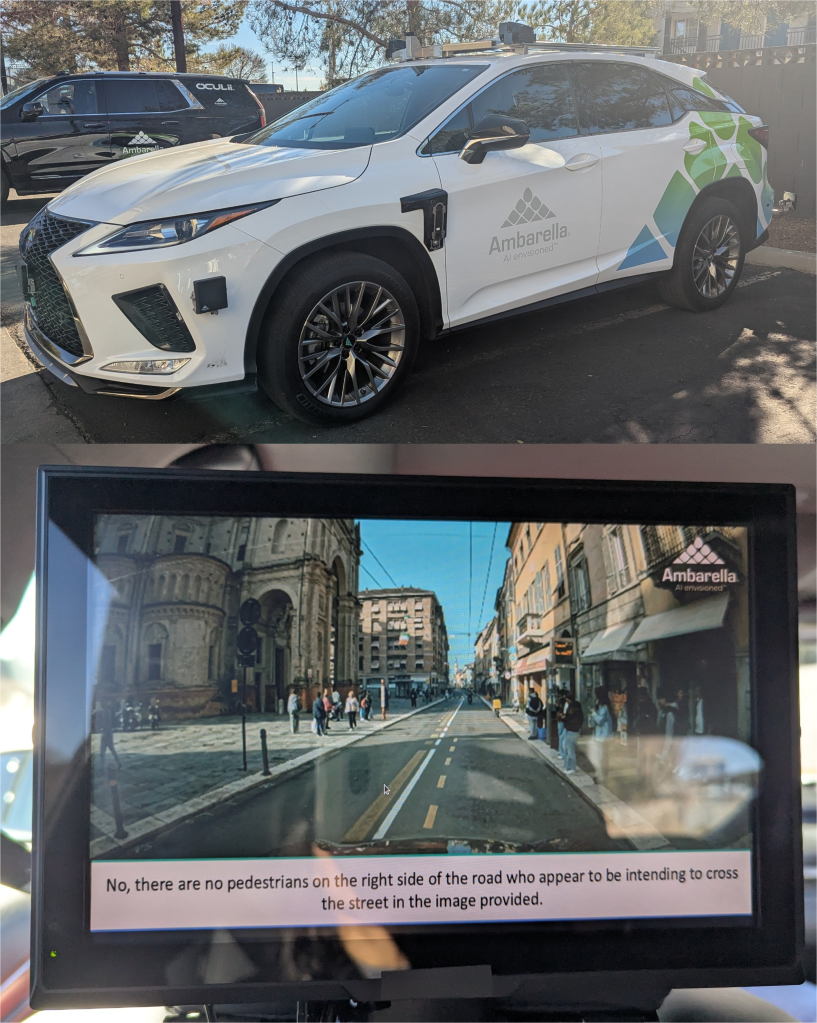

专注于AI视觉处理器的Ambarella公司展示了一个有趣的自动驾驶应用,其于堆栈中集成了大语言模型(LLM)。该技术最初由意大利初创公司Vislab开发,现在该公司是Ambarella旗下的汽车研发中心。这套系统包括6个摄像头、5个雷达以及Ambarella CV3汽车域控制器,可实现L2+至L4级的自动驾驶。通过使用视觉语言模型(VLM)LLaVA-OneVision,可实现更多情境感知决策。

Vislab创始人Alberto Broggi在展示中解释了在自动驾驶场景中利用LLM的好处:“假设你拥有世界上最好的感知系统,可以感知一切以及定位汽车、行人等。然而,你仍然会遇到一些模棱两可的情况。”他举例说明了这些情况:“如果你的车道前面有一辆车,你不知道是否可以超车,因为这取决于当时的具体情况。如果那是一辆抛锚车,显然可以超车;如果那是一辆等红灯的车则不行。因此,你需要更高层次的描述和背景信息。”

图7展示了VLM在实际应用场景中如何提供情境感知和建议。

图7:Ambarella的VLM自动驾驶展示,提供了情境感知和决策建议的应用场景。

(原文刊登于EDN美国版,参考链接:Automotive design insights from CES 2025,由Susan Hong编译)

最前沿的电子设计资讯

最前沿的电子设计资讯