视觉AI已不再依赖CNN——接下来会如何发展?

多年来,卷积神经网络(CNN)在人工智能视觉领域一直占据主导地位,广泛用于自动驾驶辅助、人脸识别、视频监控等场景。但现在,行业已经转向——视觉Transformer(Vision Transformer,ViT)现已被公认为在很多计算机视觉任务中表现更优。ViT能理解全局信息,具备抗干扰能力,并能处理复杂场景,已经成为视觉AI的新标配。h0Xednc

现在大家已不再讨论“ViT是否会取代CNN”。它们已经完成了这场超越。现在新的挑战是:如何让ViT高效运行在真正为它量身打造的硬件上。h0Xednc

本文将探讨ViT成为首选的原因、ViT的关键不同之处,以及要最大限度地发挥其的性能,哪些硬件功能必不可少。h0Xednc

h0Xednc

h0Xednc

h0Xednc

为什么视觉Transformer会全面胜出?

CNN用自下而上的方式处理图像,从边缘到特征逐层提取,最后识别出完整的物体。这种方法对于干净、理想的图像效果很好,但若遇到遮挡、图像损坏或对抗性噪声时,就容易出错。而Transformer是在整体上对图像进行分析,通过注意力机制理解图像中各区域之间的关系。h0Xednc

《量子杂志》曾用一个生动的比喻说明:“CNN像是从单个像素开始逐步放大;Transformer则像是慢慢让整幅模糊图像逐渐聚焦。”h0Xednc

这种方式使得ViT具有显著优势:h0Xednc

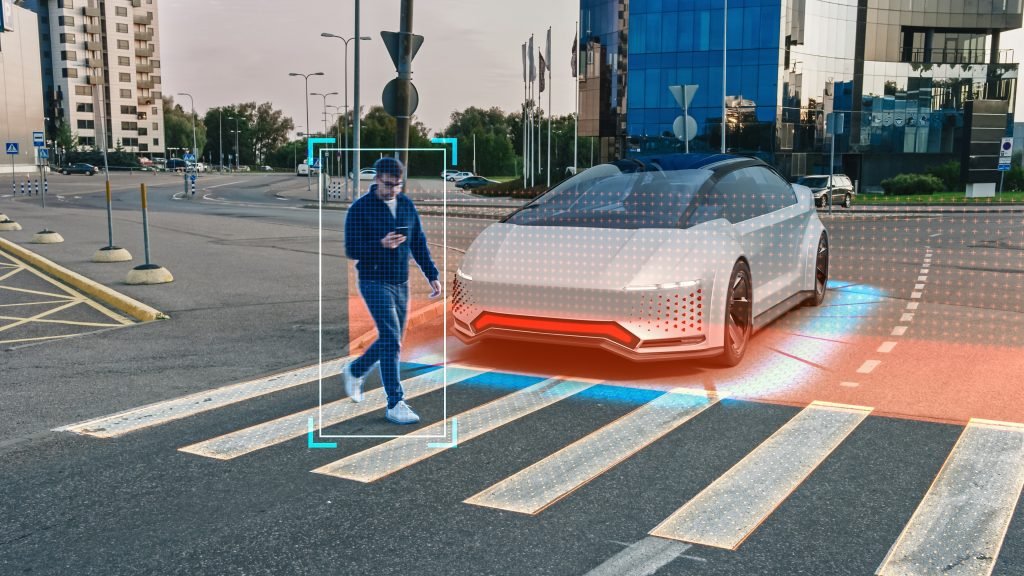

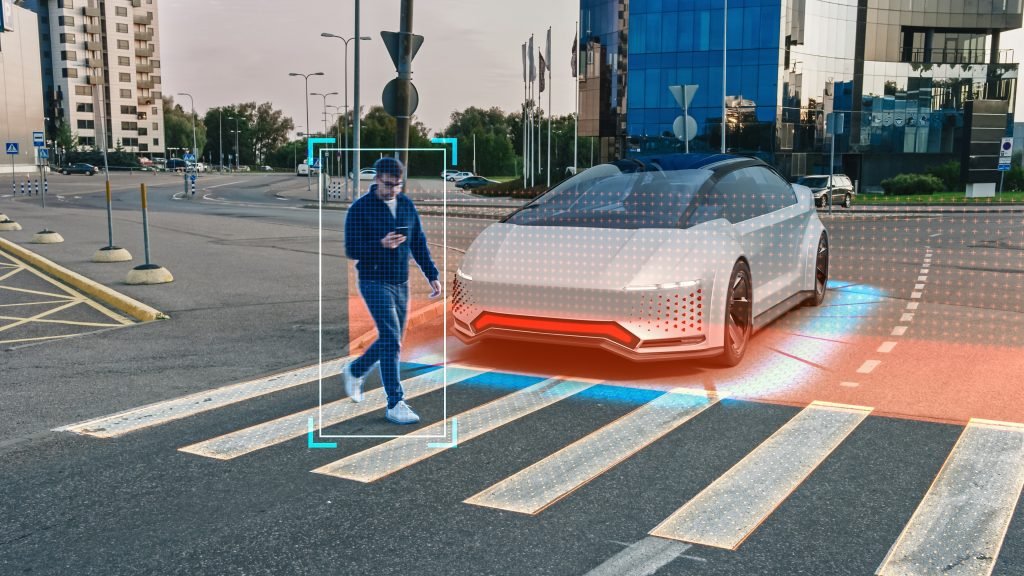

- 复杂场景中的卓越物体识别能力——CNN专注于局部特征,而ViT不同,它考虑的是全局背景,因此在杂乱的环境中(如部分被车辆遮挡的行人),ViT表现远优于CNN。

- 更强的抗干扰能力——CNN容易被细微像素扰动误导(如将停车标志误识别为让行标志)。ViT的整体性分析使其更难被干扰。

- 更优的场景解析适应性——像自动驾驶这样的任务,不只需要识别物体,还要分割场景、规划路径。ViT在这些方面表现非常优秀。

当然,这些优势需要代价:ViT计算复杂度高,对算力的需求远超CNN。因此,当下的研究焦点转为了AI硬件优化。h0Xednc

h0Xednc

h0Xednc

h0Xednc

什么样的硬件才能真正释放ViT的潜力?

要让ViT在边缘AI应用中发挥全部实力,底层硬件需针对其独特计算需求优化。支持ViT的神经网络处理器(NPU)需具备以下能力:h0Xednc

- 高效的注意力机制加速——ViT依赖矩阵乘法与注意力层,而非CNN的卷积运算,硬件需针对性优化,必须有能力快速处理这类计算流程。

- 混合数据类型支持——ViT的注意力计算需浮点精度,而多层感知机(MLP)阶段则可用低位整数(如INT8),硬件需平滑切换。硬件必须流畅无阻地处理这种过渡。

- 结构化与非结构化稀疏计算加速——ViT存在大量冗余计算(如零值乘法)。高效硬件可跳过这些非必要步骤,提升速度与能效。

- 高吞吐量定制算子——将计算任务安排在外部加速器通常会拖慢推理速度。相反,硬件必须将定制算子与Transformer核心集成到同一流水线中,才能实现最高效率。

- 并行与多核心计算能力——场景分割与理解需大量并行运算。要高效完成此类任务,多引擎支持不可或缺。

- 模型压缩与剪枝支持——ViT参数量巨大,可达数十亿。支持剪枝和压缩的硬件,可最大限度地减少加载时间和内存压力。

- 片上处理减少内存瓶颈——部分先进的ViT方案可直接在本地设备端运行,无需外部内存,显著提升边缘AI效率。

未来已来:ViT专用硬件是下一站

视觉AI正迅速演进,ViT已在自动驾驶、安防等关键领域超越CNN。下一挑战在于确保NPU硬件在高效支持ViT的同时,兼顾能效与实时性。h0Xednc

h0Xednc

h0Xednc

责编:Ricardo

最前沿的电子设计资讯

最前沿的电子设计资讯