日前,在中国电子信息博览会、深圳国际大数据与存储峰会暨Web3.0中国峰会上,西部数据公司副总裁兼中国区业务总经理刘钢发表了“创新存储架构,突破IPFS算力瓶颈”主题演讲。其内容与Web3.0相关,“因为Web3.0的核心技术就是IPFS。”刘钢指出。

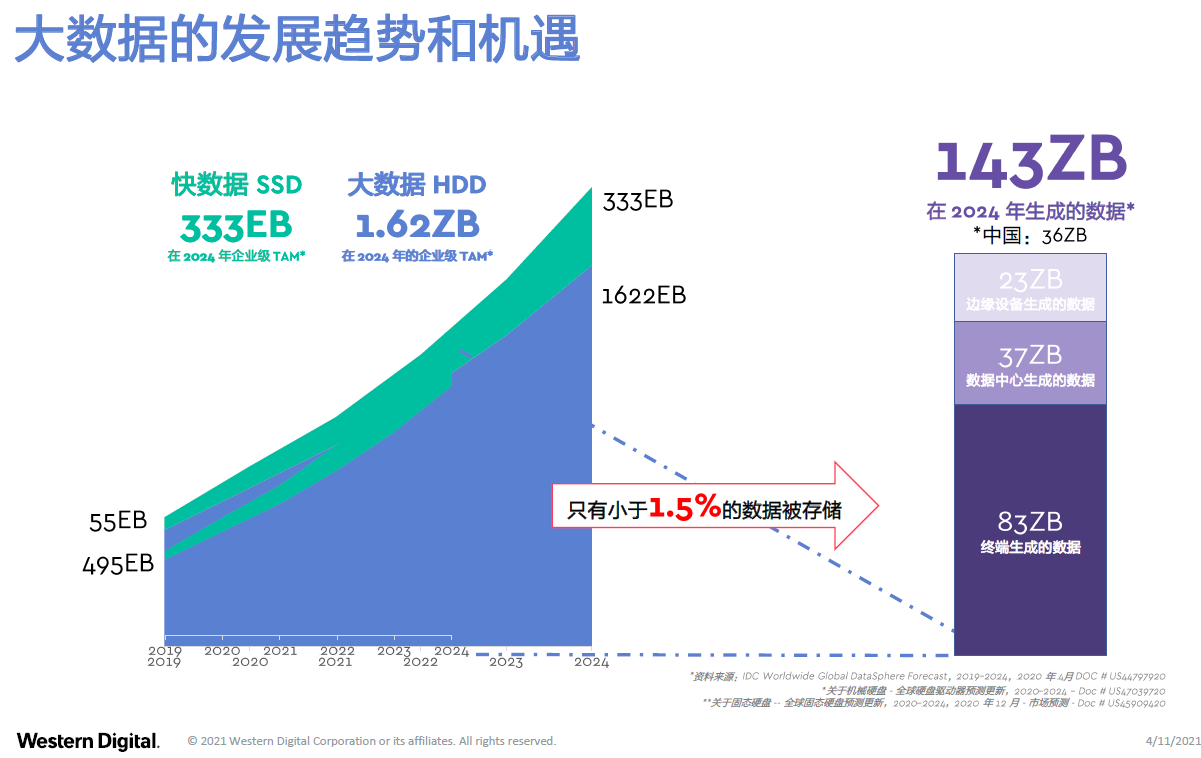

首先他分享了大数据在未来几年的发展趋势。可以用两个数据来标志大数据存储的发展速度。

2024年,以HDD为代表的大数据预计将增长到1.62ZB,因此从现在开始到2024年,年化增长率在30%左右。除了大数据以外还有快数据,“因为我们不仅想把数据存储下来,还希望能够对数据进行挖掘、进行计算,来为客户的商业提供帮助。”刘钢表示。

快数据是以SSD作为衡量标志。SSD在2024年预计将达到333EB,与HDD加在一起大概有2ZB左右。“这是非常快速的增长,因为SSD的增长几乎接近50%,相较于大数据HDD 30%的增长,这个增长是非常快速的。”他补充说。

但是把它与当年产生的数据相比还是很小,几乎只有1.5%的数据被存储了。“因为在2024年产生的数据有143ZB,大数据只存入了1.62ZB,快数据333EB(0.333ZB),所以加在一起也小于当年产生的数据的1.5%。”他解释说。

为什么会这样?“在数字经济时代,数据就是石油,就是发展的动力。那么多宝贵的石油或者资源为什么没有被存储下来,没有进行挖掘、进行分析处理?很重要的一个原因是因为存储的架构和存储的技术没有及时地跟上,以至于有很多数据被浪费掉了,没有办法被存储下来并及时使用。所以我们需要创新存储架构来为更多的数据提供海量的存储,并且能够快速地访问。”刘钢说。

在提到突破存储架构的时候,可以看到数据存储面临下面几个方面的挑战。总结来说就是用户既需要大容量,也需要快速访问,又需要低成本,还需要低功耗。那么有没有一个存储设备或者一种存储介质能够同时满足这四个方面的需求?

“其实你很难找到一个存储介质、存储设备能够同时满足这四个方面用户需求。然而好消息是,当你创新存储架构的时候,你有可能作为系统来满足用户各方面、各种存储场景的需求。因为用户的数据是要进行分层的,用户数据也是有不同的类型,它对存储的要求也是不同的。”刘钢谈到。

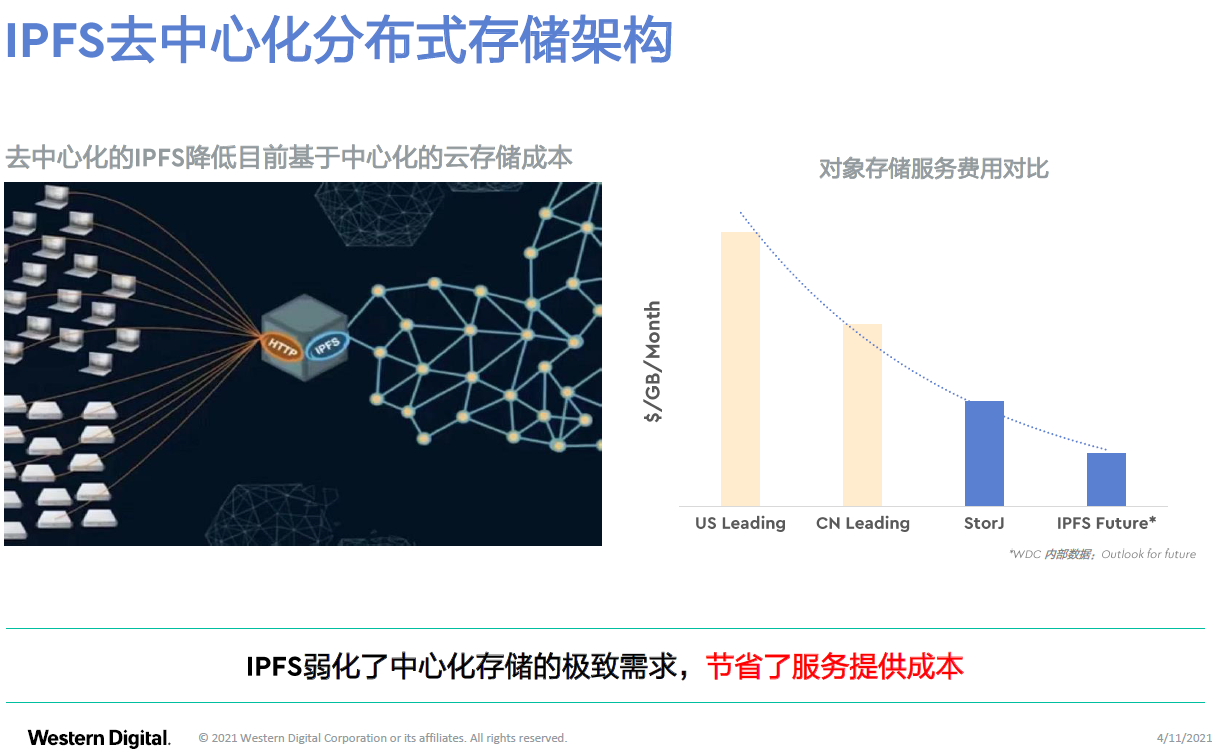

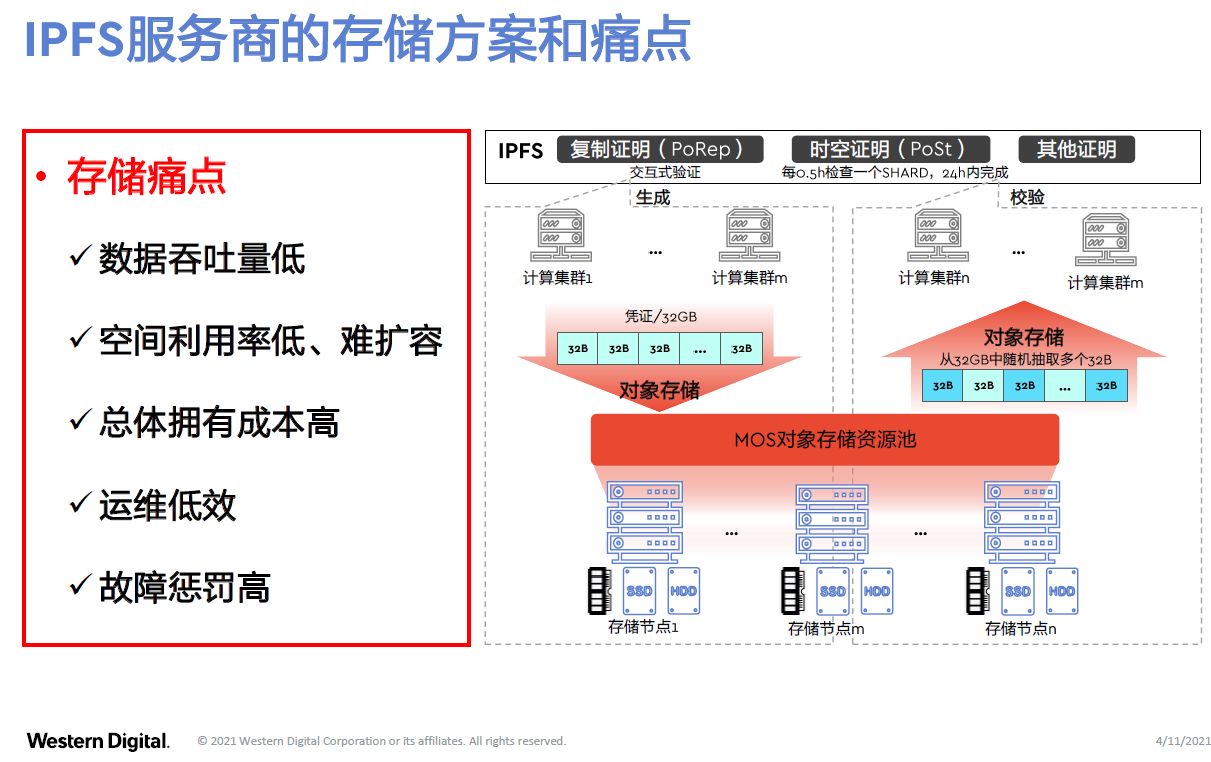

首先来看下对存储架构的创新——分布式存储架构。“我们知道,存储架构有中心化的云存储,还有去中心化的分布式存储。就像Web3.0或者各种IPFS方案,它们就是去中心化的分布式存储。它跟原来的云存储有很大的不同,它有可能会通过新的存储架构来降低成本。”刘钢指出。

从上面的数据可以看出,传统的云存储给用户提供服务的时候,它的成本大概是什么样的。其实在IPFS之前,早就有一个分布式的去中心化存储的架构叫做Storj,我们可以在网上找服务、购买服务。而IPFS在去中心化方面可以进一步地做优化。

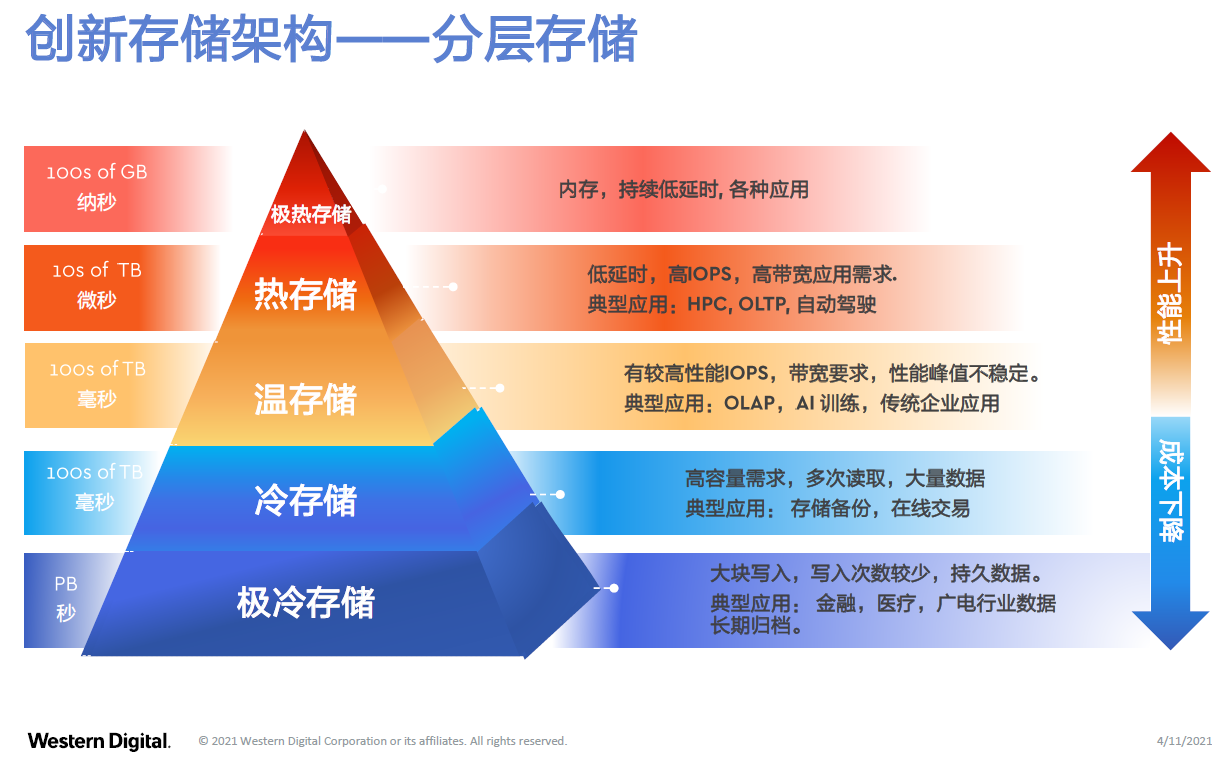

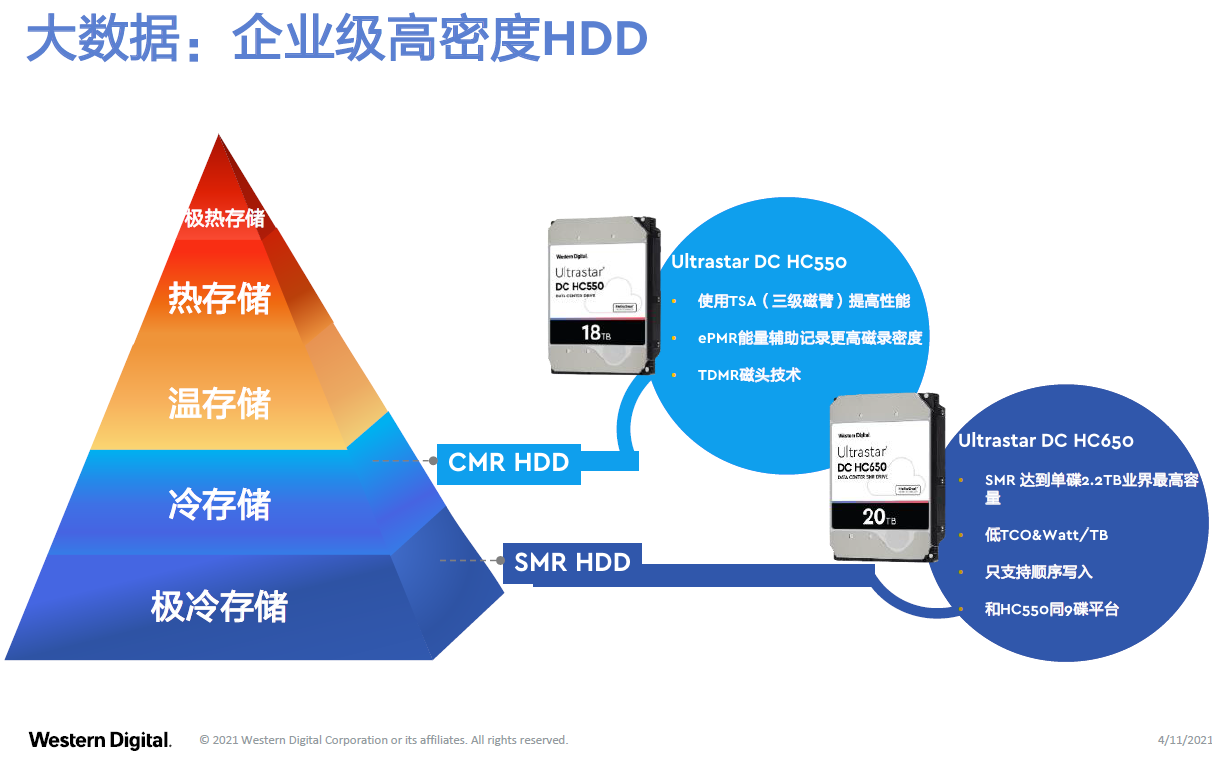

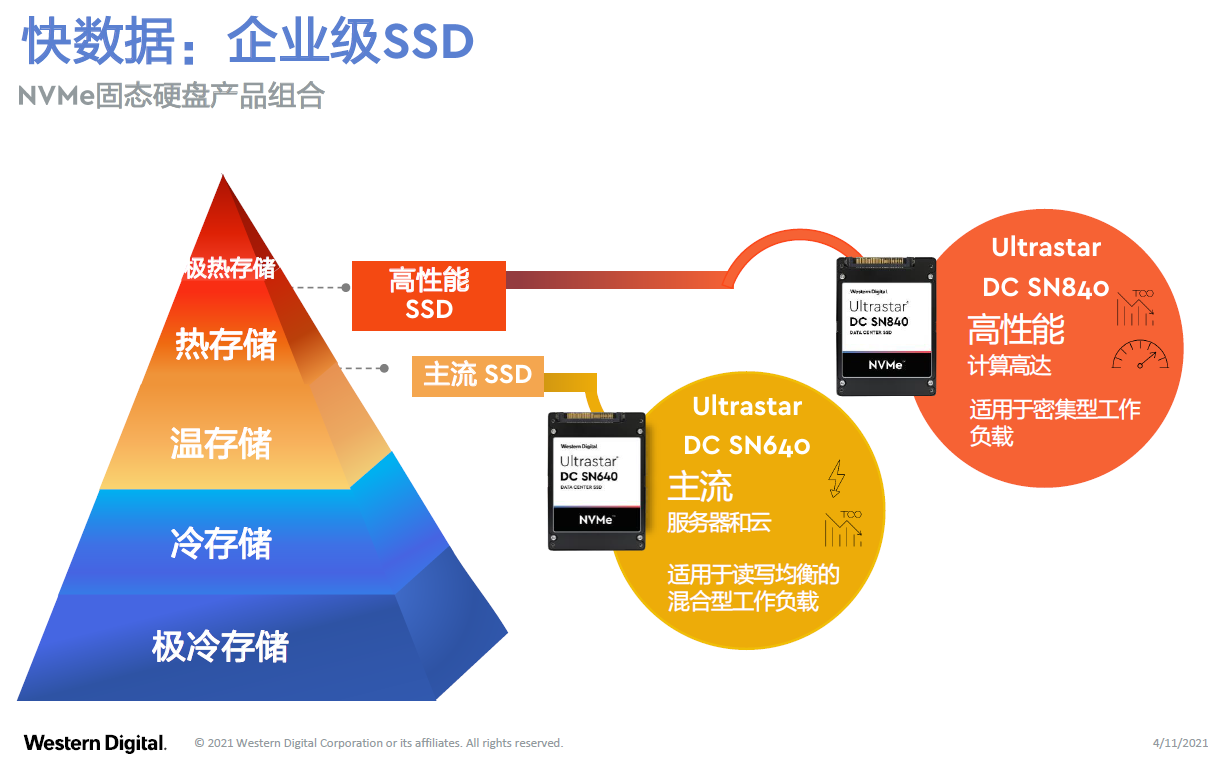

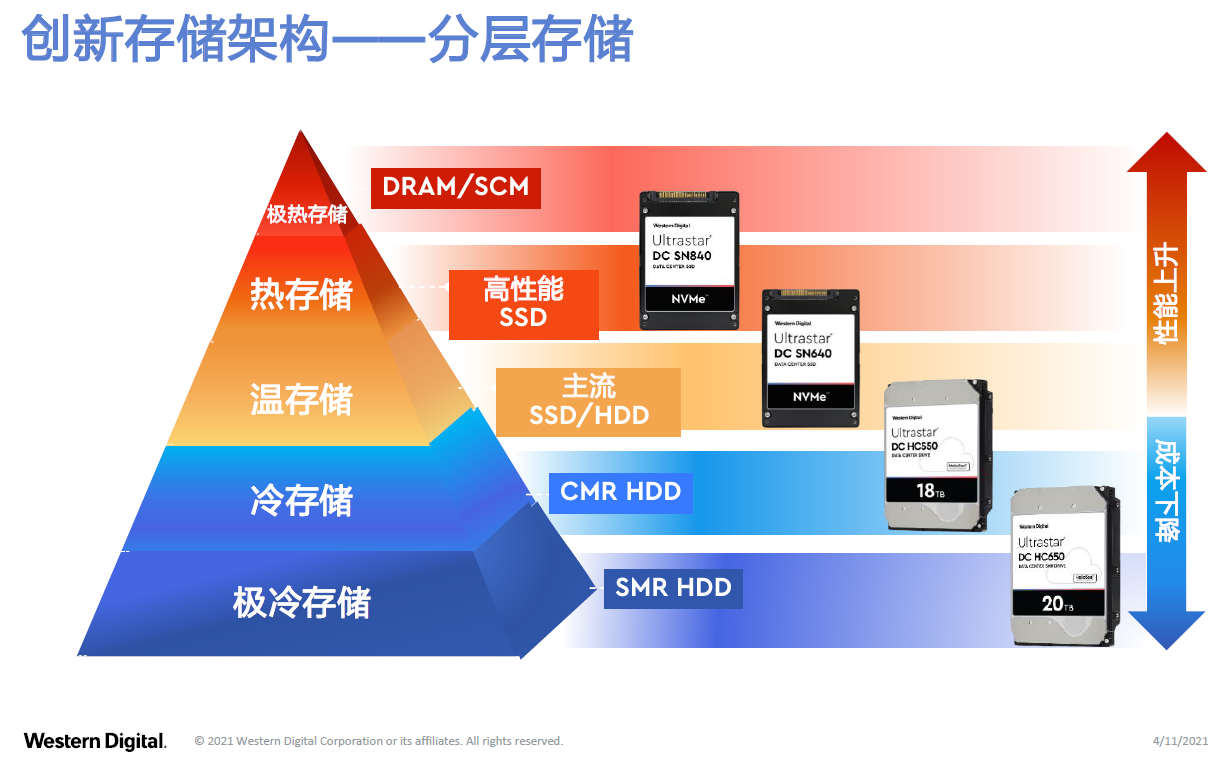

除了存储架构以外,对于数据的价值,可以将它简单分成五层:极热数据、热数据、温数据、冷数据和极冷数据。

对不同层的数据,所要采用的存储介质和存储的设备是不一样的,这样才能够既有海量存储的大数据,又能对快数据提供快速的访问。“根据数据对时延和容量的要求,我们把数据分成这五层,并且划分了对应的应用场景。”刘钢介绍说。

刘钢继续说到:“首先来看大数据部分,针对冷存储和极冷存储,现在业界通常用的方案是高密度的大容量企业级硬盘。这个部分的发展,已经进化到了18T的高密度企业级硬盘。甚至针对极冷数据,有公司利用软件与技术优化,采用了SMR叠瓦式的硬盘,能做到20T的高密度企业硬盘。”

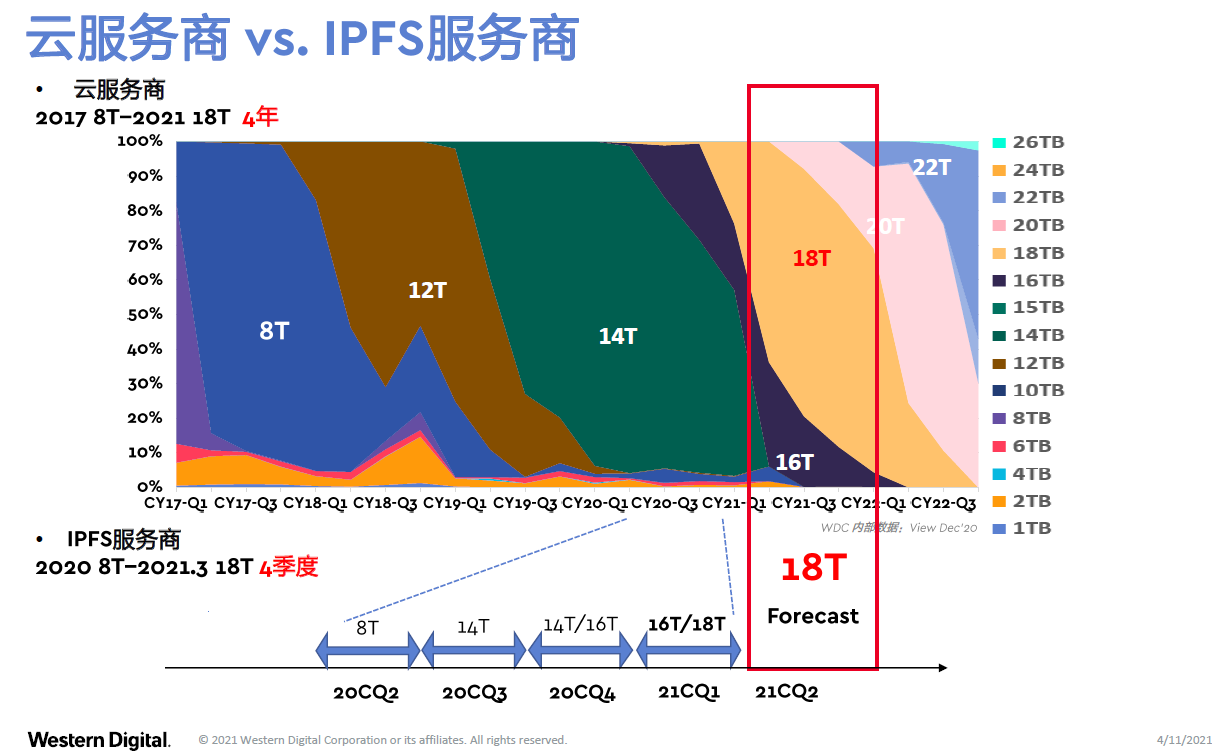

如下图所示,头部的云服务商的硬盘在过去4年当中,从8T进化到了18T。IPFS的服务商则在以更快的速度进化。“他们几乎在过去四个季度就走完了云服务商过去四年硬盘的演进过程,也从8T进化到了18T。IPFS用了四个季度走完了过去云服务商四年对存储容量点的进化。”刘钢说。

为什么大家会从8T进化到12T、14T、16T,很快就过渡到了18T呢?从下图来看就更清楚了。

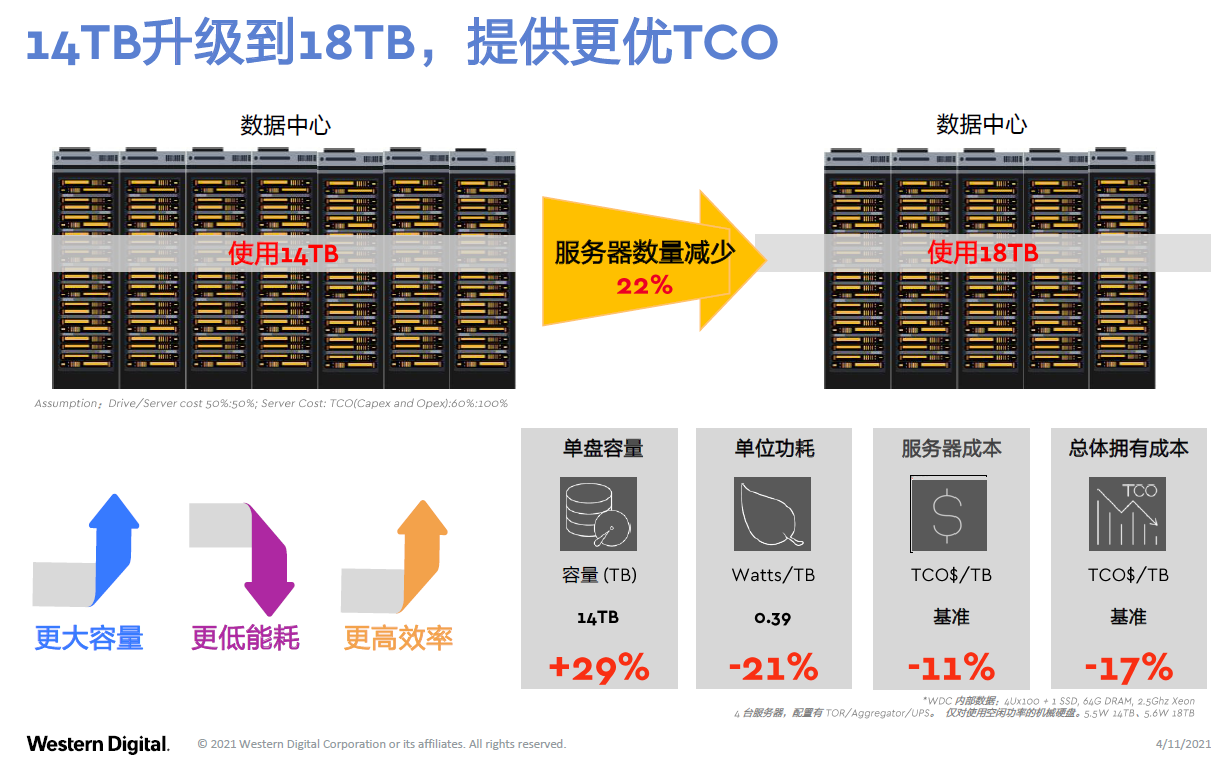

举个简单例子,市场上还流行14T,也有些人用16T,为什么今天会到18T呢?“当数据中心只是从14T升级到18T,为了达到同样存储的容量,你的服务器数量会减少约22%。不只是服务器数量减少了,存储密度提高了,而且单位功耗还降低了约21%。所以部署成本降低了,你的运维成本也降低了。”刘钢说。

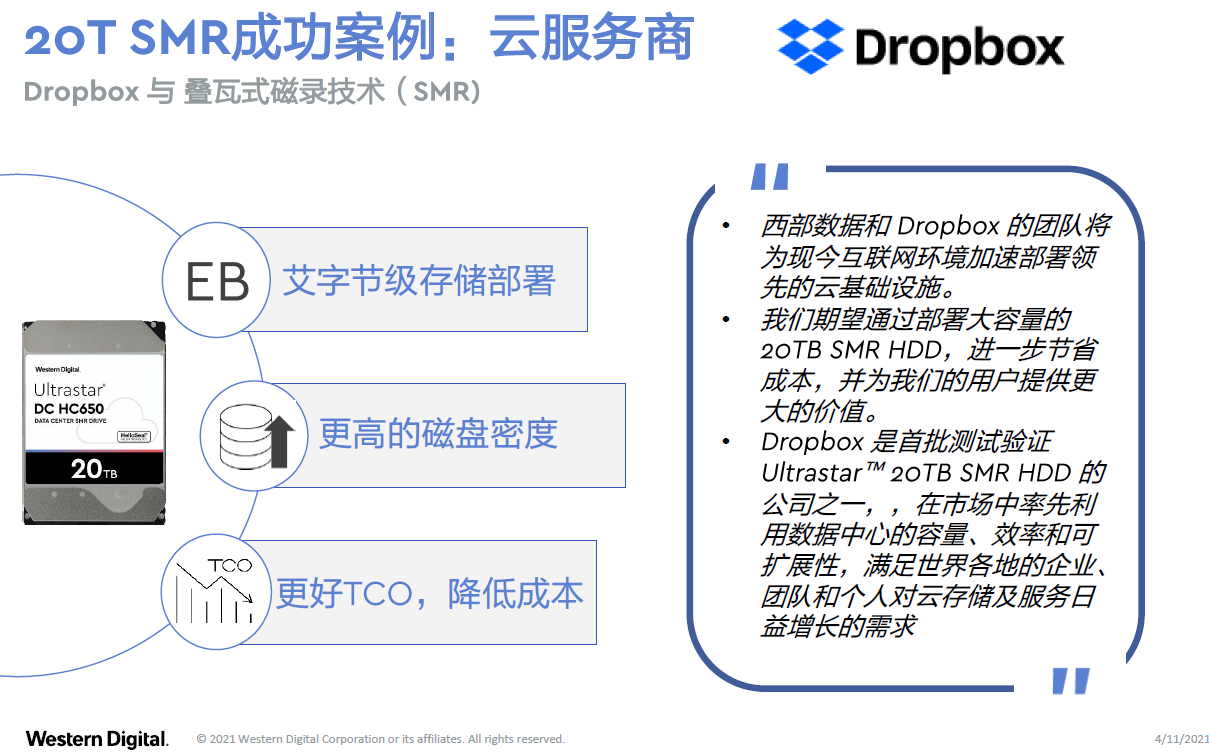

很多IPFS公司或者云服务商已经在考虑从本季度开始迁移到18T高密度的硬盘上面。还有公司利用软件技术已经开始部署20T的SMR HDD。比如Dropbox,全球领先的云存储服务商,它在去年年底就已经迁移到20T SMR HDD了。通过迁移到20T SMR,它得到了更低的总体拥有成本(TCO)与更高的存储密度。

除了上述大数据的部分,对于用户需要能够快速访问数据的快数据这部分又是怎么样呢?热存储和温存储这两个部分可以使用两类SSD:一类是主流的SSD,还有一类是针对写密集、计算密集的高性能SSD(分别对应下图中的Ultrastar DC SN840 NVMe SSD和Ultrastar DC SN640 NVMe SSD)。应用到IPFS里,尤其是针对封装计算机、封装服务器的时候,4个7.68T的SSD能提供非常好的加速。

刘钢指出,在我们考虑一家SSD供应商的时候,有三个问题需要进行考虑:

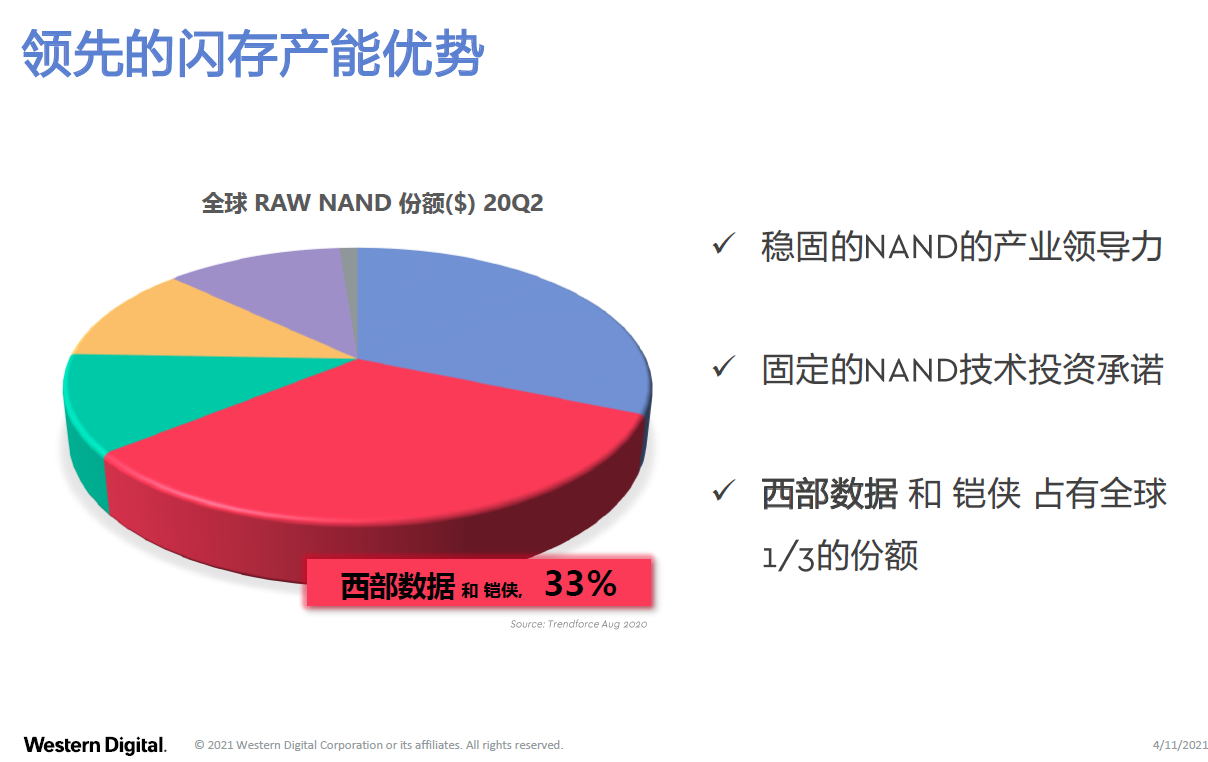

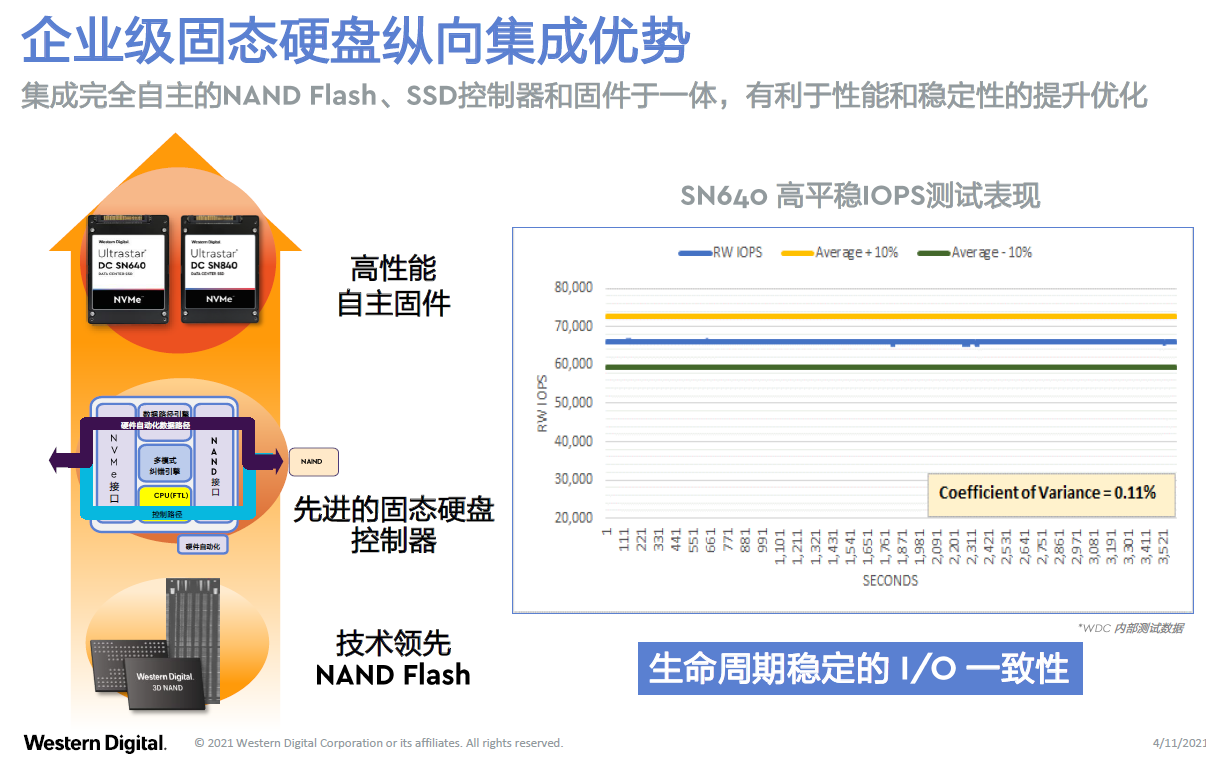

SSD今天主要的容量点是3.84T和7.68T,其主要成本是在闪存(Flash),Flash会决定它的成本和性能。因此,一家SSD的供应商需要有大规模的产能,能够保证供应,同时能够降低成本。还要有领先的Flash技术,能够提供高性能Flash,有自主可控的控制器和部件来纵向地优化SSD的产品,提供一致稳定的高性能,而不只是某个时间的高性能或者峰值的高性能,刘钢说。

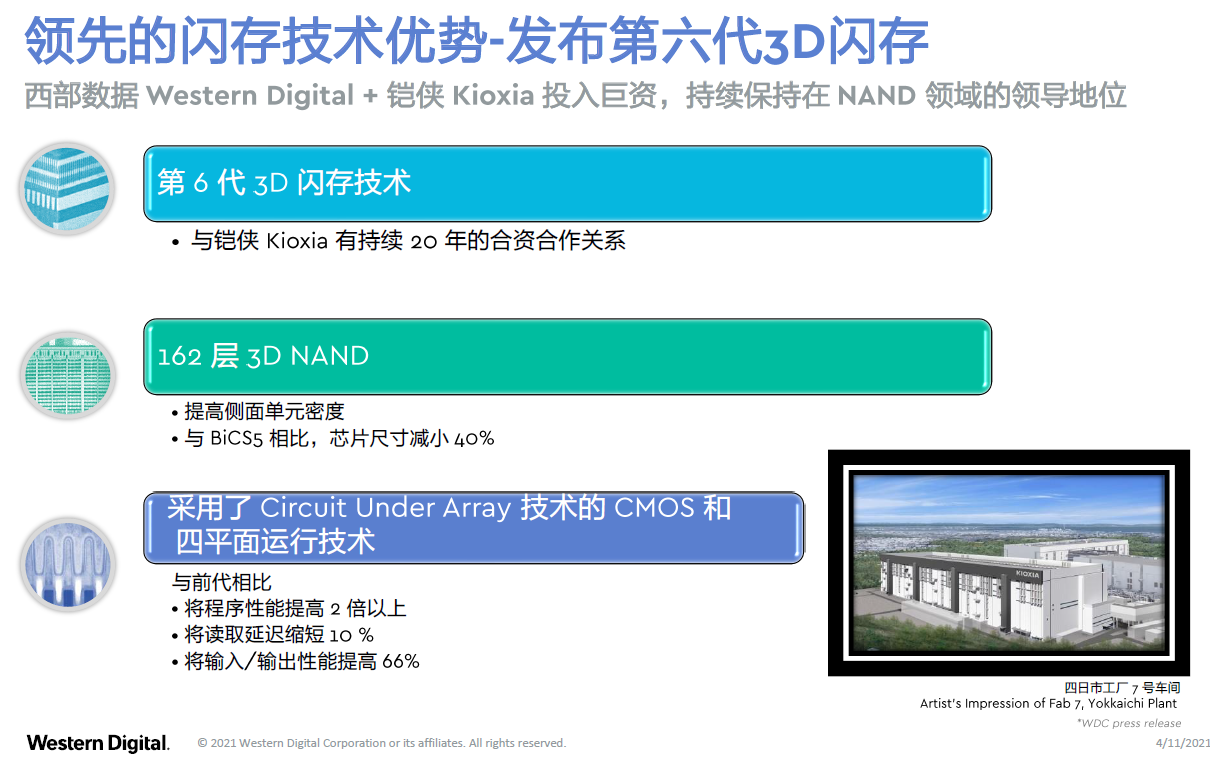

西部数据和铠侠合资的工厂,有全世界最大的Flash产能,大概占全世界Flash产能的33%,也即约1/3的Flash产能是西部数据和铠侠的。另外也刚刚发布了第6代3D闪存技术,162层的3D闪存技术,会进一步地缩小芯片的尺寸,降低成本、提高性能。它的程序性能可以提高两倍以上,输入输出的IOPS提高约66%,是其最新一代的Flash技术。

另外就是纵向集成的优势。“我们有控制器和它的固件,和我们的flash纵向集成,达到非常稳定的一致性。”刘钢继续介绍说,“有一家大型电商客户,他给出的要求是SSD的波动范围不能超过大约10%波动,而用我们产品测出来的数据是0.11%。它用的就是Ultrastar DC SN640 NVMe SSD,7.68T的SSD,不仅有高性能,最关键是有超级稳定(consistently amazing)的高性能。这个应用到封装服务器里面比较合适。”

总的来说,针对用户的分层,西部数据有不同的产品满足用户在不同层数据的存储需求。海量数据存储或快数据存储会有不同的产品满足。

如果把这样的存储架构和存储技术用到IPFS或Web3.0的场景里会是什么样的应用?

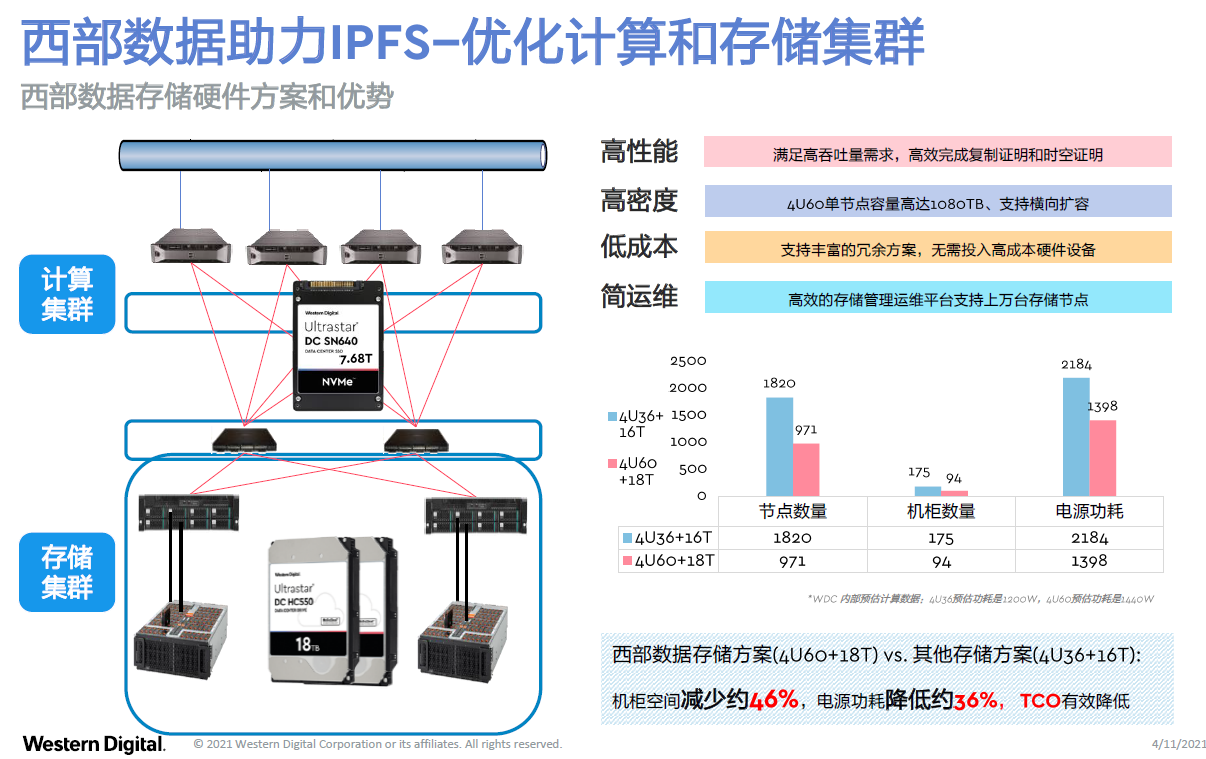

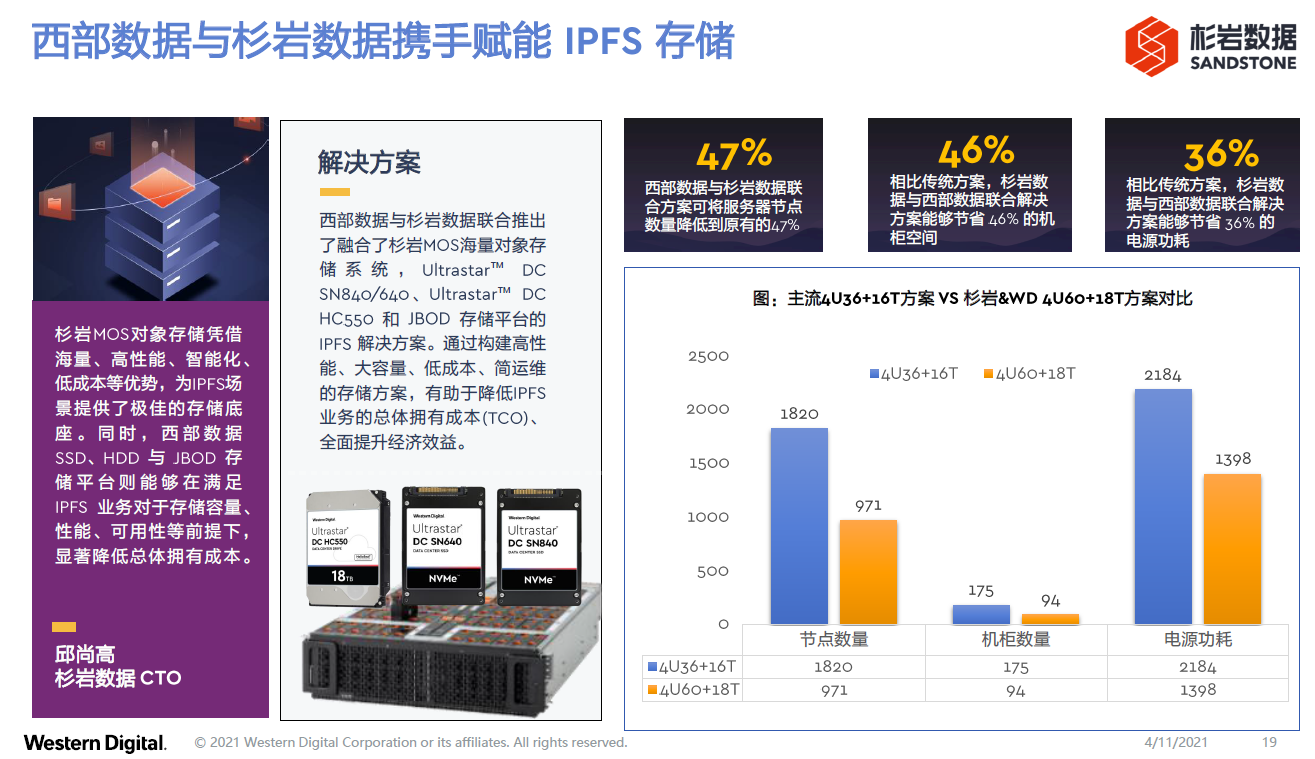

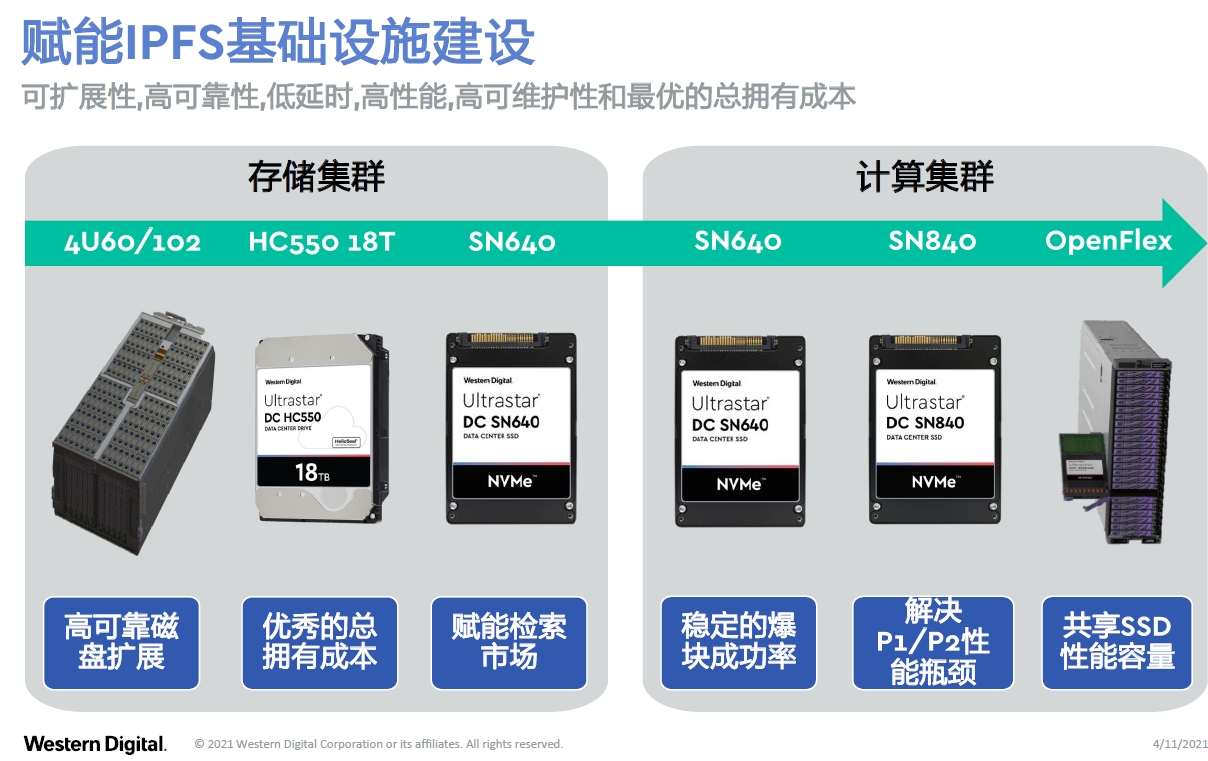

首先在IPFS层面,“存算分离”已经是共识了。在计算集群里面有7.68T的SSD,在存储集群里面推荐用18T的高密度硬盘,得到的效果是什么样呢?当我们用4U60+18T的配置,与原来传统的4U36+16T配置相比,机柜数减少了约46%,功耗减少了大约36%,大规模地降低了部署成本和运维成本。

西部数据的展台还有好几家合作伙伴同步展出,利用西部数据的存储技术提供针对IPFS的领先解决方案。例如,星辰天合(XSKY)和浪潮联合推出的IPFS解决方案,与从前的方案相比,提高了性能,降低了成本。

杉岩,一家领先的分布式存储软件提供商,采用了不只是西部数据的高密度硬盘,同时也采用了西部数据高密度的4U60存储扩展机柜,来提高密度和降低成本,并且获得了高可靠性和高稳定性。

长城超云,不仅在存储集群里使用了西部数据的产品,同时在计算集群里也使用了Ultrastar DC SN640 NVMe SSD来提高封装的效率,获得了更高的性能和非常稳定的运行。

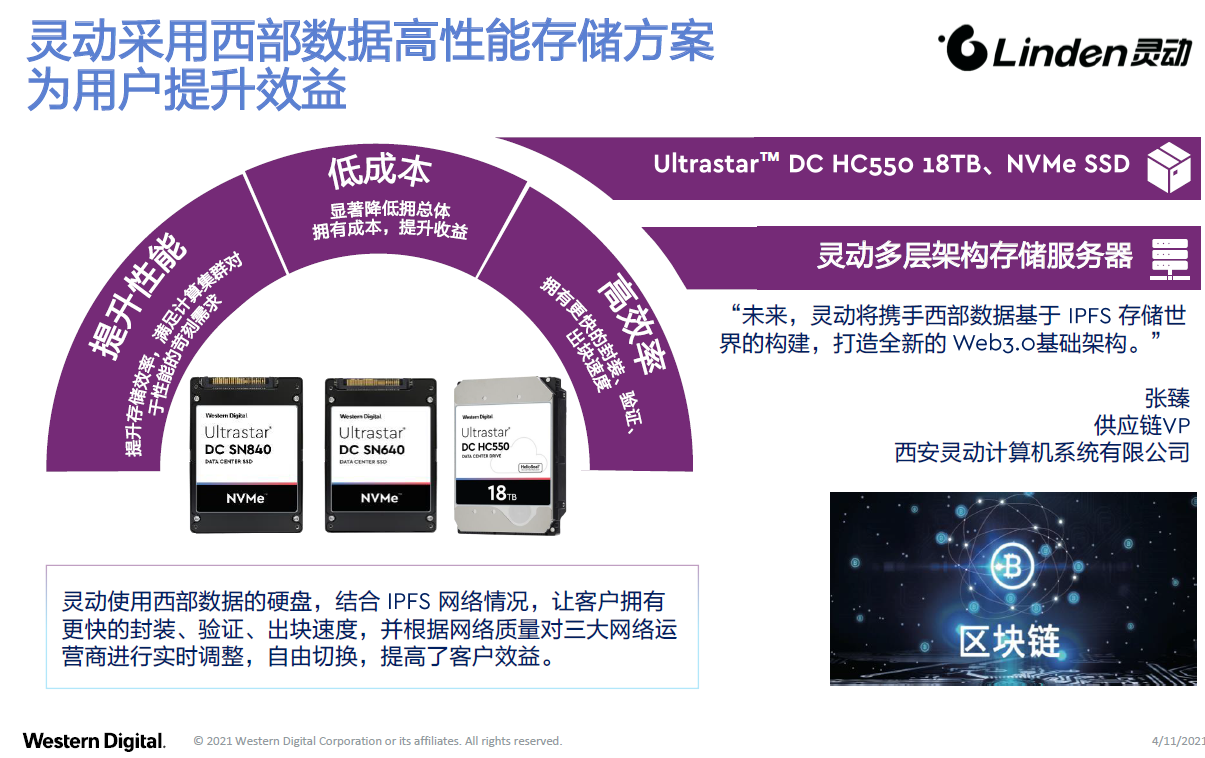

灵动,一家IPFS分布式存储服务器制造商,也在计算机群和存储机群里采用了针对快数据的存储方案和针对大数据的存储方案——7.68T的SSD和18T的高密度硬盘。

因此,总的来讲,针对Web3.0或IPFS的基础设施架构,针对它的存储集群,可以提供高密度的磁盘扩展柜、大容量的18T硬盘,还有Ultrastar DC SN640 NVMe SSD来作为缓存。针对它的计算集群,西部数据有Ultrastar DC SN640 NVMe SSD,还有Ultrastar DC SN840 NVMe SSD写密集型的SSD,尤其是针对P1和P2。

“同时,非常重要的一点,我们也发现在有很多计算节点的时候业界在把P1和P2功能的服务器进行拆分。因为P1是可以并行的,P2是不能并行的。当你达到一定规模,在对P1、P2进行拆分的时候,你会发现虽然计算性能提高了,但是这两个节点之间的数据的传输会带来一些损失。”刘钢指出,“这个时候可以采用高速的SSD缓存池,将这两类服务器通过NVMe-oF连到一个高速的闪存池。这样整个服务器群可以共享高速闪存,而不必在每一台服务器里去部署这个闪存,既降低了成本,同时也提高了P1的并发效率,和P2跟P1之间数据传输的能力。因此,尤其针对大规模的IPFS分布式存储服务器制造商,当节点达到100PB以上的时候,可能需要进一步用存储技术来优化存储技术架构。”

因此,总的来说,西部数据作为一家专注于存储技术的提供商,同时也是来自硅谷、在存储领域深耕了51年的存储提供商,提供的存储技术和产品是从芯片到系统,适用的场景从消费者级的手机、相机到个人电脑、自动驾驶,到企业级和云端的计算和存储节点,拥有全线的多场景的存储技术和产品。

最前沿的电子设计资讯

最前沿的电子设计资讯