三星在使内存处理 (PIM) 技术成为主流方面又迈出了一步。其支持 PIM 的高带宽内存 (HBM-PIM) 首次成功集成到商业化加速器系统中,这是将 PIM 技术集成到其他内存类型的愿景的一部分。

今年2月,三星推出了其首个HBM-PIM(Aquabolt-XL),将AI处理能力整合到三星HBM2 Aquabolt中,以增强超级计算机和AI应用的高速数据处理能力。随后,HBM-PIM在赛灵思(Xilinx)Virtex Ultrascale+(Alveo)AI加速器中进行了测试,它提升了近2.5倍的系统性能,并降低超过60%的能耗。

三星内存业务部高级副总裁 Nam Sung Kim 概述了公司如何看待带有 HBM2-PIM 的 Aquabolt-XL 用于机器学习(ML ) 加速器和其他人工智能 (AI) 应用。

他表示,由于各种物理和热限制,新兴 ML 和 AI 应用的内存带宽需求快速增长,且更加昂贵和耗电。“由于PCB导线和芯片封装、及功率的限制,继续增加带宽变得非常困难和昂贵。”

图:Nam Sung Kim。

Kim 表示,通过让处理器更接近内存,PIM 可以提高受内存限制的工作负载的性能和能源效率。

虽然PIM 并不是一个新想法,但对主机处理器和/或应用代码进行必要更改是阻碍行业广泛采用的一个关键障碍。

Aquabolt-XL瞄准是低算术密度的内存绑定负载,例如语音识别和自然语言处理,但 Kim 表示它并不打算与 AI 加速器中的机器学习竞争。相反,它旨在补充处理器的计算能力。“我们可以针对各种工作负载提高系统的性能和效率。”

图:三星的 Aquabolt-XL HBM2-PIM 的架构是 HBM2 的直接替代品,并与符合 JEDEC 的 HBM2 内存控制器完全兼容。(图片来源:三星)

图:三星的 Aquabolt-XL HBM2-PIM 的架构是 HBM2 的直接替代品,并与符合 JEDEC 的 HBM2 内存控制器完全兼容。(图片来源:三星)

PIM应用之外的HBM

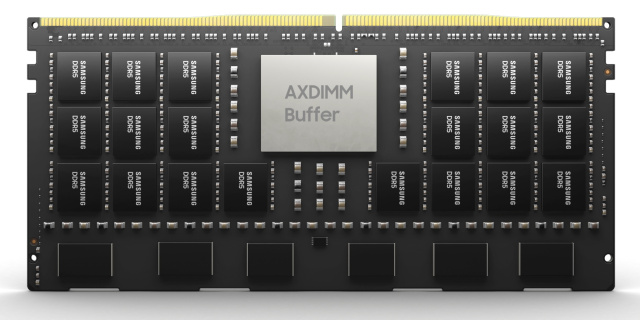

三星也在 HBM 之外寻找 PIM 应用程序。Kim 表示,公司正在使用 PIM 以加速 DIMM (AXDIMM) 的形式为 DRAM 模块本身提供处理能力。这最大限度地减少了 CPU 和 DRAM 之间的大量数据移动,以提高 AI 加速器系统的能效。

由于 AI 引擎内置于缓存芯片内部,AXDIMM 可以并行处理多个内存列(一组 DRAM 芯片),而不是一次只访问一个列。

图:与 HBM-PIM 一样,三星的 AXDIMM 可以作为 DRAM 替代品使用,无需任何系统修改,并且在缓存芯片中内置了一个 AI 引擎来执行多个内存列的并行处理。(图片来源:三星)

图:与 HBM-PIM 一样,三星的 AXDIMM 可以作为 DRAM 替代品使用,无需任何系统修改,并且在缓存芯片中内置了一个 AI 引擎来执行多个内存列的并行处理。(图片来源:三星)

胡安节选编译自 EETimes,Samsung Expands PIM Ambitions 。

最前沿的电子设计资讯

最前沿的电子设计资讯