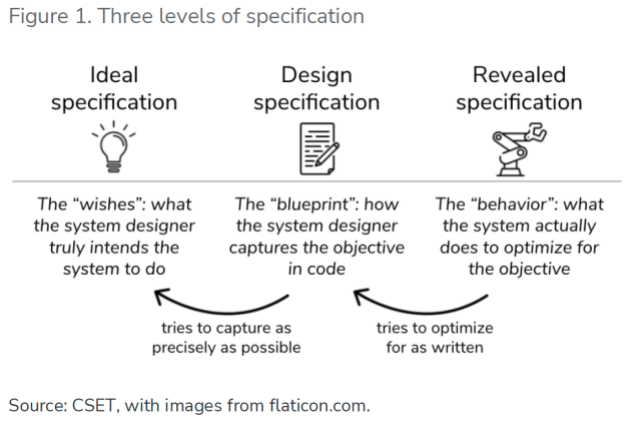

设计机器学习应用程序的一个关键挑战,是在软件程序代码当中精确地描述开发者想要系统执行的工作。美国乔治敦大学Georgetown University)安全与新兴技术中心(Center for Security and Emerging Technology)不久前发表的一篇论文作者强调,克服机器学习的规格描述挑战,是迈向更高人工智能(AI)安全性的关键步骤。

上述论文作者将AI安全性规格(specification)定义为在程序代码中传达机器学习系统应该要执行之工作的详细描述,或者他们所称的“人类特有目标”(human-specific objective)。一个例子是在排列的图片方块中找出“红绿灯”的CAPTCHA图砖验证系统(EETT编按:在一些网站可以见到,用以区分机器人与人类的验证步骤)。而像是训练模型的步骤规则未包括在内。

为了让机器学习能辨识各种图形,开发人员会详述关键目标。该目标函数代表一套学习算法的核心成分,阐述一个模型在搜集更多的训练资料时该如何学习。

为机器学习订定明确目标是确保AI安全性关键。

而在开发者试图从功能有限的应用程序迈进更具挑战性的真实世界应用程序之同时,AI安全性规格是研究人员最关注的议题之一。上述乔治敦大学论文的共同作者Helen Toner在接受访问时表示:“已经有越来越多基础研究聚焦于AI安全性与可靠性,以及对AI性能的理解。”

她指出:“那些AI系统的可解释性(interpretability),在此是另一个真正有用的输入,能让你了解,依据应用以及哪一类保证是你所需要的,是否有更好的方法从概念上去了解这些系统里面到底发生什么事情,这也是相当有价值。在我看来,这是此堆栈底部的基础科学部份。”

随着机器学习逐渐演进,从产品推荐等较狭窄的应用,发展到诸如自动驾驶等关键性任务,对于安全性规格的需求也跟着成长。“当机器学习系统变得更先进,将会被配置在越来越复杂的环境,以执行日益复杂的任务;”论文作者指出:“这时候规格问题可能会开始变得棘手。”

该作者指出,对开发者来说,更大的责任是以新的方法在程序代码中传达其意图,让机器学习服从“被赋予的规则之字面意义,并非精神。”包含人类监督或迈向预测最坏情况之步骤的算法,被推荐做为一个克服“错误设定规格”的方法。

还需要的是更多研究,了解开发人员如何在程序代码当中传达细微、复杂的目标,并确保他们所设计的系统能够达成这些目标。而在那之前,论文作者警告,机器学习仍应该被局限在“狭窄、严格规范的设定中。”

(参考原文:Specifying Objectives is Key to AI Safety,本文同步刊登于《电子工程专辑》杂志2022年1月号)

最前沿的电子设计资讯

最前沿的电子设计资讯