EDN电子技术设计的读者们,是否还记得售价数百万美元的“全球最大AI芯片”?EDN在去年报道过Cerebras推出的这款基于台积电7nm的第二代产品Wafer Scale Engine,其内核数量增加了2倍多。更多详细内容:世界上尺寸最大的芯片Wafer Scale Engine发布第二代,售价“数百万”美元

今日,这家公司又官宣了新消息!

Cerebras Systems公司近日宣布,在基于单个Wafer Scale Engine-2芯片的CS-2系统上训练了世界上最大的拥有200亿参数的NLP(自然语言处理)人工智能模型。这也使得它能够适应,目前网络上非常热门的基于文本创建图像的OpenAI的120亿个参数的DALL-E的神经网络模型。

由Cerebras训练的人工智能模型攀升到一个独特的、惊人的200亿个参数。 Cerebras无需在多个加速器上扩展工作负载就完成了这一操作。 Cerebras的成功对于机器学习至关重要,因为与以前的模型相比,软件需求的基础设施和复杂性降低了,显著降低了原本需要数千个GPU 训练的成本(以及相关的硬件和扩展要求),同时消除了在它们之间划分不同版本模型的技术困难。

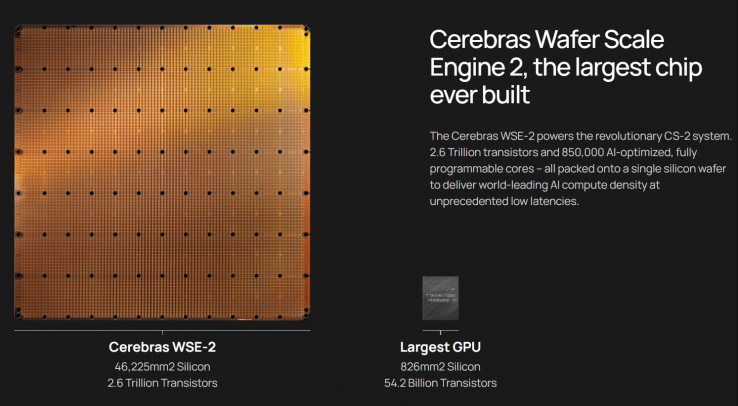

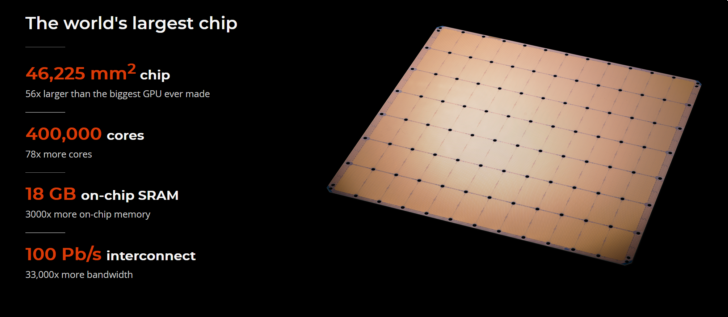

“Wafer Scale Engine-2”的制程工艺由台积电16nm工艺提升到了7nm工艺,基于一整张12英寸的晶圆制造,面积是462.25平方厘米,相当于市面上数百种高级芯片,拥有2.6万亿个7纳米晶体管。 除了晶圆和晶体管外,Wafer Scale Engine-2还包含85万个核心和40 GB集成缓存,,内存带宽由9PB/s提高到了20PB/s,结构带宽高达220PB/s,功耗为15kW,各项指标均打破首代WSE 处理器创造的世界纪录。

资料显示,OpenAI 的 GPT-3 是一种 NLP 模型,可以编写有时可能会欺骗人类读者的整篇文章,具有惊人的 1750 亿个参数。DeepMind 的 Gopher 于去年年底推出,将这个数字提高到 2800 亿。Google Brain 的大脑甚至宣布训练一个超过万亿参数的模型 Switch Transformer。

如果将CS-2所达成训练200亿参数的NLP人工智能模型的成就与上述更大规模的人工智能模型相比,CS-2的成就似乎平淡无奇。但是,事实上,CS-2大幅降低超大规模人工智能模型训练门槛。

Cerebras的成就是特别重要的,因为研究人员将发现,他们将能够在新的Wafer Scale Engine-2上计算和创建逐渐精细的模型,而其他人不能。

大量可行参数背后的技术使用了该公司的Weight Streaming技术,允许研究人员“解耦计算和内存占用,允许内存扩展到存储AI工作负载中快速增长的参数所需的任何数量。” 反过来,设置学习所需的时间将从几个月减少到几分钟,只需要几个标准的命令,允许在GPT-J和GPT-Neo之间完美切换。

最前沿的电子设计资讯

最前沿的电子设计资讯