从主机厂的自动驾驶技术搭载情况来看,其感知技术方案大致可分为两类:一种是基于视觉的自动驾驶系统,另一种是基于雷达+视觉的自动驾驶系统。后者主要使用雷达传感器来检测物体,而视觉系统则完全基于摄像头。从当初传统的tier1(如博世、大陆等)倾向于搭载简单低成本的毫米波雷达系统用于实现基础的辅助驾驶功能。而诸如特斯拉这类高尖端的主机厂更是从最初的视觉方案到后面引入雷达传感器,再到放弃雷达回归纯视觉方案,经历了多次反复。包括国内很多主机厂也将很大程度的研发精力放在了对视觉感知上。通过利用计算机视觉系统检测、识别物体,利用不同的神经网络模型检测不同的对象模型,一旦判断失误,就会导致事故。基于视觉的自动驾驶系统需要强大的软件算法能力,以及大量数据对AI模型的长期训练。这显然不是一朝一夕可以实现的。

然而,除了感知软件这一难题外,我们对于感知前端的摄像头硬件模组又了解多少呢?本文将系统的介绍摄像头前端感知模组的相关技术参数及评价指标。

摄像头模组相关选型介绍

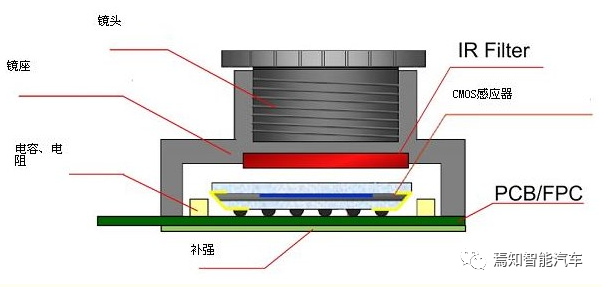

摄像头模组CCM主要由镜头(lens)、镜座、红外滤光片(IR Filter)、传感器(Sensor)、PCB板、FPC柔性电路板等结构组成,是影像捕捉至关重要的电子器件。

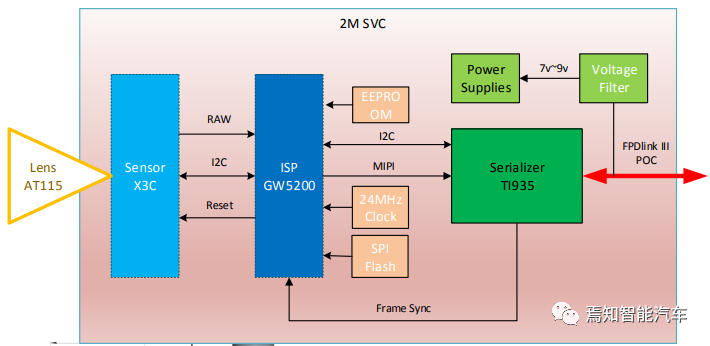

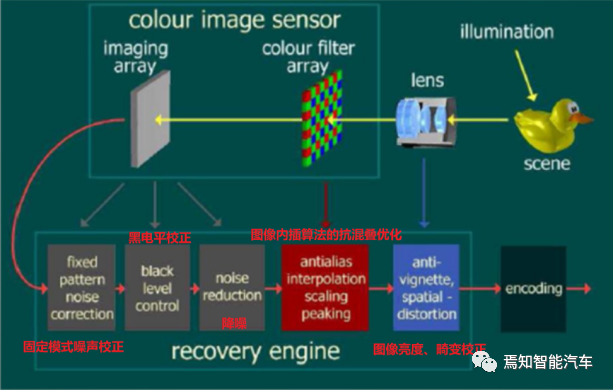

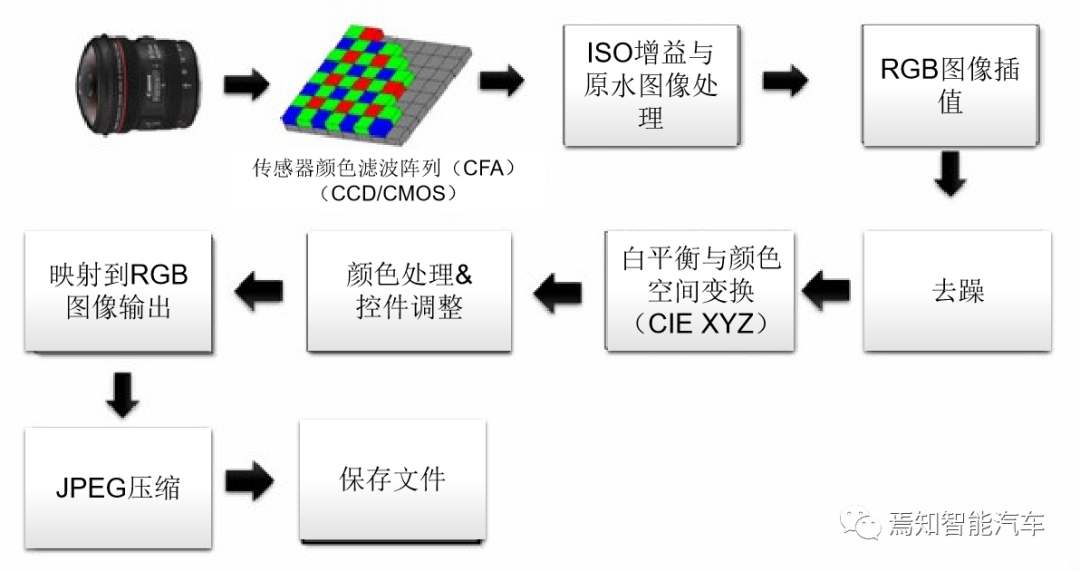

基本原理是通过外部光线照射在物体上,经过反射、折射后穿过镜头(Lens),再经过滤光片滤波投射到图像传感器(Sensor)感光面上。其基础原理是通过Sensor将Lens上传导过来的光线转换为电信号,经过内部图像处理器(ISP)转换成数字图像信号输出到数字信号处理器(DSP)加工处理,转换成标准的GRB、YUV等格式图像信号。若Sensor内部未集成ISP,则通过DVP的方式传输到图像处理器,此时的数据格式为RAW RGB(原始数据)。

1)镜头(lens)

镜头相当于人眼中的晶状体,利用透镜的折射原理,景物光线透过镜头在聚焦平面上形成清晰的像。Camera的镜头结构一般是有几片透镜组成的,透镜分为塑胶透镜(Plastic)以及玻璃透镜(Glass),常用的镜头结构有:1P、2P、1G1P、1G3P、2G2P等。

透镜越多,成本越高,成像效果也越好(光线更均匀、更细致;对光线的选通更丰富;成像畸变更小,但是会导致镜头变长,光通量变小),玻璃透镜的透光率、感光性比塑胶透镜的要好,但价格也更贵。

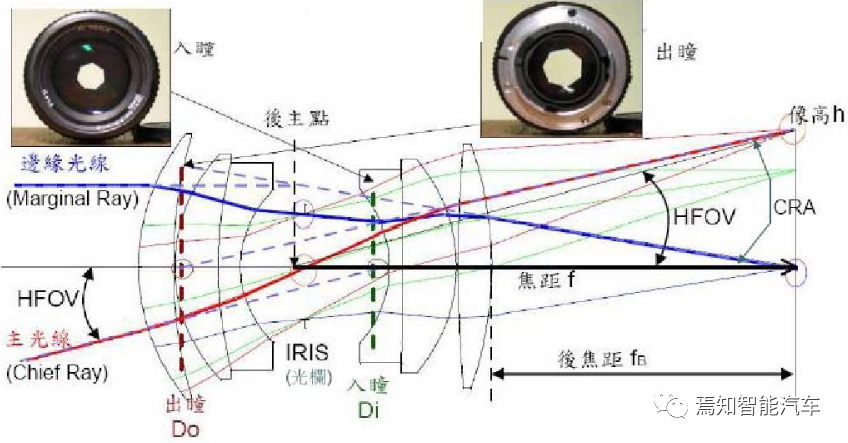

镜头的关键指标就是镜头的焦距,通常根据镜头焦距的不同,进行不同的分类。镜头的焦距决定了该镜头拍摄的物体在Sensor上所形成影像的大小,焦距越短,拍摄范围就越大,也就越接近广角镜头;焦距越长,镜头的视角越小,拍摄到景物的范围也就越小,也就越接近窄角摄像头。通常会把短焦距、视场角大于50°(如f=3mm左右)的镜头,称为广角镜头,如前视120°摄像头;把更短焦距(如f=2.8mm)的镜头叫走超广角镜头,如环视摄像头;而把焦距很长(如f>80mm)的镜头称为望远镜头,如智驾域经常用到的30°远摄摄像头。介于短焦与长焦之间的镜头就叫做标准镜头,如智驾域的侧视摄像头。

镜头的焦距、视场大小及镜头到被摄取物体的距离计算公式如下:

f = w*D / W f = h*D / H

其中:f—镜头焦距,w—图像的宽度(被摄物体在Sensor靶面上的成像宽度),W—被摄物体宽度,D—被摄物体距离镜头的距离,h—图像高度(被摄物体在Sensor靶面上的成像高度),H—被摄物体的高度。

镜头尺寸一般可分为25.4mm(1inch)、16.9mm(2/3inch) 、12.7mm(1/2inch) 、 8.47mm(1/3inch)和 6.35mm(1/4inch)等几种规格 。选用镜头时,应使镜头尺寸与摄像机的靶面尺寸大小相吻合,并注意这样一个原则,即小尺寸靶面的图像Sensor可使用大尺寸的镜头,反之则不行。如1/2”的Sensor采用1/3”的镜头,则进光量会变小,色彩会变差,甚至图像也会缺损;反之,则进光量会变大,色彩会变好。

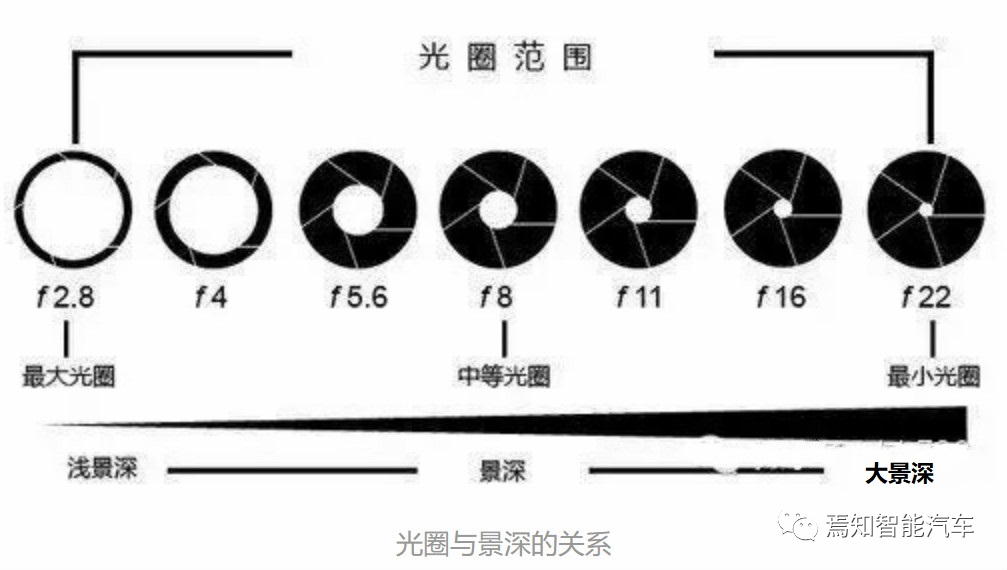

此外,我们还比较关心的是镜头通光孔径大小对镜头的影响。通常,通光孔径越大,通过的光量越大,但我们关心的是到达Sensor的光量。焦距越长,意味着Sensor离镜头中心越远,相应的光就越弱,所以,标准光圈大小的参数应该与两个变量有关:即孔径,焦距。

可以定义光圈的相对孔径等于镜头的有效孔径与镜头焦距之比,镜头的相对孔径表征了镜头的通光能力,相对孔径越大,通光越多。

光圈系数F = 焦距(f) / 镜头有效孔径 (D)

光圈相对孔径 = 镜头有效孔径 (D) / 焦距(f)

即F = 1 / 光圈相对孔径

所以,选用相对孔径大的镜头,可以降低对景物照明条件的要求。

最后,对于摄像头来说,主要还涉及到相关的镜头接口。常规的接口镜头主要包括 C接口镜头(C-Mount)与CS(CS-Mount)接口镜头。两者最明显的区别就是镜头与摄像机接触至摄像机感光元器件(CCD/COMS传感器)的位置(焦平面)的距离不同。这个距离专业的术语叫做法兰焦距。C接口的法兰焦距为17.5mm,CS接口的法兰焦距为12.5mm。在镜头的使用过程中,通常是C型标准摄像机接C接口镜头,CS镜头接CS型摄像机。但是在使用的过程中C接口镜头可以加装一个5mm厚的延长环与CS型摄像机搭配使用,C接口镜头不加延长圈则会导致镜头碰到传感器靶面,造成传感器损坏。CS型镜头与C型摄像机无法配合,CS镜头与C型摄像机不能组合使用的原因是镜头成像面与CCD受光面距离太远,不能得到聚焦的图像。

2)红外滤光片(IR Filter)

红外滤光片的主要作用是透过人眼可见光波段(380~700nm),滤除掉入镜头中的红外光,这是因为人眼看不到红外光,但是sensor却能感受到红外光,所以需要将光线中的红外光滤掉,防止Sensor产生偏色、波纹,以提高色彩还原度,使图像更接近人眼看到的效果。但对于夜视系统,Sensor需要接收物体发出或反射的红外光线进行成像,此时镜头模组中就不需要红外滤光片了。

3)图像传感器(Sensor)

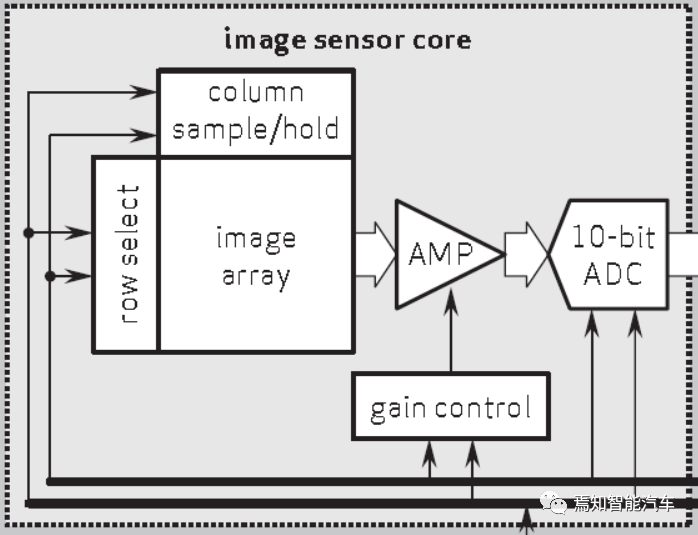

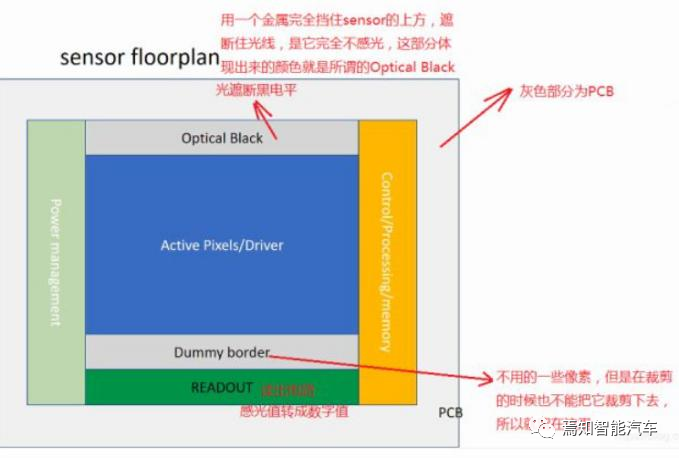

Sensor是摄像头的核心,负责将通过Lens的光信号转换为电信号,再经过内部AD转换为数字信号。每个pixel像素点只能感受R、G、B中的一种,因此每个像素点中存放的数据是单色光,所以我们智驾系统常用的200万像素或者800万像素,表示的就是有200万或800万个感光点,每个感光点只能感应一种光,这些最原始的感光数据也就是我们常常叫做的RAW Data。

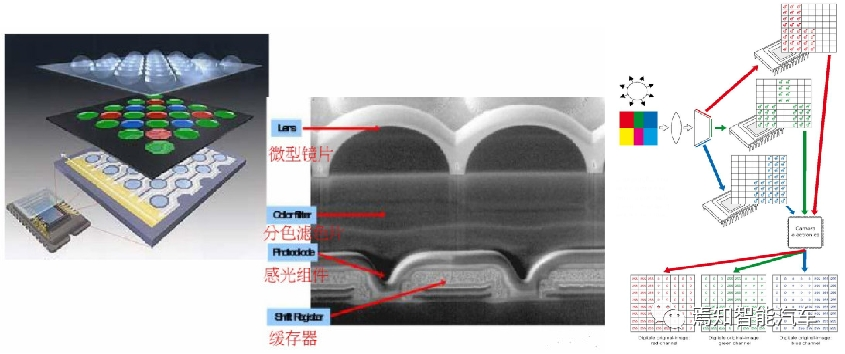

图像传感器的像素单元都分为四部分:微透镜、滤色片、感光片(光电二极管)、电荷存储区。光线照射到Sensor感光组件(光电二极管)上,光强就转换为电荷,并缓存于电荷存储区。

目前的Sensor有两种基本的类型:

CCD传感器:

电荷耦合器件传感器:使用一种高感光度的半导体材料制成,能把光线转变成电荷,通过模数转换器芯片转换成电信号。CCD由许多独立的感光单位组成,通常以百万像素为单位。当CCD表面受到光照时,每个感光单位都会将电荷反映在组件上,所有的感光单位产生的信号加在一起,就构成了一幅完整的图像。

CMOS传感器:

互补性氧化金属半导体:主要是利用硅和锗做成的半导体,使其在CMOS上共存着带N(-)和P(+)级的半导体,这两个互补效应所产生的电流可以被处理芯片记录并解读成影像。

由于结构原因,CCD Sensor只有一个ADC;而CMOS sensor有一行的ADC。这样在数据输出上,CMOS可以做到很高的帧率,而CCD却很难做到高像素和高帧率。

由此,在面向智驾系统更高帧率和高分辨率的前提下,对CMOS应用场景将越来越大。我们在对传感器Sensor选型过程中通常需要考虑如下几个重要参数:

|

参数 |

说明 |

|

传感器尺寸 |

尺寸越大,则捕获光子越多,感光性能越好,信噪比越低。常见有1inch、2/3inch、1/2inch、1/3inch、1/4inch等。 |

|

有效像素 |

有效像素阵列是指在sensor的水平H和垂直V方向上,分别含有的有效像素点的个数,很多时候,并不是所有感应器上的像素都能被运用。通常其余部分被用来表示黑色,H与V的乘积一般等于或大于分辨率数值。 |

|

动态范围 |

为输出信号峰值电压与均方根噪声电压之比,用dB表示,表征Sensor在一幅图像里面能够同时体现高光和阴影部分内容的能力。 |

|

灵敏度 |

Sensor被光均匀的照射时,当照度是1LUX(勒克斯:照度单位)时,在1s内,光电转换器所能达到的电压幅值的最大值。 |

|

分辨率 |

Sensor分辨率即指在单位面积上,像素的个数,数值越大,则代表像素点越多,捕获的图像细节越多,或者说图像更清晰。 |

|

信噪比 |

即信号和噪声的比例,反映了Sensor抑制噪声的能力,单位一般是dB,数值越大,说明Sensor抑制噪声的能力越强。 |

|

光谱响应特性 |

信号电压Vs、信号电流Is为入射光波长的函数,该特性反应了传感器的响应能力随波长的变化关系,决定了Sensor的光谱范围。 |

最前沿的电子设计资讯

最前沿的电子设计资讯